人工智能安全新纪元:Anthropic 升级负责任扩展政策

在人工智能快速发展的浪潮中,Anthropic,这家以 Claude 对话机器人闻名的公司,今天宣布了其负责任扩展政策(RSP)的重大更新,旨在减轻高度智能 AI 系统带来的风险。

RSP 首次发布于 2023 年,此次更新引入了新的协议,确保随着 AI 模型能力的不断提升,其开发和部署过程始终保持安全。

更新后的政策制定了具体的“能力阈值”,即 AI 模型能力达到一定程度时需要采取额外安全措施的标准。这些阈值涵盖了生物武器制造和自主 AI 研究等高风险领域,体现了 Anthropic 致力于防止其技术被滥用的决心。

除了政策更新,Anthropic 还引入了新的内部治理措施,包括任命负责任扩展官(RSO)负责监督政策执行。

Anthropic 的主动举措表明,AI 行业越来越意识到,在快速创新和严格的安全标准之间取得平衡的重要性。随着 AI 能力的加速发展,安全问题变得前所未有的重要。

Anthropic 更新的负责任扩展政策正值 AI 行业的关键时刻,此时,有益和有害的 AI 应用之间的界限越来越模糊。Anthropic 将“能力阈值”与相应的“安全保障”相结合,表明其明确意图,即防止 AI 模型造成大规模伤害,无论是恶意使用还是意外后果。

该政策重点关注化学、生物、放射性和核武器(CBRN)以及自主 AI 研究与开发(AI R&D),突出了前沿 AI 模型可能被不法分子利用或无意中加速危险进展的领域。

这些阈值就像预警系统,确保一旦 AI 模型展现出危险能力,就会在部署之前触发更严格的审查和安全措施。

这种方法为 AI 治理树立了新的标准,建立了一个框架,不仅可以应对当今的风险,还可以预测未来随着 AI 系统在能力和复杂性方面不断发展而出现的威胁。

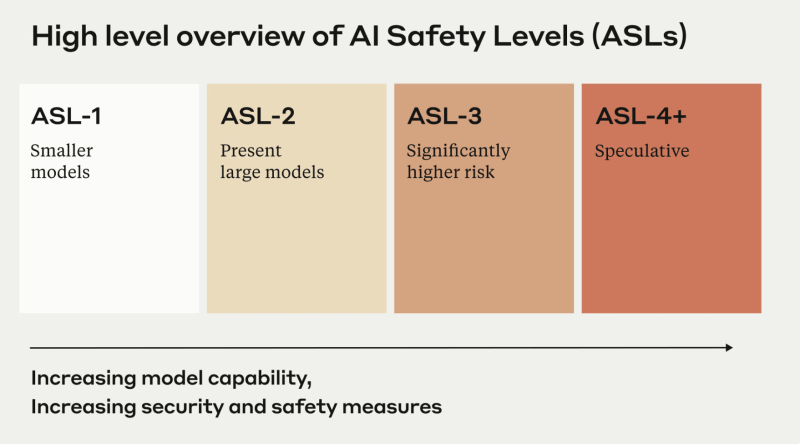

Anthropic 的政策不仅仅是一个内部治理系统,它旨在成为整个 AI 行业的蓝图。该公司希望其政策能够“可移植”,这意味着它可以激励其他 AI 开发者采用类似的安全框架。通过引入以美国政府生物安全标准为模型的 AI 安全级别(ASL),Anthropic 为 AI 公司如何系统地管理风险树立了先例。

分层的 ASL 系统,从 ASL-2(当前安全标准)到 ASL-3(对风险较高的模型提供更严格的保护),为扩展 AI 开发创建了一个结构化方法。例如,如果一个模型显示出危险的自主能力迹象,它将自动升级到 ASL-3,需要更严格的红队测试(模拟对抗性测试)和第三方审计才能部署。

如果在整个行业范围内采用,这种系统可以创造 Anthropic 所谓的“AI 安全竞赛”,公司之间不仅在模型性能方面竞争,还在安全保障方面竞争。这对于一个迄今为止不愿在如此详细的层面上进行自我监管的行业来说,可能是具有变革意义的。

Anthropic 的 AI 安全级别(ASL)根据风险对模型进行分类,从低风险的 ASL-1 到高风险的 ASL-3,ASL-4+ 预计未来会出现更危险的模型。(来源:Anthropic)

Anthropic 的 AI 安全级别(ASL)根据风险对模型进行分类,从低风险的 ASL-1 到高风险的 ASL-3,ASL-4+ 预计未来会出现更危险的模型。(来源:Anthropic)

Anthropic 更新的政策的一个关键特征是创建了负责任扩展官(RSO)职位,负责监督公司的 AI 安全协议。RSO 将在确保政策执行方面发挥关键作用,从评估 AI 模型何时越过“能力阈值”到审查模型部署决策。

这种内部治理机制为 Anthropic 的运营增加了另一层问责制,确保公司的安全承诺不仅仅是理论上的,而是得到积极执行。RSO 还将有权在 ASL-3 或更高级别所需的保障措施未到位的情况下暂停 AI 训练或部署。

在一个以惊人速度发展的行业中,这种级别的监督可能会成为其他 AI 公司的榜样,特别是那些正在开发可能在被滥用时造成重大伤害的前沿 AI 系统的公司。

Anthropic 更新的政策发布之际,AI 行业正承受着来自监管机构和政策制定者的越来越大的压力。美国和欧洲的政府正在讨论如何监管强大的 AI 系统,Anthropic 等公司正在受到密切关注,因为它们在塑造 AI 治理的未来方面发挥着作用。

该政策中引入的“能力阈值”可以作为未来政府法规的原型,为何时应对 AI 模型进行更严格的控制提供明确的框架。通过承诺公开披露“能力报告”和“安全保障评估”,Anthropic 将自己定位为 AI 透明度的领导者,而透明度是许多 AI 行业批评者所强调的缺失问题。

这种分享内部安全实践的意愿可以帮助弥合 AI 开发者和监管机构之间的差距,为大规模负责任的 AI 治理提供路线图。

随着 AI 模型变得越来越强大,它们带来的风险必然会增加。Anthropic 更新的负责任扩展政策是对这些风险的超前应对,创建了一个可以随着 AI 技术发展而演变的动态框架。该公司专注于迭代安全措施,定期更新其“能力阈值”和“安全保障”,确保其能够适应新出现的挑战。

虽然该政策目前仅针对 Anthropic,但它对 AI 行业的更广泛影响是显而易见的。随着越来越多的公司效仿,我们可能会看到 AI 安全新标准的出现,这种标准在创新与严格的风险管理之间取得平衡。

最终,Anthropic 的负责任扩展政策不仅仅是为了防止灾难,而是为了确保 AI 能够实现其改变行业和改善生活的承诺,而不会留下破坏的痕迹。