2024 年 11 月 1 日 上午 9:56

来源:Runway

订阅我们的每日和每周新闻简报,获取有关行业领先 AI 报道的最新更新和独家内容。了解更多

随着 AI 视频大战的持续升温,新的、逼真的视频生成模型几乎每周都在发布,早期领头羊 Runway 并没有在功能方面让步。

这家位于纽约市的初创公司——获得了谷歌和英伟达等公司的 1 亿美元以上投资——实际上正在部署更多新功能,使其脱颖而出。例如,今天,它为其 Gen-3 Alpha Turbo 视频生成模型推出了强大的新高级 AI 相机控制功能。

现在,当用户从文本提示、上传的图像或自己的视频生成新视频时,用户还可以比随机“掷骰子”更细致地控制 AI 生成的效果和场景的播放方式。

Gen-3 Alpha Turbo 现已提供高级相机控制功能。选择场景移动的方向和强度,让每个镜头都更加有意。

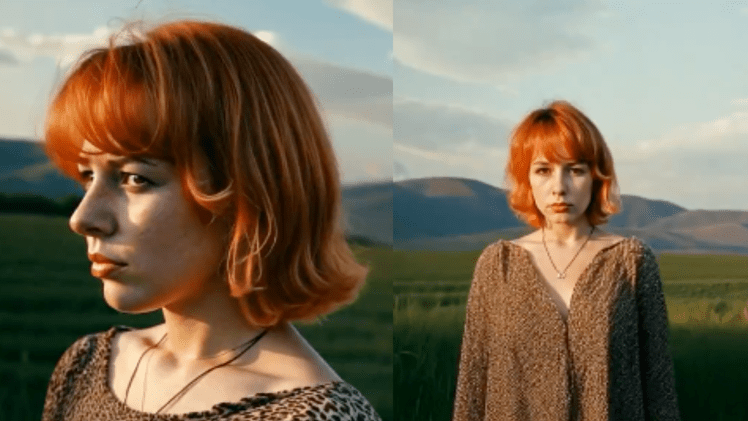

(1/8) pic.twitter.com/jRE6pC9ULn

正如 Runway 在其 X 帐户上上传的一系列示例视频中所示,用户实际上可以放大和缩小场景和主题,即使是 AI 生成的角色形式和背后的设置,也能逼真地将他们和观众带入一个完全实现的、看似 3D 的世界——就像他们在真实的电影片场或外景地一样。

正如 Runway 首席执行官克里斯托瓦尔·瓦伦苏埃拉在 X 上写道:“谁说 3D?”

这是功能上的巨大飞跃。尽管其他 AI 视频生成器和 Runway 本身之前也提供相机控制功能,但它们相对粗糙,它们生成新视频的方式通常看似随机且有限——尝试平移向上或向下或围绕主题移动有时会导致主题变形或变成 2D,或者导致奇怪的变形和故障。

高级相机控制功能包括设置移动方向和强度的选项,为用户提供细致的功能来塑造他们的视觉项目。其中最突出的功能是,创作者可以使用水平移动来平滑地绕过主题或从不同的角度探索位置,增强沉浸感和视角。

对于那些希望尝试运动动态的人来说,该工具集允许将各种相机移动与速度斜坡相结合。

此功能对于生成视觉上引人入胜的循环或过渡特别有用,提供了更大的创造潜力。用户还可以执行戏剧性的放大,以电影风格深入场景,或执行快速缩小以引入新的上下文,改变叙事焦点,为观众提供新的视角。

更新还包括慢速平移移动选项,让相机平稳地滑过场景。这提供了一种受控且有意的观看体验,非常适合强调细节或营造悬念。Runway 集成了这些不同的选项,旨在改变用户对数字相机工作的思考方式,实现无缝过渡和增强的场景构图。

这些功能现在可供使用 Gen-3 Alpha Turbo 模型的创作者使用。要探索高级相机控制功能的全部范围,用户可以访问 Runway 的平台 runwayml.com。

虽然我们还没有尝试新的 Runway Gen-3 Alpha Turbo 模型,但展示其功能的视频表明,控制精度有了很大提高,应该可以帮助 AI 电影制作人——包括来自主要传统好莱坞工作室(如 Runway 最近与之合作的狮门影业)的电影制作人——比以往更快、更经济、更无缝地实现主要电影质量的场景。

当 VentureBeat 通过 X 上的直接消息询问 Runway 是否开发了 3D AI 场景生成模型——这是目前其他来自中国和美国的竞争对手(如 Midjourney)正在追求的目标——瓦伦苏埃拉回答道:“世界模型 :-).”

Runway 最早在 2023 年 12 月——几乎一年前——就提到了它正在构建旨在模拟物理世界的 AI 模型,当时联合创始人兼首席技术官(CTO)阿纳斯塔西斯·格尔曼迪斯在 Runway 网站上发布了关于该概念的文章,其中写道:

“世界模型是一种 AI 系统,它构建了环境的内部表示,并使用它来模拟该环境中的未来事件。世界模型的研究迄今为止一直集中在非常有限和受控的环境中,无论是玩具模拟世界(如电子游戏)还是狭窄的上下文(如为驾驶开发世界模型)。通用世界模型的目标是表示和模拟各种情况和交互,就像在现实世界中遇到的那样。“

正如今天公布的新相机控制功能所证明的那样,Runway 在构建此类模型并将其部署给用户的道路上已经走得很远了。