轻量级 AI 模型的曙光:Falcon 3 开启新篇章

在人工智能领域,大型语言模型(LLM)的热潮席卷全球,但其庞大的规模和高昂的计算成本也成为阻碍其广泛应用的瓶颈。而近年来,小型语言模型(SLM)凭借其高效、经济和易于部署的特点,逐渐成为人工智能领域的“新宠”。

近日,由阿联酋政府支持的技术创新研究院(TII)发布了 Falcon 3,这是一款开源的小型语言模型家族,旨在为开发者、研究人员和企业提供更便捷、更经济的 AI 能力。Falcon 3 提供了四种不同规模的模型:1B、3B、7B 和 10B,并分别提供基础模型和指令模型,满足不同场景的需求。

Falcon 3 的出现,标志着轻量级 AI 模型的时代已经到来。它不仅能够在资源有限的设备上运行,还能在各种应用场景中发挥重要作用,例如客户服务、医疗保健、移动应用程序和物联网等。据 Valuates Reports 的预测,未来五年,小型语言模型市场将以近 18% 的复合年增长率快速增长。

Falcon 3 家族在训练过程中使用了 14 万亿个词元,是其前身 Falcon 2 的两倍多。它采用了一种仅解码器的架构,并利用分组查询注意力机制来共享参数,从而最大限度地减少推理过程中键值(KV)缓存的内存使用。这种设计使得 Falcon 3 在处理各种文本任务时能够更加高效、快速。

Falcon 3 支持四种主要语言:英语、法语、西班牙语和葡萄牙语。它还配备了 32K 上下文窗口,能够处理长文本输入,例如长篇文档。

TII 在其网站上指出:“Falcon 3 具有多功能性,适用于通用任务和特定任务,为用户提供了极大的灵活性。其基础模型非常适合生成式应用,而指令模型则擅长对话式任务,例如客户服务或虚拟助手。”

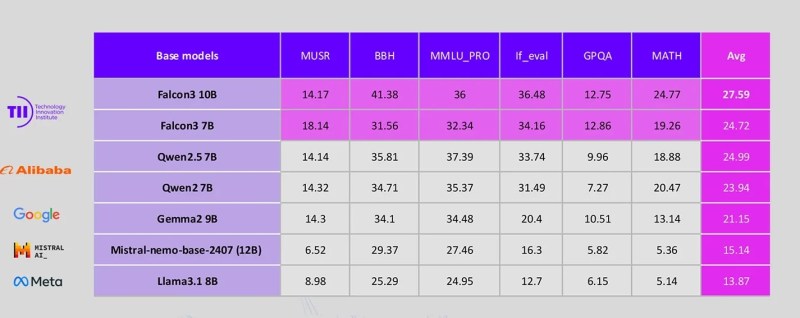

根据 Hugging Face 排行榜,Falcon 3 的 10B 和 7B 版本在推理、语言理解、指令遵循、代码和数学任务方面取得了最先进的结果。在 13B 参数规模的模型中,Falcon 3 的 10B 和 7B 版本超越了 Google 的 Gemma 2-9B、Meta 的 Llama 3.1-8B、Mistral-7B 和 Yi 1.5-9B 等竞争对手。它们甚至在大多数基准测试中(例如 MUSR、MATH、GPQA 和 IFEval)超越了阿里巴巴的领先者 Qwen 2.5-7B,仅在 MMLU(评估语言模型理解和处理人类语言能力的测试)方面略逊一筹。

Falcon 3 基准测试

现在,Falcon 3 模型已在 Hugging Face 上发布,TII 旨在为广泛的用户提供服务,使他们能够以经济高效的方式部署 AI,而无需担心计算瓶颈。凭借其处理特定领域任务的能力和快速处理速度,Falcon 3 模型可以为各种边缘应用和隐私敏感环境提供支持,包括客户服务聊天机器人、个性化推荐系统、数据分析、欺诈检测、医疗诊断、供应链优化和教育等。

TII 还计划进一步扩展 Falcon 家族,推出具有多模态功能的模型。这些模型预计将于 2025 年 1 月发布。

值得注意的是,所有模型均已根据 TII Falcon 许可证 2.0 发布,该许可证是一种基于 Apache 2.0 的宽松许可证,并附带一项可接受的使用政策,鼓励负责任的 AI 开发和部署。为了帮助用户入门,TII 还推出了 Falcon Playground,这是一个测试环境,研究人员和开发者可以在将 Falcon 3 模型集成到其应用程序之前对其进行试用。