推理 AI 时代:如何充分发挥其潜力?

OpenAI 在 2024 年 9 月推出的 o1 推理模型,掀起了新一轮的 AI 革命。该模型虽然在回答问题时速度较慢,但其在复杂的多步骤数学和科学问题上的表现却远超其他模型。这一突破也引发了 AI 商业领域的“军备竞赛”,DeepSeek 的 R1、Google Gemini 2 Flash Thinking 以及最新的 LlamaV-o1 等模型纷纷涌现,试图在推理能力上与 OpenAI 的 o1 和即将推出的 o3 模型家族一较高下。

这些模型都采用了“思维链”(CoT)提示,即“自我提示”,迫使它们在分析过程中进行反思,回溯,检查自己的工作,最终得出比其他大型语言模型(LLM)更快地从嵌入中提取答案更准确的结果。

然而,o1 和 o1-mini 的高昂成本(OpenAI API 上 o1 为 15.00 美元/100 万个输入令牌,而 GPT-4o 为 1.25 美元/100 万个输入令牌)让一些人望而却步。究竟是否值得为推理模型付出 12 倍的代价?

事实证明,越来越多人开始接受推理模型,但真正发挥其价值的关键可能在于用户对其进行不同的提示。

AI 新闻服务 Smol 的创始人 Shawn Wang 在其 Substack 上发表了一篇由前苹果公司 visionOS(为 Vision Pro 空间计算头显提供支持)界面设计师 Ben Hylak 撰写的客座文章。这篇文章迅速走红,因为它令人信服地解释了 Hylak 如何通过提示 OpenAI 的 o1 模型获得极其有价值的输出。

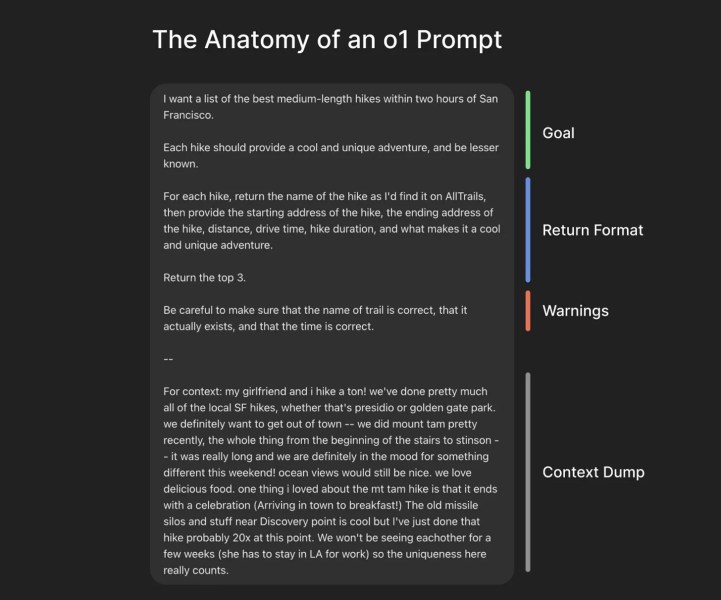

简而言之,用户应该不再为 o1 模型编写提示,而是应该考虑编写“简报”,即包含更多上下文信息的详细说明,例如用户想要模型输出什么,用户是谁,以及用户希望模型以何种格式输出信息。

正如 Hylak 在 Substack 上写道:

“对于大多数模型,我们都被训练成告诉模型我们想要它如何回答我们。例如,‘你是一位经验丰富的软件工程师,请慢慢思考,仔细考虑。’

“这与我在 o1 上取得成功的做法完全相反。我不指示它如何做,只指示它做什么。然后让 o1 接管,规划并解决它自己的步骤。这就是自主推理的意义所在,实际上它比你手动审查和聊天作为‘循环中的那个人’要快得多。”

Hylak 还提供了一个很棒的带注释的屏幕截图,展示了用于 o1 的示例提示,该提示为一系列徒步旅行生成有用的结果:

这篇博文非常有用,OpenAI 的总裁兼联合创始人 Greg Brockman 在他的 X 账户上重新分享了它,并附言:“o1 是一种不同类型的模型。要获得最佳性能,需要以与标准聊天模型不同的方式使用它。”

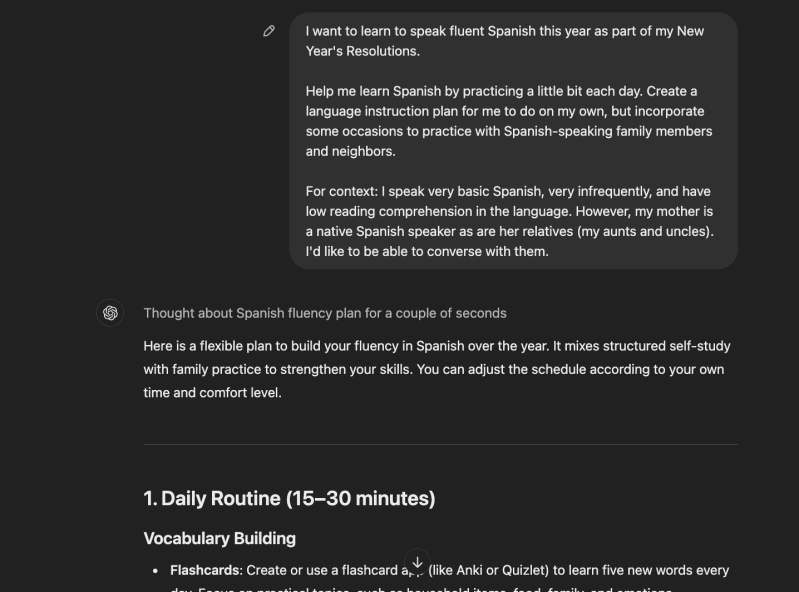

我自己也尝试了一下,我一直在努力学习流利地说西班牙语,以下是结果,供好奇的人参考。也许不像 Hylak 的精心构建的提示和响应那样令人印象深刻,但绝对显示出强大的潜力。

此外,即使对于 Claude 3.5 Sonnet 这样的非推理 LLM,普通用户也可能可以通过改进提示来获得更好、更不受约束的结果。

正如前 Teton.ai 工程师、现任神经调节设备 openFUS 的创造者 Louis Arge 在 X 上写道,“我发现的一个技巧是,LLM 比我的提示更相信自己的提示”,并提供了一个例子,说明他如何通过首先“引发与 LLM 的争斗”来让 Claude “不再胆小”。

所有这些都表明,随着 AI 时代的到来,提示工程仍然是一项宝贵的技能。