模型训练不仅仅是将数据输入反向传播算法。很多时候,决定项目成败的关键因素,在于一个不那么引人注目但至关重要的领域:数据管道的效率。

低效的训练基础设施会浪费大量时间、资源和金钱,导致图形处理单元(GPU)处于空闲状态,这种现象被称为GPU饥饿。这种低效不仅会拖延开发进程,还会增加运营成本,无论是在云端还是本地部署的基础设施上。

本文旨在提供一份实用且基础的指南,帮助读者识别并解决PyTorch训练周期中最常见的瓶颈。

本文将深入分析数据管理——这是每个训练循环的核心——并展示如何通过有针对性的优化,从理论探讨到实际实验,全面释放硬件的全部潜力。

总结而言,阅读本文后,读者将了解:

- 减缓神经网络开发和训练的常见瓶颈

- 优化PyTorch训练循环的基本原则

- 训练中的并行化与内存管理技术

训练优化的必要性

优化深度学习模型的训练是一个战略性需求,它直接意味着计算成本和计算时间的显著节约。

更快的训练速度能够实现:

- 加速测试周期

- 更快地验证新想法

- 探索不同的模型架构并优化超参数

这将加速模型的生命周期,使组织能够更快地创新并将解决方案推向市场。

例如,训练优化使得企业能够迅速分析海量数据以识别趋势和模式,这对于制造业中的模式识别或预测性维护等关键任务至关重要。

最常见瓶颈分析

性能瓶颈通常表现为CPU、GPU、内存和存储设备之间复杂的相互作用。

识别出可能减缓神经网络训练速度的主要瓶颈如下:

- I/O与数据:主要问题是GPU饥饿,即GPU处于空闲状态,等待CPU加载和预处理下一批数据。这种情况在大数据集无法完全加载到RAM时尤为常见。磁盘速度至关重要:NVMe固态硬盘(SSD)的速度可比传统机械硬盘(HDD)快35倍。

- GPU:当GPU达到饱和(模型计算量大)时会发生瓶颈,但更常见的情况是由于CPU未能及时提供数据而导致GPU利用率不足。GPU拥有大量低速核心,擅长并行处理;而CPU则擅长顺序处理。

- 内存:内存耗尽通常表现为臭名昭著的

RuntimeError: CUDA out of memory错误,这迫使训练时必须减小批次大小。梯度累积技术可以模拟更大的批次大小,但并不能提高实际的数据吞吐量。

为什么CPU和I/O常常是主要限制?

优化中的一个关键方面是理解“级联瓶颈”现象。

在典型的训练系统中,GPU是计算引擎,而CPU负责数据准备。如果磁盘速度缓慢,CPU将把大部分时间花在等待数据上,从而成为主要的瓶颈。结果,GPU由于没有数据可处理而保持空闲。

这种现象常导致人们误以为问题出在GPU硬件上,但实际上,低效的根源在于数据供应链路。在不解决上游瓶颈的情况下增加GPU处理能力是徒劳的,因为训练性能永远不会超过系统中速度最慢的组件。因此,有效优化的第一步是识别并解决根本问题,这通常存在于I/O或数据管道中。

分析与优化工具库

有效的优化需要数据驱动的方法,而非盲目尝试。PyTorch提供了旨在诊断瓶颈和改进训练周期的工具及原语。本次实验主要涉及以下三个关键要素:

- Dataset与DataLoader

- TorchVision

- Profiler(性能分析器)

PyTorch中的Dataset和DataLoader

高效的数据管理是任何训练循环的核心。PyTorch提供了两个基本抽象,即Dataset和DataLoader。

简要概述如下:

torch.utils.data.Dataset

这是表示一组样本及其标签的基础类。

要创建一个自定义数据集,只需实现以下三个方法:

__init__: 初始化数据路径或连接__len__: 返回数据集的长度__getitem__: 加载并可选地转换单个样本

torch.utils.data.DataLoader

它是封装数据集并使其高效可迭代的接口。

它自动处理:

- 批处理(

batch_size) - 重新洗牌(

shuffle=True) - 并行加载(

num_workers) - 内存管理(

pin_memory)

TorchVision:计算机视觉的标准数据集与操作

TorchVision是PyTorch用于计算机视觉领域的库,旨在加速原型开发和基准测试。

其主要实用功能包括:

- 预定义数据集:包括CIFAR-10、MNIST、ImageNet等众多数据集,它们已被实现为

Dataset的子类。这对于快速测试非常方便,无需手动构建自定义数据集。 - 常见数据转换操作:例如缩放、归一化、旋转、数据增强等。这些操作可以通过

transforms.Compose进行组合,并在数据加载时即时执行,从而减少手动预处理的工作量。 - 预训练模型:提供用于分类、检测和分割任务的预训练模型,可作为基线模型或用于迁移学习。

示例:

from torchvision import datasets, transforms

transform = transforms.Compose([

transforms.Resize((224, 224)),

transforms.ToTensor(),

transforms.Normalize(mean=[0.5], std=[0.5])

])

train_data = datasets.CIFAR10(root="./data", train=True, download=True, transform=transform)

PyTorch Profiler:性能诊断工具

PyTorch Profiler能够帮助开发者精确了解代码在CPU和GPU上的执行时间分布。

主要功能包括:

- 对CUDA操作符和内核进行详细分析。

- 支持多设备(CPU/GPU)性能剖析。

- 将结果导出为

.json交互式格式,或通过TensorBoard进行可视化。

示例:

import torch

import torch.profiler as profiler

def train_step(model, dataloader, optimizer, criterion):

for inputs, labels in dataloader:

optimizer.zero_grad()

outputs = model(inputs)

loss = criterion(outputs, labels)

loss.backward()

optimizer.step()

with profiler.profile(

activities=[profiler.ProfilerActivity.CPU,

profiler.ProfilerActivity.CUDA],

on_trace_ready=profiler.tensorboard_trace_handler("./log")

) as prof:

train_step(model, dataloader, optimizer, criterion)

print(prof.key_averages().table(sort_by="cuda_time_total"))

训练周期的构建与分析

PyTorch中的训练循环是一个迭代过程,它针对每个数据批次重复执行一系列基本步骤,以训练网络完成三个基本阶段:

- 前向传播(Forward Pass):模型根据输入批次计算预测结果。PyTorch在此阶段动态构建计算图(

autograd),以跟踪操作并为梯度计算做准备。 - 反向传播(Backward Pass):反向传播算法使用链式法则计算损失函数相对于所有模型参数的梯度。此过程通过调用

loss.backward()触发。在每次反向传播之前,必须使用optimizer.zero_grad()重置梯度,因为PyTorch默认会累积梯度。 - 权重更新(Updating weights):优化器(

torch.optim)使用计算出的梯度来更新模型权重,从而最小化损失。调用optimizer.step()执行当前批次的最终权重更新。

性能下降可能发生在训练周期的各个环节。如果DataLoader加载批次数据缓慢,GPU就会保持空闲。如果模型计算量大,GPU可能被饱和利用。CPU和GPU之间的数据传输也是潜在的低效率来源,在性能分析器中表现为cudaMemcpyAsync操作的长时间执行。

训练瓶颈几乎从不出现在GPU本身,而在于导致其空闲的数据管道效率低下。

主要目标是确保GPU永不“饥饿”,持续获得数据供应。

优化利用了CPU(擅长I/O和顺序处理)与GPU(擅长并行计算)架构之间的差异。如果数据集太大无法完全加载到RAM,基于Python的生成器可能成为训练复杂模型的一个显著障碍。

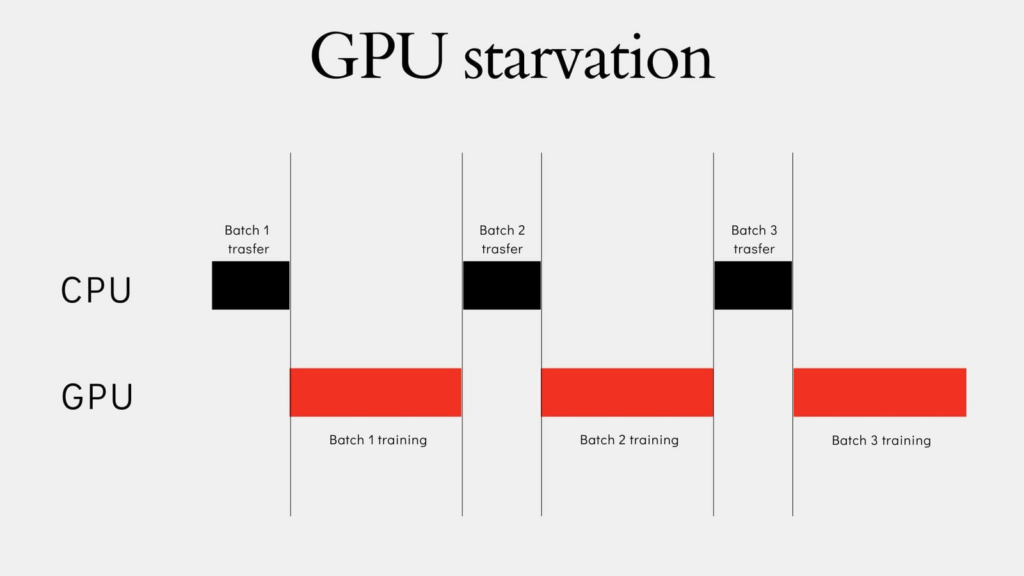

一个典型的例子是,训练循环中当GPU运行时CPU空闲,而当CPU运行时GPU空闲,如下图所示:

这张图片描绘了一个经典的低效数据管理案例。

CPU与GPU之间的批次管理

优化过程基于重叠的概念:DataLoader通过使用多个工作进程(num_workers > 0),在GPU处理当前批次数据时,在CPU上并行准备下一个批次。

优化DataLoader可以确保CPU和GPU异步并发工作。如果一个批次的预处理时间约等于GPU的计算时间,理论上训练过程的速度可以翻倍。

这种预加载行为可以通过DataLoader的prefetch_factor参数进行控制,该参数决定了每个工作进程预加载的批次数量。

瓶颈诊断方法

使用PyTorch Profiler对于将优化过程转变为数据驱动的诊断大有裨益。通过分析时间消耗指标,可以识别出低效率的根本原因:

| 性能分析器检测到的症状 | 诊断(瓶颈) | 推荐解决方案 |

|---|---|---|

DataLoader的Self CPU total %高 |

CPU侧预处理和/或数据加载缓慢 | 增加num_workers |

cudaMemcpyAsync执行时间长 |

CPU和GPU内存之间数据传输缓慢 | 启用pin_memory=True |

数据加载优化技术

PyTorch DataLoader中实现的两项最有效技术是工作进程并行化和使用锁定内存(pinned_memory)。

工作进程并行化

DataLoader中的num_workers参数启用多进程并行处理,创建子进程以并行加载和预处理数据。这显著提高了数据加载的吞吐量,有效地将训练与下一批数据的准备工作重叠进行。

- 优点:减少GPU等待时间,尤其适用于大型数据集或复杂的预处理任务(如图像转换)。

- 最佳实践:建议从

num_workers=0开始调试,然后逐步增加并监控性能。常见的经验法则建议num_workers = 4 * num_GPU。 - 警告:过多的工作进程会增加RAM消耗,并可能导致CPU资源争用,从而降低整个系统的速度。

内存锁定(Pinned Memory)加速CPU-GPU传输

在DataLoader中设置pin_memory=True会在CPU上分配一种特殊的“锁定内存”(page-locked memory)。

- 机制:这种内存不会被操作系统交换到磁盘。这允许从CPU到GPU进行异步、直接的数据传输,避免了额外的中间复制步骤,从而减少了空闲时间。

- 优点:加速了向CUDA设备的数据传输,使GPU能够同时处理和接收数据。

- 不适用情况:如果未使用GPU,

pin_memory=True不会带来任何益处,反而会额外占用不可分页的RAM。在RAM有限的系统上,这可能会对物理内存造成不必要的压力。

实际实现与基准测试

至此,进入PyTorch模型训练优化方法的实验阶段,将标准训练循环与先进的数据加载技术进行比较。

为了展示所讨论方法的有效性,实验将使用一个在标准MNIST数据集上训练的前馈神经网络。

本次实验涵盖的优化技术包括:

- 标准训练(基线):PyTorch中的基本训练周期(

num_workers=0, pin_memory=False)。 - 多工作进程数据加载:使用多个进程并行加载数据(

num_workers=N)。 - 锁定内存 + 非阻塞传输:优化GPU内存和CPU-GPU传输(

pin_memory=True和non_blocking=True)。 - 性能分析:比较执行时间并总结最佳实践。

测试环境设置

步骤1:导入所需库

第一步是导入所有必要的库并验证硬件配置:

import torch

import torch.nn as nn

import torch.optim as optim

import torch.nn.functional as F

from torchvision import datasets, transforms

from torch.utils.data import DataLoader

from time import time

import warnings

warnings.filterwarnings('ignore')

print(f"PyTorch version: {torch.__version__}")

print(f"CUDA available: {torch.cuda.is_available()}")

if torch.cuda.is_available():

device = torch.device("cuda")

print(f"GPU device: {torch.cuda.get_device_name(0)}")

print(f"GPU memory: {torch.cuda.get_device_properties(0).total_memory / 1e9:.1f} GB")

else:

device = torch.device("cpu")

print("Using CPU")

print(f"Device used for training: {device}")

预期结果:

PyTorch version: 2.8.0+cu126

CUDA available: True

GPU device: NVIDIA GeForce RTX 4090

GPU memory: 25.8 GB

Device used for training: cuda

步骤2:数据集分析与加载

MNIST数据集是一个基础的基准数据集,包含70,000张28×28的灰度图像。数据归一化对于训练效率至关重要。

定义加载数据集的函数:

transform = transforms.Compose()

train_dataset = datasets.MNIST(root='./data',

train=True,

download=True,

transform=transform)

test_dataset = datasets.MNIST(root='./data',

train=False,

download=True,

transform=transform)

步骤3:为MNIST实现一个简单的神经网络

为实验定义一个简单的前馈神经网络:

class SimpleFeedForwardNN(nn.Module):

def __init__(self):

super(SimpleFeedForwardNN, self).__init__()

self.fc1 = nn.Linear(28 * 28, 128)

self.fc2 = nn.Linear(128, 64)

self.fc3 = nn.Linear(64, 10)

def forward(self, x):

x = x.view(-1, 28 * 28)

x = torch.relu(self.fc1(x))

x = torch.relu(self.fc2(x))

x = self.fc3(x)

return x

步骤4:定义经典的训练循环

定义一个可重用的训练函数,它封装了三个关键阶段(前向传播、反向传播和参数更新):

def train(model,

device,

train_loader,

optimizer,

criterion,

epoch,

non_blocking=False):

model.train()

loss_value = 0

for batch_idx, (data, target) in enumerate(train_loader):

# Move data on GPU using non blocking parameter

data = data.to(device, non_blocking=non_blocking)

target = target.to(device, non_blocking=non_blocking)

optimizer.zero_grad() # Prepare to perform Backward Pass

output = model(data) # 1. Forward Pass

loss = criterion(output, target)

loss.backward() # 2. Backward Pass

optimizer.step() # 3. Parameter Update

loss_value += loss.item()

print(f'Epoch {epoch} | Average Loss: {loss_value:.6f}')

分析1:未优化训练循环(基线)

采用顺序数据加载的配置(num_workers=0,pin_memory=False):

model = SimpleFeedForwardNN().to(device)

criterion = nn.CrossEntropyLoss()

optimizer = optim.Adam(model.parameters(), lr=0.001)

# 基线设置:num_workers=0, pin_memory=False

train_loader = DataLoader(train_dataset, batch_size=64, shuffle=True)

start = time()

num_epochs = 5

print("

==================================================

实验:标准训练(基线)

==================================================")

for epoch in range(1, num_epochs + 1):

train(model, device, train_loader, optimizer, criterion, epoch, non_blocking=False)

total_time_baseline = time() - start

print(f" 实验在 {total_time_baseline:.2f} 秒内完成")

print(f" 每轮训练平均耗时: {total_time_baseline / num_epochs:.2f} 秒")

预期结果(基线场景):

==================================================

实验:标准训练(基线)

==================================================

Epoch 1 | Average Loss: 0.240556

Epoch 2 | Average Loss: 0.101992

Epoch 3 | Average Loss: 0.072099

Epoch 4 | Average Loss: 0.055954

Epoch 5 | Average Loss: 0.048036

实验在 22.67 秒内完成

每轮训练平均耗时: 4.53 秒

分析2:使用工作进程优化的训练循环

引入num_workers=8进行数据加载并行化:

model = SimpleFeedForwardNN().to(device)

criterion = nn.CrossEntropyLoss()

optimizer = optim.Adam(model.parameters(), lr=0.001)

# 通过使用工作进程优化DataLoader

train_loader = DataLoader(train_dataset, batch_size=64, shuffle=True, num_workers=8)

start = time()

num_epochs = 5

print("

==================================================

实验:多工作进程数据加载(8个工作进程)

==================================================")

for epoch in range(1, num_epochs + 1):

train(model, device, train_loader, optimizer, criterion, epoch, non_blocking=False)

total_time_workers = time() - start

print(f" 实验在 {total_time_workers:.2f} 秒内完成")

print(f" 每轮训练平均耗时: {total_time_workers / num_epochs:.2f} 秒")

预期结果(工作进程场景):

==================================================

实验:多工作进程数据加载(8个工作进程)

==================================================

Epoch 1 | Average Loss: 0.228919

Epoch 2 | Average Loss: 0.100304

Epoch 3 | Average Loss: 0.071600

Epoch 4 | Average Loss: 0.056160

Epoch 5 | Average Loss: 0.045787

实验在 9.14 秒内完成

每轮训练平均耗时: 1.83 秒

分析3:工作进程 + 锁定内存优化的训练循环

在DataLoader中加入pin_memory=True,并在train函数中设置non_blocking=True以实现异步传输:

model = SimpleFeedForwardNN().to(device)

criterion = nn.CrossEntropyLoss()

optimizer = optim.Adam(model.parameters(), lr=0.001)

# 使用工作进程 + 锁定内存优化DataLoader

train_loader = DataLoader(train_dataset,

batch_size=64,

shuffle=True,

pin_memory=True, # 激活锁定内存

num_workers=8)

start = time()

num_epochs = 5

print("

==================================================

实验:锁定内存 + 非阻塞传输(8个工作进程)

==================================================")

# non_blocking=True 用于异步数据传输

for epoch in range(1, num_epochs + 1):

train(model, device, train_loader, optimizer, criterion, epoch, non_blocking=True)

total_time_optimal = time() - start

print(f" 实验在 {total_time_optimal:.2f} 秒内完成")

print(f" 每轮训练平均耗时: {total_time_optimal / num_epochs:.2f} 秒")

预期结果(所有优化方案场景):

==================================================

实验:锁定内存 + 非阻塞传输(8个工作进程)

==================================================

Epoch 1 | Average Loss: 0.269098

Epoch 2 | Average Loss: 0.123732

Epoch 3 | Average Loss: 0.090587

Epoch 4 | Average Loss: 0.073081

Epoch 5 | Average Loss: 0.062543

实验在 9.00 秒内完成

每轮训练平均耗时: 1.80 秒

结果分析与解读

实验结果证明了数据管道优化对总训练时间的影响。从顺序加载(基线)切换到并行加载(多工作进程)使总时间减少了50%以上。加入非阻塞的锁定内存功能,则带来了进一步虽小但显著的改进。

| 方法 | 总时间 (秒) | 加速比 |

|---|---|---|

| 标准训练(基线) | 22.67 | 基线 |

| 多工作进程加载(8个工作进程) | 9.14 | 2.48x |

| 优化后(锁定内存 + 非阻塞) | 9.00 | 2.52x |

结果反思:

num_workers的影响:引入8个工作进程后,总训练时间从22.67秒缩短至9.14秒,实现了2.48倍的加速。这表明在基线情况下,主要瓶颈在于数据加载(GPU的CPU饥饿)。pin_memory的影响:添加pin_memory=True和non_blocking=True进一步将时间缩短至9.00秒,将总体性能提升至2.52倍。尽管这一改进相对温和,但它反映了在CPU锁定内存与GPU之间数据传输过程中(即cudaMemcpyAsync操作)消除了微小的同步延迟。

所获得的结果并非普遍适用。优化的有效性取决于外部因素:

- 批次大小(Batch Size):更大的批次大小可以提高GPU计算效率,但也可能导致内存错误(

OOM,内存溢出)。如果存在I/O瓶颈,增加批次大小可能无法带来更快的训练速度。 - 硬件:

num_workers的效率与CPU核心数量和I/O速度(固态硬盘 vs. 机械硬盘)直接相关。 - 数据集/预处理:应用于数据的转换复杂性会影响CPU的工作负载,从而影响

num_workers的最佳值。

结论

优化神经网络的性能并不仅仅局限于选择模型架构或训练参数。持续监控数据管道并识别瓶颈(无论是CPU、GPU还是数据传输),能够带来显著的效率提升。

值得铭记的最佳实践

使用诸如PyTorch Profiler之类的工具进行诊断非常重要。优化DataLoader仍然是解决GPU空闲问题的最佳切入点。

| DataLoader参数 | 对效率的影响 | 何时使用 |

|---|---|---|

num_workers |

并行化预处理和加载,减少GPU等待时间。 | 当性能分析器指示存在CPU瓶颈时。 |

pin_memory |

加速异步CPU-GPU传输。 | 在使用GPU时,为了消除潜在的数据传输瓶颈。 |

DataLoader之外的未来发展方向

为了进一步提升加速效果,可以探索以下高级技术: