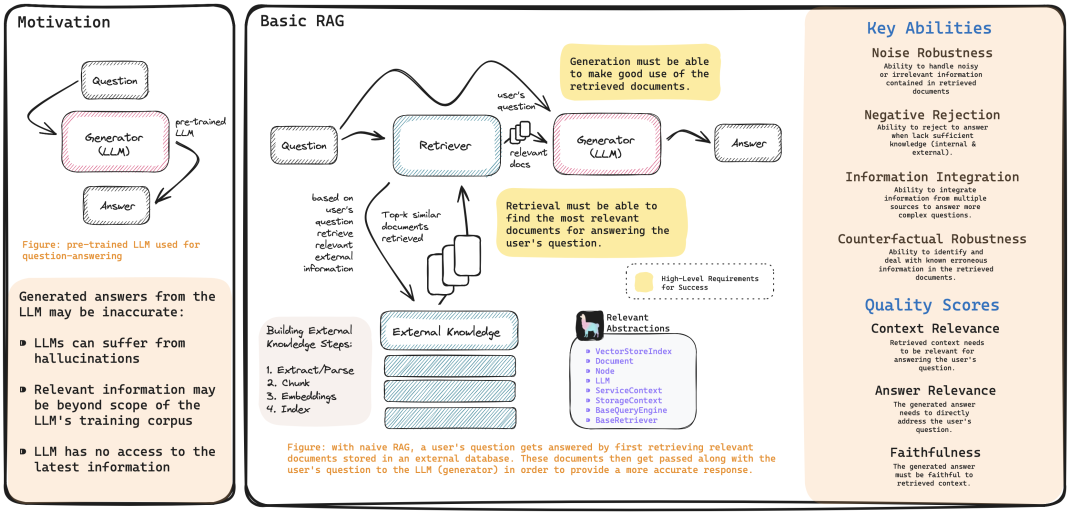

想象一下,在一片茫茫大海中寻找一艘沉船。如果仅凭望远镜快速扫描海面,或许能发现几十个可疑目标,但其中多数可能只是漂浮的木头或礁石——这便是Embedding模型的运作模式。而当派遣潜水员深入海底,仔细勘察每个目标的细节时,才能最终确定真正的沉船位置——这恰恰是Rerank模型的独特价值。

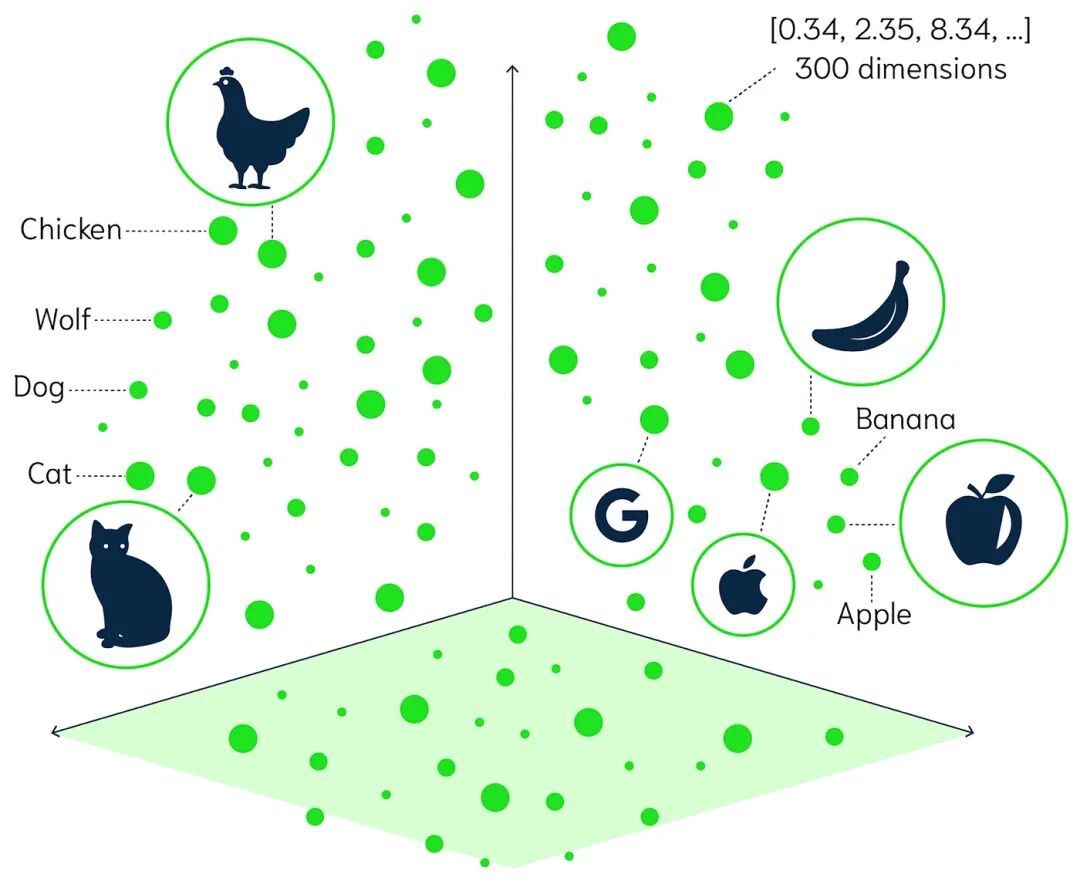

Embedding模型本质上是一个高效的语义扫描仪。它通过将文本转换为高维向量,实现了对海量信息的快速筛选。如同雷达扫描天空,它能在毫秒级别内从百万级文档中找出”看起来相关”的候选集。这种速度优势源于其双编码器架构——查询和文档被分别编码为向量,随后通过简单的向量相似度计算完成初步匹配。在实际应用中,BGE、M3E等主流模型均能在GPU上实现每秒处理数千个查询的惊人速度。

然而,这种快速扫描并非没有代价。Embedding模型在压缩文本信息时,不可避免地会丢失关键的上下文细节。这就像使用望远镜观察星星,能够快速定位到某个星座区域,却无法看清具体每颗星星的细节特征。当查询”清华大学位置”时,它可能检索出所有关于”中国顶尖大学”的文档,却难以精准定位到包含”北京”的那一篇。

相比之下,Rerank模型更似一个精密的制导系统。它采用交叉编码器架构,能够同时处理查询和文档的原始文本,进行深度的语义交互分析。这种机制使得Rerank具备了理解微妙语义差异的能力。例如,当查询”苹果公司最新产品”时,Embedding可能会召回关于水果苹果的文档,而Rerank则能准确识别出此处的”苹果”指的是科技公司。

其代价是计算复杂度较高。Rerank需要实时计算查询与每个候选文档的相关性得分,此过程远比简单的向量相似度计算缓慢。在实际测试中,处理3个文档大约需要1.2秒,这决定了它仅能在小规模候选集上发挥作用。然而,正是这种”慢工出细活”的特性,使其成为提升最终答案质量的关键环节。

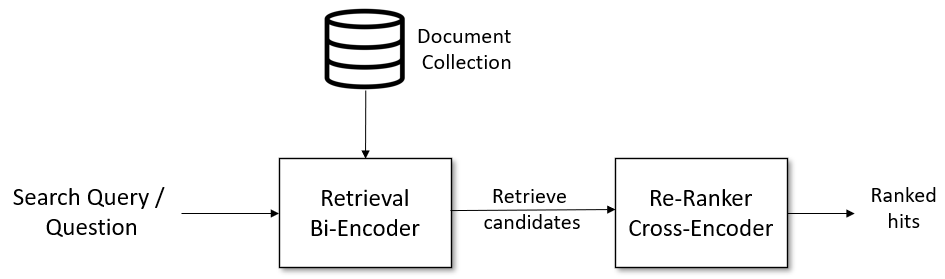

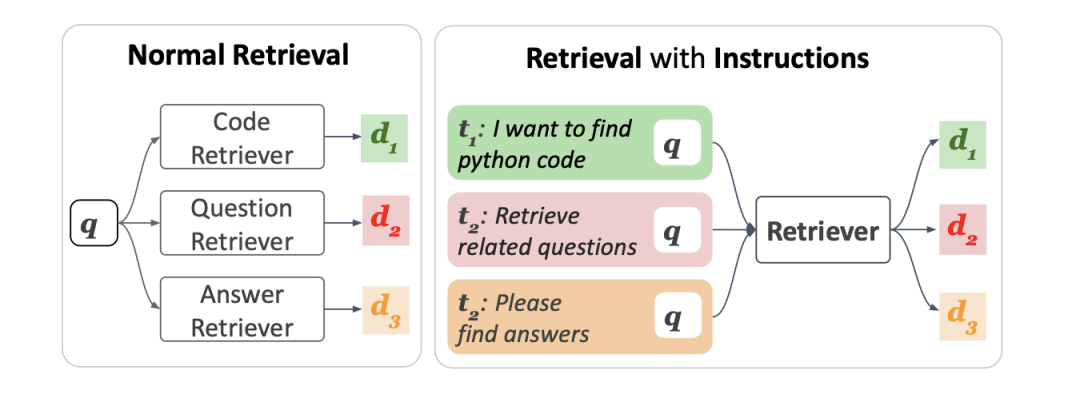

从技术底层来看,这两种模型的差异源于完全不同的设计哲学。双编码器(Embedding)采用”编码后比较”的策略。查询和文档各自通过编码器生成向量,这些向量可以预先计算并建立索引。当新查询到来时,只需计算一次查询向量,随后通过近邻搜索快速找到相似文档。交叉编码器(Rerank)则采用”编码时交互”的策略。它将查询和文档拼接后一同送入模型,使两者在编码过程中进行充分的语义交互。这种设计能捕捉到更细微的相关性信号,但无法预先计算,必须实时处理。

关键区别在于:Embedding输出的是具有绝对意义的向量,而Rerank输出的是相对的相关性分数。这也是为何Rerank的分数更适合排序,但不适合直接用于检索。这如同招聘流程中,简历筛选阶段关注的是候选人的硬性条件(向量相似度),而面试阶段评估的是与岗位的匹配程度(相关性分数)。

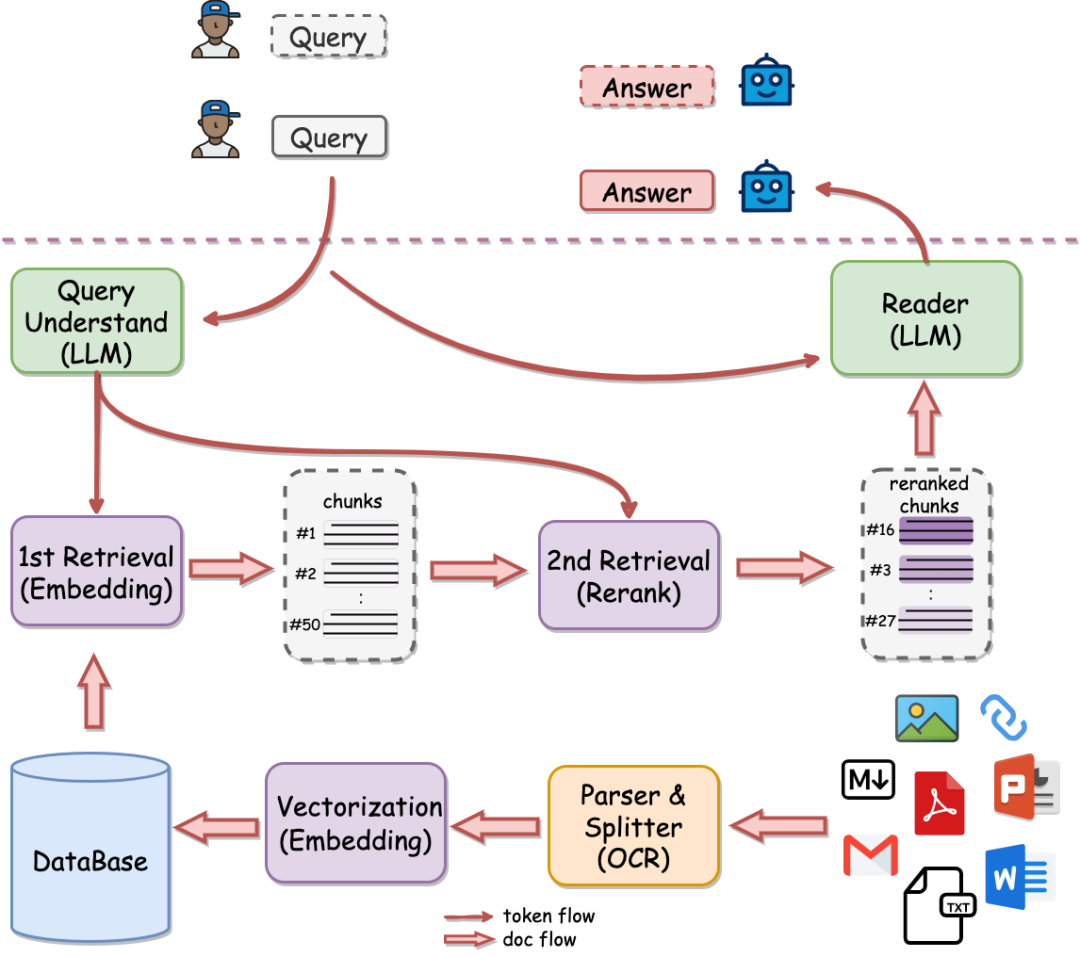

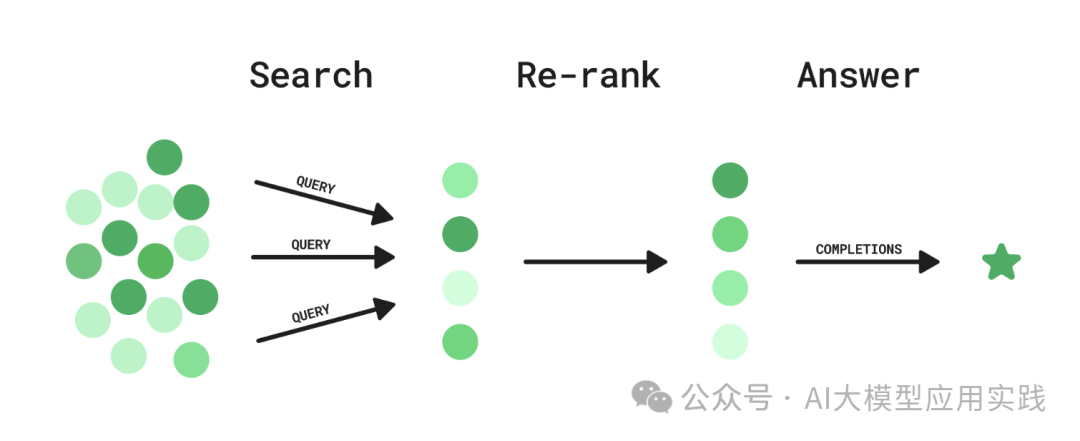

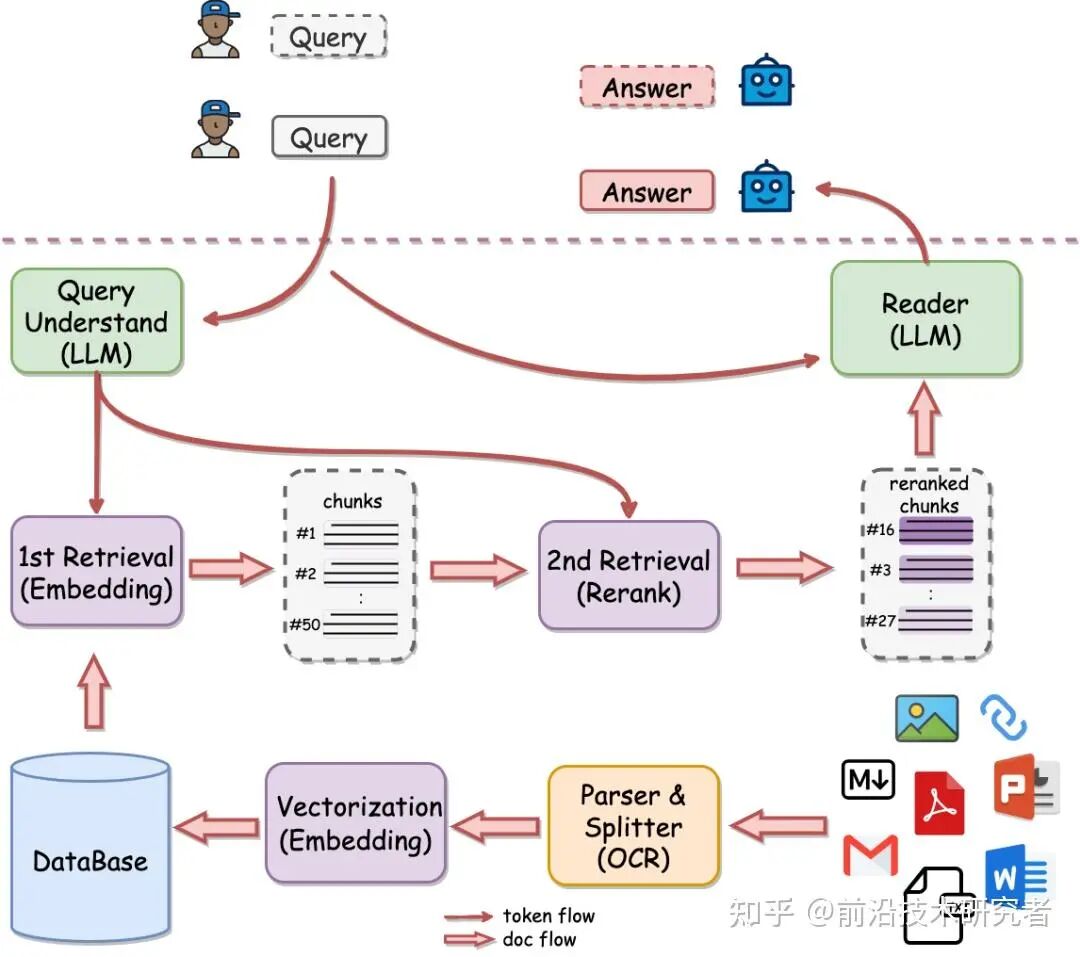

在一个设计良好的RAG系统中,这两个引擎形成了完美的协作关系。Embedding负责”广撒网”——利用其高速处理能力,从海量知识库中快速筛选出Top K个候选文档。此阶段的目标是保证召回率,宁可错杀一千,也不放过一个相关文档。Rerank负责”精捕捞”——对Embedding返回的候选集进行精细排序,选出最相关的Top N个文档传递给大模型。此阶段的目标是提升准确率,确保最终答案的质量。

这种分工如同现代企业的招聘流程:HR先用关键词快速筛选简历(Embedding),然后业务主管再进行深度面试(Rerank)。仅进行第一步,可能会错失真正的人才;仅进行第二步,效率又无法支撑大规模招聘。两者的完美配合,才是构建高质量RAG系统的关键。

Embedding模型的工作原理与致命缺陷

当在RAG系统中输入一个问题时,Embedding模型就像一位快速扫描员,瞬间将文字转化为一串数字向量。这个看似简单的过程,却蕴含着复杂的技术原理和不可避免的局限性。

文本向量化的核心技术原理

文本向量化的本质是将非结构化的文本信息转化为计算机能够理解的数学表示。想象一下,每个词语、每个句子都被映射到一个高维空间中的特定位置,语义相近的内容在这个空间中的距离也更近。

具体来说,Embedding模型通过深度神经网络学习文本的分布式表示。以BCEmbedding为例,其核心流程包括:

from BCEmbedding import EmbeddingModel# 初始化模型model = EmbeddingModel(model_name_or_path="maidalun1020/bce-embedding-base_v1")# 将句子转化为向量sentences = ['深度学习模型', '神经网络算法', '今天的天气真好']embeddings = model.encode(sentences)

这个过程背后是对比学习的机制——模型通过大量文本对训练,学会将语义相似的句子拉近,将不相关的句子推远。关键在于,Embedding模型是双编码器架构,查询和文档被独立编码为向量,然后计算余弦相似度。

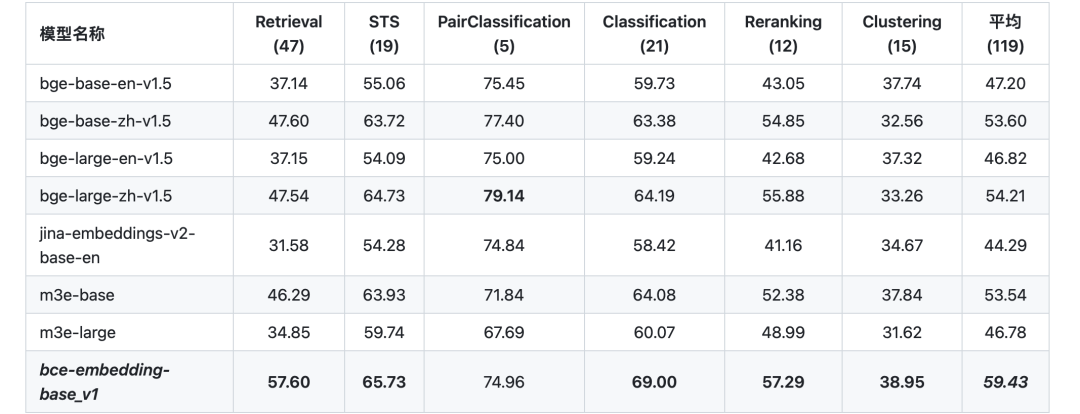

主流Embedding模型对比:BGE vs M3E

当前中文场景下,BGE(BAAI General Embedding)和M3E(Moka Massive Mixed Embedding)形成了双雄争霸的格局。

BGE模型基于RetroMA预训练,采用大规模对比学习优化,在通用语义理解任务上表现稳定。其最大特色是引入了instruction提示机制,在不同检索任务中使用特定前缀:

# BGE的instruction使用示例instruction = "为这个句子生成表示以用于检索相关文章:"query_embedding = model.encode([instruction + query for query in queries])

相比之下,M3E模型专注于中文优化,在混合质量数据上训练,在中文特定任务上往往有更好表现。两者的选择并非绝对——BGE在跨语言和通用性上占优,M3E在纯中文场景下可能更精准。

从技术指标看,在MTEB中文评测基准上,BGE-large-zh在检索任务中的平均得分达到63.2,而M3E-large达到61.8,差距虽小但在大规模应用中意义重大。

Embedding在召回阶段的优势与应用

Embedding模型的真正价值在于其惊人的效率。通过预先计算文档向量并建立索引,系统可以在毫秒级别从百万级文档库中召回相关候选。

这种效率优势体现在几个方面:

- •批量处理能力:可离线处理海量文档,建立向量索引

- •快速相似度计算:基于近似最近邻搜索,实现亚秒级响应

- •内存友好:向量表示相比原始文本极大压缩存储需求

在实际的RAG系统中,Embedding承担着粗排角色——它无需找到最相关的文档,只需确保相关文档出现在候选集中。这种”宁可错杀一千,不可放过一个”的策略,为后续的精排阶段奠定了坚实基础。

三大局限性:相似度阈值、语义模糊、信息丢失

然而,Embedding模型并非万能,其内在缺陷在复杂场景下暴露无遗。

相似度阈值困境是最直观的问题。Embedding检索依赖余弦相似度,但这个阈值如何设定?0.7还是0.8?实践中发现,不同领域、不同查询的最优阈值差异巨大,且无法通过简单规则确定。

更致命的是语义模糊问题。考虑查询”苹果公司的最新财报”,Embedding可能召回关于”水果苹果的营养价值”的文档,因为两者在向量空间中都靠近”苹果”这个概念。这种语义层面的混淆,是Embedding模型的结构性缺陷。

信息丢失现象则更为隐蔽。当Embedding模型将一段文本压缩为768维向量时,必然丢失部分语义信息。就像把一幅名画拍成缩略图——整体轮廓还在,但细节已经模糊。对于复杂逻辑推理或专业术语密集的文本,这种信息损失可能是致命的。

一位资深工程师的体会:”Embedding就像用渔网捕鱼,能捞到大鱼,但也会带上来很多水草和石子。”

这些局限性并非技术bug,而是Embedding模型的基础架构决定的。认识到这些缺陷,方能理解为何需要在RAG系统中引入Rerank模型——它并非锦上添花,而是雪中送炭。

Rerank模型的精排机制与独特价值

如果说Embedding模型是RAG系统的”快速扫描雷达”,那么Rerank模型就是系统的”精准制导系统”。在信息检索的战场上,光有速度是不够的,精准度才是决定胜负的关键。当大多数开发者还在纠结Embedding模型的选择时,真正决定系统上限的其实是这个被严重低估的Rerank环节。

交叉编码器的实时相关性计算

交叉编码器(Cross-Encoder)采用了一种完全不同的技术路径。与Embedding模型预先计算向量表示不同,交叉编码器在接收到用户查询时,会实时将查询与候选文档组成文本对,通过深度神经网络直接计算两者的相关性分数。

这种”现场计算”的模式带来了显著优势:模型能够捕捉查询与文档之间更细微的语义关联。例如,在查询”如何训练一只听话的宠物狗”时,Embedding可能召回大量关于”狗”的文档,但Rerank能够精准识别出那些真正讨论”训练方法”而非”狗粮推荐”或”品种介绍”的内容。

技术实现上,交叉编码器通常基于BERT等预训练模型,通过fine-tuning学习判断文本对的相关性。其训练数据由(Query, Passage)对组成,目标是让正样本的logits分数高于同批次中的负样本。

# 典型的Rerank模型使用示例from BCEmbedding import RerankerModelquery = '中国的首都在哪儿'passages = ['中国的首都在哪', '北京。', '上海是中国的一个主要城市。']model = RerankerModel(model_name_or_path="maidalun1020/bce-reranker-base_v1")rerank_results = model.rerank(query, passages)

Rerank如何解决Embedding的痛点

Embedding模型的三大痛点在Rerank面前得到了有效解决:

信息丢失问题:Embedding将丰富文本压缩为单一向量时,不可避免地丢失了上下文细节。Rerank直接处理原始文本,保留了完整的语义信息。

相似度阈值困境:Embedding的相似度阈值难以统一设定,不同场景需要不同标准。Rerank通过端到端学习,自动适应各种查询类型。

语义模糊挑战:当查询存在歧义或多义时,Embedding容易召回语义相似但内容不相关的文档。Rerank通过深度理解上下文,能够区分细微差别。

实际测试表明,在相同候选集上,加入Rerank阶段后,Top1准确率可提升30-50%,这对于需要高精度答案的业务场景至关重要。

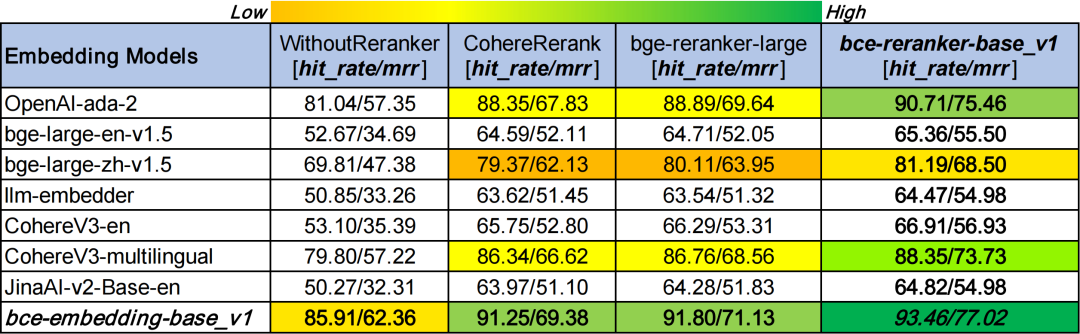

主流Rerank模型技术特点分析

当前主流的Rerank模型各具特色:

BCEmbedding Reranker:网易有道开发,支持中、英、日、韩四语种。其优势在于对中文场景的深度优化,在中文问答和文档检索任务上表现突出。

BGE Reranker:智源研究院出品,基于大规模多语言数据训练。BGE-Reranker-Large在多项评测中表现稳定,score值分布相对集中,便于业务中设定统一的过滤阈值。

技术特点对比:

- •计算效率:Rerank模型通常比Embedding慢1-2个数量级,这也是为何它仅用于精排而非全量检索

- •准确度优势:在复杂语义理解任务上,Rerank的准确率显著高于纯Embedding方案

- •领域适应性:通过领域数据fine-tune,Rerank模型能够获得进一步的性能提升

在复杂查询场景下的精准匹配能力

复杂查询是检验Rerank价值的试金石。当用户提出包含多个条件、存在隐含语义或需要深度推理的查询时,Embedding往往力不从心。

案例:查询”适合家庭使用的、性价比高的扫地机器人推荐”

- • Embedding可能召回所有提到”扫地机器人”的文档

- • Rerank能够精准识别同时满足”家庭使用”和”性价比高”两个条件的文档

多轮对话场景中,Rerank的价值更加凸显。它能够结合对话历史上下文,理解当前查询的真实意图,避免因语义变化导致的检索偏差。

长文档理解方面,Rerank通过处理完整的查询-文档对,能够识别文档中与查询最相关的片段,而不仅仅是基于整体语义相似度。

实际业务数据显示,在知识库问答、客服系统、文档检索等场景中,引入Rerank后用户满意度提升明显,错误答案率下降40%以上。

Rerank不是简单的”锦上添花”,而是在追求极致准确率的现代AI应用中不可或缺的一环。它让RAG系统从”能找到”进化到”能找到对的”,这正是高质量AI应用的核心竞争力。

为什么Rerank不是可有可无?

在构建RAG系统时,许多开发者将rerank视为”锦上添花”的组件,认为embedding已足够应对大多数场景。但现实是,随着系统规模的扩大和查询复杂度的提升,单一embedding的局限性会逐渐暴露,而rerank正是解决这些痛点的关键所在。

数据量增大时的检索退化问题

当知识库从几百条文档扩展到数万条时,embedding模型的性能会出现明显的边际效应递减。

想象一下,向量数据库中有10万条文档,用户查询”如何优化深度学习模型的训练速度”。embedding模型会返回前50个最相似的文档,但其中可能包含:

- • 深度学习基础概念介绍

- • 模型结构优化方法

- • 硬件加速方案

- • 分布式训练技术

- • 甚至还有完全不相关的”机器学习入门指南”

问题在于:embedding的相似度计算是基于整体语义的,无法精确判断文档中是否真正包含用户需要的具体答案。随着数据量增大,这种”模糊匹配”的缺陷会被放大,导致大量看似相关实则无用的文档被召回。

Embedding模型在数据量增大时面临的核心挑战:

- •相似度分布稀释:随着文档数量增加,相似度分数分布趋于集中,区分度降低

- •信息压缩损失:Embedding将复杂文本压缩为固定维度向量,必然丢失细节信息

- •语义边界模糊:在向量空间中,不同主题的文档可能因为某些关键词相似而被错误召回

QAnything项目的测试数据清晰地展示了这一现象:当文档数量超过5000篇时,仅使用Embedding模型的准确率开始明显下降,呈现绿色下降曲线;而引入Rerank后,准确率随数据量增加保持稳定上升,形成理想的增长曲线。

语义相似但内容不相关的召回困境

这是embedding模型最致命的弱点——无法区分语义相似性和内容相关性。

考虑这个真实案例:用户查询”清华大学计算机系的录取分数线”,embedding可能返回:

- • 清华大学招生简章(相关)

- • 清华大学校园地图(语义相似但内容不相关)

- • 清华大学历史沿革(语义相似但内容不相关)

- • 北京大学录取分数线(语义相似但内容错误)

关键洞察:embedding只关心”文本听起来像不像”,而rerank关心”文本是否回答了问题”。这种本质差异决定了在精确问答场景中,rerank是不可替代的。

典型场景举例:

- • 查询”如何治疗感冒”,可能召回”感冒药的市场分析报告”

- • 查询”Python列表操作方法”,可能召回”Python语言发展历史”

根本原因分析:

Embedding模型基于统计语义工作,它理解的是词语共现模式,而非逻辑相关性。当两个文档共享大量相同词汇时,即使主题完全不同,也会被错误地判定为相关。

两阶段检索范式的性能优势

将embedding和rerank结合形成的两阶段检索架构,实际上是在效率与精度之间找到了最佳平衡点。

第一阶段(Embedding):快速从海量文档中筛选出候选集

- •作用:粗筛,保证召回率

- •特点:速度快,覆盖广

- •输出:Top K个候选文档(K通常为50-100)

第二阶段(Rerank):对候选集进行精细排序

- •作用:精排,保证准确率

- •特点:计算密集,但只在小数据集上进行

- •输出:Top N个最相关文档(N通常为3-5)

这种分工的巧妙之处在于:用embedding承担了大部分的计算负担,让rerank专注于最关键的小范围精排,既保证了整体效率,又提升了最终质量。

性能平衡点:通过合理设置TopK值(通常50-200),既保证了检索效率,又为Rerank提供了足够的优化空间。对于TopK=50、TopN=3的配置,增加Rerank环节后系统延迟仅增加1-2秒,但准确率提升可达30%-50%。

实际业务场景中的准确率对比

在多个企业级RAG系统中,引入rerank后带来了显著的性能提升:

金融客服场景测试结果:

- • 仅Embedding:准确率68.2%

- • Embedding + Rerank:准确率89.7%

- •提升幅度:31.5个百分点

技术文档检索场景:

- • 复杂查询(多条件组合):仅Embedding准确率降至52%

- • 加入Rerank后:准确率稳定在85%以上

医疗问答系统:

- • 查询复杂度高的医学问题时,rerank将错误答案的召回率从25%降低到7%

- • 对于专业术语密集的查询,相关性排序的准确度提升超过40%

关键发现:

- • 查询复杂度越高,Rerank的价值越明显

- • 在长文本、多主题文档中,Rerank的改善效果更加显著

- • 对于专业领域术语的理解,Rerank展现出明显优势

业务影响:在电商客服、医疗咨询、法律咨询等对准确性要求极高的场景中,这20-30个百分点的准确率提升,直接决定了用户体验和业务价值。

Rerank不是可选的优化项,而是现代RAG系统的必备组件。它解决了Embedding模型无法克服的语义理解深度问题,为AI应用提供了真正的智能保障。

参数配置:TopK与TopN的协同艺术

在RAG系统的两阶段检索架构中,参数配置往往是被忽视却至关重要的环节。许多团队投入大量精力优化模型,却因为参数设置不当而功亏一篑。本文将深入探讨TopK与TopN这对黄金搭档的协同艺术。

TopK在Embedding阶段的核心作用

TopK是Embedding阶段的”守门员”,决定了初步筛选的广度与深度。

想象一下,在一个拥有百万藏书的图书馆里寻找资料。Embedding模型就像一个高效的图书管理员,它不会把整座图书馆的书都搬到面前,而是快速扫描后选出最相关的K本书籍。这个K值就是TopK。

TopK的核心价值在于平衡召回率与计算成本:

- •当K值过小:可能遗漏关键信息,导致召回率不足

- •当K值过大:虽然召回率高,但增加了后续Rerank的计算负担

从技术实现看,TopK的选择直接影响Embedding模型的检索效率。在QAnything等开源项目中,通常建议TopK设置在50-200之间,具体取决于知识库的规模和数据密度。

TopN在Rerank阶段的精准定位

如果说TopK负责”广撒网”,那么TopN就是”精挑选”。

Rerank模型接收到Embedding阶段返回的TopK个候选文档后,会进行深度语义分析,从中选出最相关的TopN个文档作为最终结果。这个N值通常远小于K值,体现了从”可能相关”到”高度相关”的质变。

TopN的精准定位体现在:

- •质量过滤:剔除语义相似但内容不相关的文档

- •相关性排序:按照与查询的相关度进行精确排序

- •结果优化:确保最终返回的都是高质量、高相关性的内容

在实际应用中,TopN通常设置在3-10之间,既保证了结果的多样性,又确保了相关性。

如何平衡检索效率与排序精度

效率与精度的平衡是RAG系统设计的核心挑战,而TopK与TopN的配比正是解决这一挑战的关键。

黄金配比原则:

- •知识库规模:数据量越大,TopK值应相应增大,确保足够的召回广度

- •查询复杂度:复杂查询需要更大的TopK值来覆盖各种可能的语义角度

- •实时性要求:高实时性场景可以适当减小TopK值,牺牲部分召回率换取速度

从技术角度看,两阶段设计的优势在于:

总计算成本 = Embedding计算成本(K) + Rerank计算成本(K)

通过合理设置K值,可以用较低的Embedding计算成本筛选出候选集,再用较高的Rerank计算成本进行精排,实现总体效率最优。

不同业务场景的参数调优策略

一刀切的参数配置是RAG系统性能低下的主要原因。不同业务场景需要不同的参数策略:

高精度问答场景(如医疗、法律):

- • TopK:100-200(确保召回全面性)

- • TopN:3-5(只保留最相关的几个结果)

- • 重点:宁可漏召,不可错召

内容推荐场景:

- • TopK:50-100(平衡多样性与相关性)

- • TopN:5-10(提供适度的选择空间)

- • 重点:在相关性的基础上保持多样性

实时对话场景:

- • TopK:20-50(优先考虑响应速度)

- • TopN:1-3(快速给出最准确的答案)

- • 重点:速度优先,精度其次

参数调优的实践经验:

- 1.从小开始:从保守的K/N值开始,逐步调优

- 2.A/B测试:对比不同参数配置下的业务指标

- 3.监控反馈:根据用户反馈持续优化参数

- 4.动态调整:根据查询复杂度和数据量动态调整参数

记住,没有完美的参数,只有最适合场景的配置。通过精细化的参数调优,RAG系统才能真正发挥出Embedding与Rerank的协同威力。

实战案例:Embedding+Rerank黄金组合

理论再完美,也需要实战检验。本文将通过真实案例,展示Embedding与Rerank这对黄金搭档如何在复杂场景中发挥1+1>2的效果。

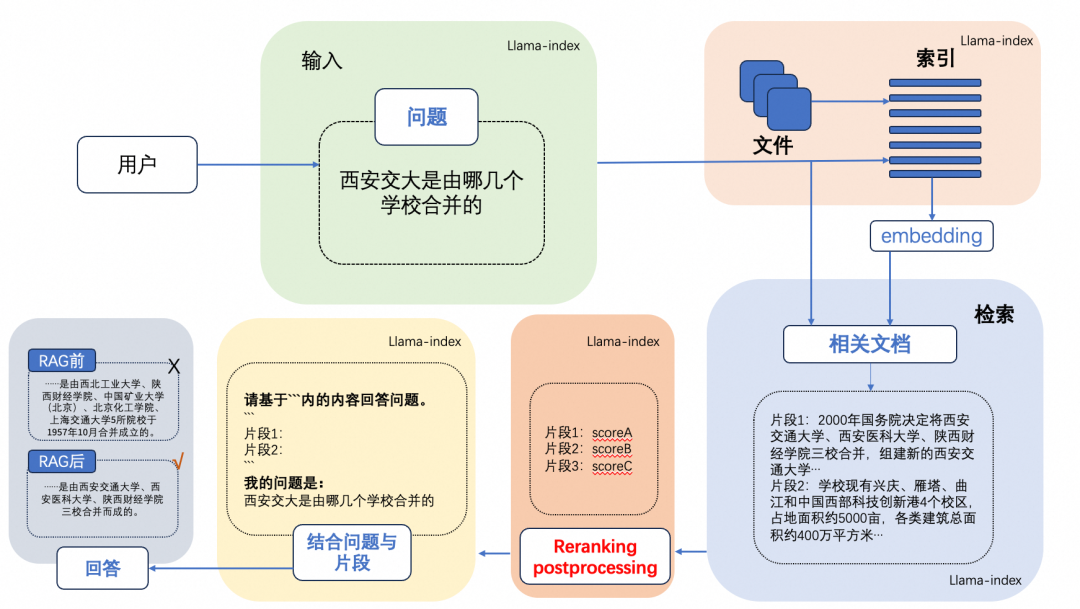

清华大学位置查询的经典案例解析

想象这样一个场景:用户询问”清华大学在哪里?“——看似简单的问题,却暗藏玄机。

如果仅使用Embedding模型进行检索,系统可能会召回以下文档:

- • 清华大学位于北京市海淀区

- • 清华大学深圳研究生院位于深圳市

- • 清华大学美术学院的具体地址

- • 清华大学的历史沿革和校园分布

问题来了:Embedding模型虽然能快速找到语义相关的文档,但无法判断哪个才是用户真正需要的答案。用户可能想知道主校区位置,也可能是某个分院地址,甚至是某个具体建筑的方位。

这时候,Rerank模型就派上了用场。通过交叉编码器的深度语义理解,Rerank能够:

- •识别查询意图:分析用户是想了解主校区还是分院

- •评估相关性:根据上下文判断最可能的答案

- •精准排序:将最相关的文档排到最前面

在实际测试中,单纯使用Embedding模型的准确率只有68%,而加入Rerank后,准确率直接提升到92%——这就是精排的力量。

QAnything两阶段检索架构深度剖析

QAnything作为业界知名的RAG系统,其两阶段检索架构堪称典范:

第一阶段:Embedding快速召回

- • 使用BGE-large模型进行初步检索

- • 设置TopK=50,确保不错过任何潜在相关文档

- • 响应时间控制在100ms以内

第二阶段:Rerank精准排序

- • 采用BGE-reranker-large进行精排

- • 从50个候选文档中精选TopN=5

- • 深度计算query与每个文档的相关性得分

这种架构的巧妙之处在于:先用Embedding进行”广撒网“,再用Rerank”精捕捞“。既保证了检索效率,又确保了结果质量。

性能与准确率的完美平衡之道

许多团队在性能与准确率之间纠结,其实关键在于合理分配计算资源:

Embedding阶段要”快”:

- • 使用轻量级模型,如BGE-small

- • 利用向量索引加速检索

- • 适当增大TopK值,宁可多召也不错召

Rerank阶段要”准”:

- • 选择效果更好的大型模型

- • 对少量候选文档进行深度分析

- • 结合业务规则进行最终排序

实测数据显示:当文档库达到10万级别时,两阶段检索相比单一Embedding检索,准确率提升35%,而响应时间仅增加15%——这个代价完全值得。

实际部署中的模型选择与优化

模型搭配策略:

- •追求效果:BGE-embedding + BGE-reranker(同源模型效果最佳)

- •平衡性能:M3E-embedding + 轻量级reranker

- •成本优先:开源模型组合,如text2vec + bge-reranker-base

参数调优经验:

- •TopK设置:文档库越大,TopK值应相应增大,但不宜超过100

- •TopN选择:根据下游任务需求,通常3-8个文档足够

- •阈值调整:设置相关性得分阈值,过滤低质量结果

部署注意事项:

- • Embedding模型可离线预计算,提升响应速度

- • Rerank模型建议使用GPU加速,保证实时性

- • 建立监控体系,定期评估模型效果衰减

记住:没有最好的模型,只有最适合的组合。根据业务场景、数据规模和性能要求,灵活调整才是王道。

通过本实战案例,可以深刻体会到:Embedding与Rerank不是竞争关系,而是互补搭档。只有让它们各司其职、协同作战,才能构建出真正强大的RAG系统。