2024 年 9 月 25 日 下午 2:48

图片来源:VentureBeat 使用 Midjourney 生成

订阅我们的每日和每周新闻通讯,获取有关行业领先的 AI 报道的最新更新和独家内容。了解更多

艾伦人工智能研究所 (Ai2) 今天发布了 Molmo,这是一个开源的多模态 AI 模型家族,在多个第三方基准测试中超越了 OpenAI 的 GPT-4o、Anthropic 的 Claude 3.5 Sonnet 和 Google 的 Gemini 1.5 等顶级专有竞争对手。

因此,这些模型可以接受和分析用户上传的图像,类似于领先的专有基础模型。

然而,Ai2 在 X 上的一篇帖子中也指出,Molmo 使用的“数据量比专有竞争对手少 1000 倍”——这得益于一些巧妙的新训练技术,这些技术将在下面和保罗·艾伦创立、阿里·法尔哈迪领导的公司发布的技术报告论文中详细介绍。

Ai2 表示,此次发布突出了其对开放研究的承诺,它向更广泛的社区提供高性能模型,包括开放权重和数据——当然,也包括那些寻求完全拥有、控制和定制解决方案的公司。

这紧随 Ai2 两周前发布的另一个开放模型 OLMoE,它是一个“专家混合”或更小的模型组合,旨在提高成本效益。

Molmo 包含四个主要模型,它们具有不同的参数大小和功能:

- Molmo-72B(720 亿个参数或设置——旗舰模型,基于阿里云的 Qwen2-72B 开源模型)

- Molmo-7B-D(“演示模型”,基于阿里的 Qwen2-7B 模型)

- Molmo-7B-O(基于 Ai2 的 OLMo-7B 模型)

- MolmoE-1B(基于 OLMoE-1B-7B 专家混合 LLM,Ai2 表示“在学术基准测试和用户偏好方面几乎与 GPT-4V 的性能相匹配。”)

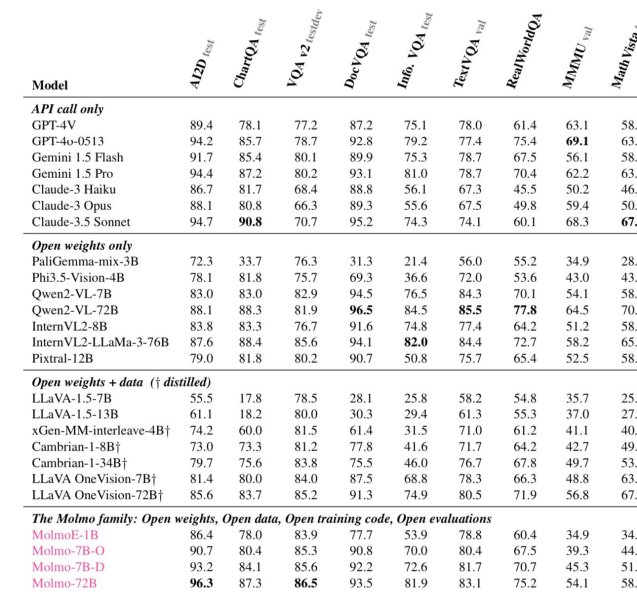

这些模型在各种第三方基准测试中取得了高性能,超过了许多专有替代方案。它们都可以在宽松的 Apache 2.0 许可下使用,允许几乎任何类型的研究和商业化用途(例如企业级)。

值得注意的是,Molmo-72B 在学术评估中处于领先地位,在 11 个关键基准测试中取得了最高得分,在用户偏好方面排名第二,紧随 GPT-4o。

AI 代码库公司 Hugging Face 的机器学习开发者倡导工程师 Vaibhav Srivastav 在 X 上评论了此次发布,强调 Molmo 为封闭系统提供了一种强大的替代方案,为开放的多模态 AI 设置了新的标准。

Molmo by @allen_ai – 开源 SoTA 多模态(视觉)语言模型,击败 Claude 3.5 Sonnet、GPT4V,与 GPT4o 相当?他们发布了四个模型检查点:1. MolmoE-1B,一个具有 1B(活动)7B(总计)的专家混合模型 2. Molmo-7B-O,最开放的 7B 模型

3.… pic.twitter.com/9hpARh0GYT

— Vaibhav (VB) Srivastav (@reach_vb) 2024 年 9 月 25 日

此外,谷歌 DeepMind 机器人研究员 Ted Xiao 在 X 上赞扬了 Molmo 中包含的指向数据,他认为这将改变机器人视觉接地的游戏规则。

Molmo 是一个非常令人兴奋的多模态基础模型发布,特别是对于机器人来说。对指向数据的强调使其成为第一个针对视觉接地优化的开放 VLM——你可以清楚地看到它在 RealworldQA 或 OOD 机器人感知方面的出色表现!https://t.co/F2xRCzogcg pic.twitter.com/VHtu9hT2r9

— Ted Xiao (@xiao_ted) 2024 年 9 月 25 日

这种能力使 Molmo 能够提供视觉解释并更有效地与物理环境交互,这是大多数其他多模态模型目前缺乏的功能。

这些模型不仅性能高,而且完全开放,允许研究人员和开发人员访问和构建最先进的技术。

Molmo 的架构旨在最大限度地提高效率和性能。所有模型都使用 OpenAI 的 ViT-L/14 336px CLIP 模型作为视觉编码器,它将多尺度、多裁剪图像处理成视觉标记。

然后,这些标记通过多层感知器 (MLP) 连接器投影到语言模型的输入空间,并进行池化以降低维度。

语言模型组件是一个仅解码器 Transformer,其选项范围从 OLMo 系列到 Qwen2 和 Mistral 系列,每个系列都提供不同的容量和开放程度。

Molmo 的训练策略涉及两个关键阶段:

- 多模态预训练:在此阶段,模型经过训练,使用人类注释者提供的新收集的详细图像描述来生成标题。这个高质量的数据集名为 PixMo,是 Molmo 强大性能的关键因素。

- 监督微调:然后,模型在各种数据集混合上进行微调,包括标准学术基准测试和新创建的数据集,这些数据集使模型能够处理复杂的现实世界任务,例如文档阅读、视觉推理,甚至指向。

与许多当代模型不同,Molmo 不依赖于来自人类反馈的强化学习 (RLHF),而是专注于精心调整的训练管道,该管道根据模型的预训练状态更新所有模型参数。

Molmo 模型在多个基准测试中显示出令人印象深刻的结果,尤其是在与专有模型相比时。

例如,Molmo-72B 在 DocVQA 上得分 96.3,在 TextVQA 上得分 85.5,在这些类别中都超过了 Gemini 1.5 Pro 和 Claude 3.5 Sonnet。它在 AI2D(Ai2 自己的基准测试,简称“一张图胜过千言万语”,一个包含 5000 多个小学科学图表和 150,000 多个丰富注释的数据集)上也超过了 GPT-4o。

这些模型在视觉接地任务中也表现出色,Molmo-72B 在 RealWorldQA 上取得了最佳性能,使其在机器人和复杂多模态推理中的应用特别有前景。

Ai2 已在其 Hugging Face 空间上提供了这些模型和数据集,并与 Transformers 等流行的 AI 框架完全兼容。

这种开放访问是 Ai2 促进 AI 社区创新和协作的更广泛愿景的一部分。

在接下来的几个月里,Ai2 计划发布更多模型、训练代码和扩展版技术报告,进一步丰富提供给研究人员的资源。

对于那些有兴趣探索 Molmo 功能的人来说,现在可以通过 Molmo 的官方页面访问公共演示和多个模型检查点。