AI 时代的安全与治理:平衡之道

人工智能 (AI) 的潜力巨大,它能够提高效率、降低成本,并提供更深入的客户洞察。然而,要充分发挥 AI 的潜力,企业必须在网络安全和治理之间取得平衡。

AI 基础设施需要灵活适应企业不断变化的方向。网络安全必须保护收入,而治理则需要与内部和整个企业范围内的合规性保持同步。

任何希望安全扩展 AI 的企业都必须不断寻找加强核心基础设施组件的新方法。同样重要的是,网络安全、治理和合规性必须共享一个共同的数据平台,以实现实时洞察。

4CRisk 创始人兼首席执行官 Venky Yerrapotu 表示:“AI 治理定义了一种结构化方法,用于管理、监控和控制 AI 系统的有效运行以及以人为本的 AI 系统的使用和开发。打包或集成的 AI 工具确实存在风险,包括 AI 模型中的偏差、数据隐私问题以及潜在的滥用。”

强大的 AI 基础设施使审计更容易自动化,帮助 AI 团队发现障碍,并识别网络安全、治理和合规性中最显著的差距。

Palo Alto Networks 网络安全高级副总裁兼总经理 Anand Oswal 表示:“由于目前几乎没有行业认可的治理或合规框架可供遵循,因此组织必须实施适当的护栏,以安全地利用 AI 进行创新。否则代价过于高昂,因为攻击者正在积极寻找最薄弱的环节:AI。”

恶意攻击者的目标各不相同,从经济利益到破坏或摧毁敌对国家的 AI 基础设施,所有攻击者都在寻求改进其攻击手段。恶意攻击者、网络犯罪团伙和国家行为者都比最先进的企业或网络安全供应商行动更快。

Cato Networks 首席安全策略师 Etay Maor 表示:“监管和 AI 就如同驴子和保时捷之间的赛跑。根本没有竞争。监管机构总是追赶技术,但在 AI 领域,这种情况尤其明显。但问题是:威胁行为者不会遵守规则。他们不受监管约束,并积极寻找方法来破解新 AI 技术的限制。”

以中国、朝鲜和俄罗斯为基地的网络犯罪和国家支持的组织正在积极针对物理和 AI 基础设施,并使用 AI 生成的恶意软件更有效地利用漏洞,而且这些漏洞往往无法被传统的网络安全防御识别。

随着资金雄厚的网络犯罪组织和国家对各国和企业的 AI 基础设施发起攻击,安全团队仍然面临着输掉 AI 战争的风险。

一种有效的安全措施是模型水印,它将唯一的标识符嵌入 AI 模型中,以检测未经授权的使用或篡改。此外,AI 驱动的异常检测工具对于实时威胁监控至关重要。

所有接受 VentureBeat 匿名采访的公司都在积极使用红队技术。例如,Anthropic 证明了中间人设计在弥合模型测试中的安全漏洞方面的价值。

Seal Security 首席执行官 Itamar Sher 表示:“我认为中间人设计将在未来很长一段时间内与我们共存,以提供上下文智能,利用人类直觉来微调大型语言模型 (LLM),并减少幻觉的发生。”

每个发布到生产环境中的模型都是组织需要保护的新威胁面。Gartner 的年度 AI 采用调查发现,73% 的企业已经部署了数百甚至数千个模型。

恶意攻击者利用模型中的弱点,使用广泛的攻击技术。NIST 的人工智能风险管理框架对于任何构建 AI 基础设施的人来说都是必不可少的文档,它提供了对最普遍的攻击类型的见解,包括数据中毒、规避和模型窃取。

AI Security 写道:“AI 模型通常通过 API 查询来反向工程其功能。”

CISO 警告称,构建正确的 AI 基础设施也是一个不断变化的目标。Reco 的 CISO Merritt Baer 表示:“即使您没有在明确的以安全为中心的方面使用 AI,您也在以对了解和保护环境至关重要的方式使用 AI。”

正如操作系统具有特定的设计目标,力求实现问责制、可解释性、公平性、稳健性和透明性一样,AI 基础设施也是如此。

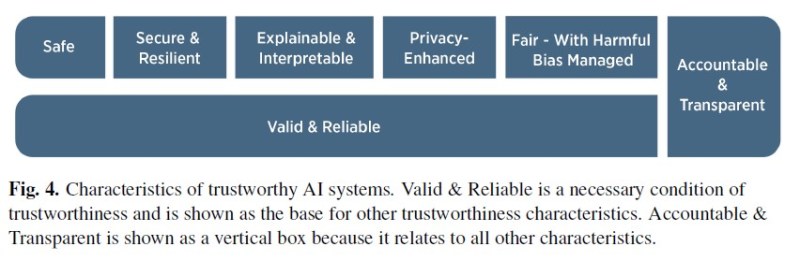

NIST 框架贯穿始终的是一个面向信任的设计路线图,它提供了一个实用、务实的定义来指导基础设施架构师。NIST 强调,有效性和可靠性是 AI 基础设施中必不可少的设计目标,尤其是在 AI 基础设施中,以提供可信赖、可靠的结果和性能。

来源:NIST,2023 年 1 月,DOI: 10.6028/NIST.AI.100-1.

AI 系统和模型必须以道德、安全和负责任的方式开发、部署和维护。治理必须旨在提供算法透明度、公平性、问责制和隐私方面的流程、可见性和实时更新。强大的治理的基石在于持续监控、审计模型并使其与社会价值观保持一致。

治理框架应从开发的最初阶段就集成到 AI 基础设施中。“以治理为设计”将这些原则嵌入到流程中。

WinWire 首席技术官 Vineet Arora 表示:“实施道德 AI 框架需要关注安全、偏差和数据隐私方面,不仅在解决方案的设计过程中,而且在所有护栏的测试和验证过程中,然后再将解决方案部署给最终用户。”

识别和减少 AI 模型中的偏差对于提供准确、符合道德的成果至关重要。组织需要站出来,对 AI 基础设施如何监控、控制和改进以减少和消除偏差承担责任。

对 AI 基础设施负责的组织依赖于对抗性去偏差训练模型,以最大程度地减少受保护属性(包括种族或性别)与结果之间的关系,从而降低歧视风险。另一种方法是对训练数据进行重采样,以确保与不同行业相关的平衡表示。

NIST 表示:“将透明度和可解释性嵌入到 AI 系统的设计中,使组织能够更好地了解决策是如何做出的,从而更有效地检测和纠正有偏差的输出。”提供有关 AI 模型如何做出决策的透明见解,使组织能够更好地检测、纠正和从偏差中学习。

IBM 的 AI 伦理委员会负责监督公司的 AI 基础设施和 AI 项目,确保每个项目在道德上符合行业和内部标准。IBM 最初建立了一个治理框架,其中包括他们所谓的“焦点”,即具有 AI 专门知识的中层管理人员,他们会审查正在开发的项目,以确保符合 IBM 的信任和透明度原则。

IBM 表示,该框架有助于在项目层面降低和控制风险,从而减轻对 AI 基础设施的风险。

IBM 首席隐私和信任官 Christina Montgomery 表示:“我们的 AI 伦理委员会在监督我们内部的 AI 治理流程方面发挥着至关重要的作用,创建合理的内部护栏,以确保我们以负责任和安全的方式将技术引入世界。”

治理框架必须从设计阶段就嵌入到 AI 基础设施中。以治理为设计理念确保透明度、公平性和问责制成为 AI 开发和部署的组成部分。

网络安全、合规性和治理之间的差距正在随着 AI 基础设施用例的加速而缩小。VentureBeat 的研究出现了两种趋势:自主 AI 和可解释 AI。拥有 AI 基础设施的组织正在寻求灵活地调整其平台,以充分利用每种趋势。

在这两者中,可解释 AI 处于起步阶段,它提供洞察力以提高模型透明度和解决偏差问题。Reputation 首席执行官 Joe Burton 表示:“正如我们期望商业决策具有透明度和合理性一样,AI 系统也应该能够清楚地解释它们是如何得出结论的。这有助于建立信任,并确保问责制和持续改进。”

Burton 补充道:“通过关注这些治理支柱——数据权利、监管合规性、访问控制和透明度——我们可以利用 AI 的能力来推动创新和成功,同时维护最高标准的诚信和责任。”