AI 安全指数:谁在为未来负责?

人工智能的浪潮席卷全球,但随之而来的安全问题也日益凸显。近期发布的 AI 安全指数,对六家领先的 AI 公司进行了风险评估和安全程序的评分,结果令人深思。

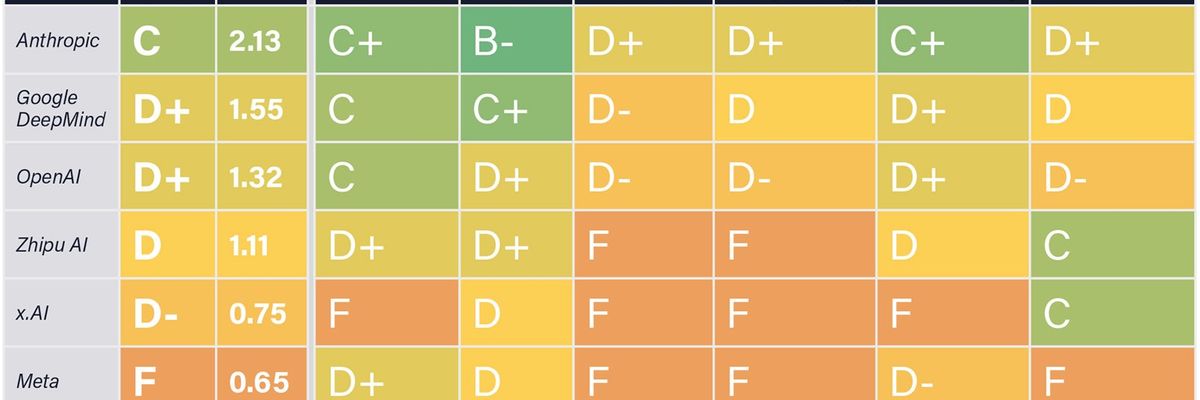

Anthropic 以 C 的总分位居榜首,而 Google DeepMind、Meta、OpenAI、xAI 和 Zhipu AI 等其他五家公司则获得了 D+ 或更低的评分,其中 Meta 更是直接不及格。

这份报告的发布并非为了羞辱任何公司,而是为了鼓励它们改进。MIT 物理学教授兼生命未来研究所所长 Max Tegmark 表示,希望公司高管将这份指数视为大学看待美国新闻与世界报道排行榜一样:他们可能不喜欢被评分,但如果评分存在并受到关注,他们会感到有动力在明年做得更好。

Tegmark 还希望帮助这些公司安全团队的研究人员。如果一家公司没有感受到外部压力来满足安全标准,那么公司里的其他人可能会将你视为一个讨厌的人,一个试图减缓进度、给机器添堵的人。但如果这些安全研究人员突然要负责提升公司的声誉,他们就会获得资源、尊重和影响力。

生命未来研究所是一个非营利组织,致力于帮助人类避免强大技术带来的真正糟糕的结果,近年来,该组织一直关注人工智能。2023 年,该组织发布了被称为“暂停信”的信件,呼吁 AI 实验室暂停开发高级模型六个月,并利用这段时间制定安全标准。埃隆·马斯克和史蒂夫·沃兹尼亚克等大人物签署了这封信(截至目前,已有 33,707 人签署),但这些公司并没有暂停。

这份新报告也可能被这些公司忽视。《IEEE Spectrum》联系了所有公司征求意见,但只有 Google DeepMind 做出了回应,并发表了以下声明:“虽然该指数包含了 Google DeepMind 的一些 AI 安全工作,并反映了行业采用的基准,但我们对 AI 安全的全面方法超出了该指数的范围。我们致力于随着技术的进步不断改进我们的安全措施。”

AI 安全指数对公司在六个方面的表现进行了评分:风险评估、当前危害、安全框架、生存安全策略、治理和问责制以及透明度和沟通。该指数利用公开信息,包括相关研究论文、政策文件、新闻报道和行业报告。评估人员还向每家公司发送了一份问卷,但只有 xAI 和中国公司 Zhipu AI(目前拥有最强大的中文语言 LLM)填写了问卷,这提高了这两家公司在透明度方面的得分。

评分由七位独立评估人员给出,其中包括加州大学伯克利分校教授 Stuart Russell 和图灵奖获得者 Yoshua Bengio 等大人物,他们曾表示超级智能 AI 可能对人类构成生存风险。评估人员还包括专注于 AI 近期危害(如算法偏差和有毒语言)的 AI 领导者,例如卡内基梅隆大学的 Atoosa Kasirzadeh 和 Encode Justice 的创始人 Sneha Revanur。

总的来说,评估人员并不满意。Russell 表示:“AI 安全指数项目的结果表明,虽然 AI 公司在‘安全’方面开展了大量活动,但这些活动尚未取得显著成效。特别是,目前没有任何活动能够提供任何形式的安全定量保证;鉴于当前通过在海量数据上训练巨型黑盒来实现 AI 的方法,似乎也不可能提供此类保证。随着这些 AI 系统变得越来越大,这种情况只会变得更加困难。换句话说,当前的技术方向可能永远无法提供必要的安全保证,在这种情况下,它实际上是一个死胡同。”

Anthropic 在总体评分和特定评分方面都获得了最高分,在当前危害方面获得了唯一的 B-。报告指出,Anthropic 的模型在领先的安全基准测试中获得了最高分。该公司还制定了“负责任的扩展政策”,要求该公司评估其模型造成灾难性危害的可能性,并且不会部署该公司认为风险过高的模型。

所有六家公司在生存安全策略方面的评分都特别低。评估人员指出,所有公司都宣布了构建通用人工智能 (AGI) 的意图,但只有 Anthropic、Google DeepMind 和 OpenAI 制定了确保 AGI 与人类价值观保持一致的策略。Tegmark 表示:“事实是,没有人知道如何控制一个比我们聪明得多的新物种。审查小组认为,即使是那些制定了一些早期策略的公司,他们的策略也不够充分。”

虽然这份报告没有对 AI 公司或政策制定者提出任何建议,但 Tegmark 坚信其发现表明迫切需要监管监督,即一个类似于美国食品药品监督管理局的政府机构,在 AI 产品上市前对其进行审批。

Tegmark 表示:“我认为这些公司的领导者陷入了他们无法摆脱的竞赛,无论他们多么善良。如今,公司不愿意为了安全测试而放慢速度,因为他们不想让竞争对手抢占市场。而如果存在安全标准,那么就会有商业压力看谁能够最先满足安全标准,因为这样他们就可以最先销售并赚钱。”