AI 赋能:声音变幻成街景,科技开启“听觉视觉”新纪元

美国德州大学奥斯汀分校的研究团队,利用生成式人工智能(AI)技术,将声音录音转化为逼真的街景影像。这项突破性的研究成果,展现了机器学习在模拟人类感官体验方面的巨大潜力,也为我们理解城市环境和人类感知之间的复杂关系打开了新的大门。

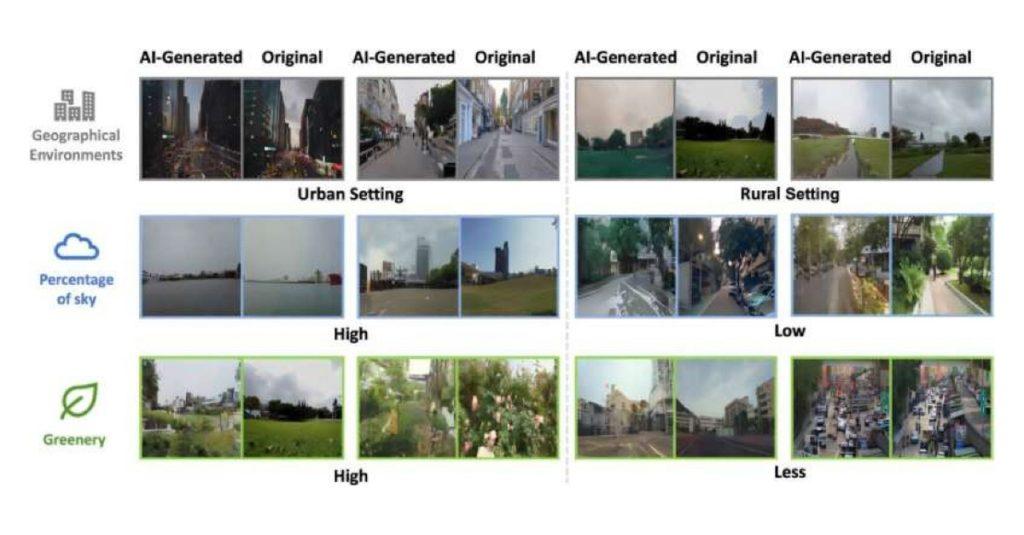

研究团队通过收集来自北美、亚洲和欧洲城市的 YouTube 视频数据,训练 AI 模型,使其能够从 10 秒的音频片段中生成高分辨率的街景图像。这些图像不仅在天空、绿地和建筑物比例上与真实照片高度相似,而且在细节方面也展现出惊人的准确性。

研究人员将 AI 生成的图像与真实照片进行对比,发现 AI 模型能够准确地反映出声音中的时间信息,例如交通噪音或夜间昆虫的鸣叫,以及建筑风格和距离比例等细节。更令人惊叹的是,人类参与者在识别与音频片段相匹配的 AI 生成图像时,平均准确率高达 80%。

这项研究表明,AI 不仅能够模拟人类通过声音想象场景的能力,还能通过声音细节呈现天气状况和建筑风格等信息,为我们理解城市环境和人类感知之间的复杂关系提供了新的视角。这项技术有望在未来应用于地理空间分析、城市规划和多感官互动等领域,为我们提供更加立体和深入的城市体验。

这项研究成果,不仅是科技进步的体现,更是人类对自身感知能力的探索和理解的深化。