步步为营:MBZUAI 推出全新 AI 模型 LlamaV-o1,引领多模态推理新纪元

在人工智能领域,推理能力一直是科学家们孜孜不倦追求的目标。近日,来自穆罕默德·本·扎耶德人工智能大学 (MBZUAI) 的研究人员宣布推出 LlamaV-o1,这款先进的 AI 模型在文本和图像领域展现出非凡的推理能力,能够解决一些最复杂的推理任务。

LlamaV-o1 融合了尖端的课程学习和先进的优化技术,例如束搜索 (Beam Search),在多模态 AI 系统的逐步推理方面树立了新的标杆。研究人员在今天发布的技术报告中写道:“推理是解决复杂多步骤问题的一项基本能力,尤其是在视觉环境中,需要逐步理解。” 经过针对需要精确度和透明度的推理任务的微调,该 AI 模型在从解读财务图表到诊断医学图像等各种任务中超越了许多同类模型。

与该模型同步发布的还有 VRC-Bench,这是一个专门为评估 AI 模型逐步解决问题的能力而设计的基准测试。VRC-Bench 包含超过 1000 个不同的样本和 4000 多个推理步骤,已被誉为多模态 AI 研究领域的一项突破性成果。

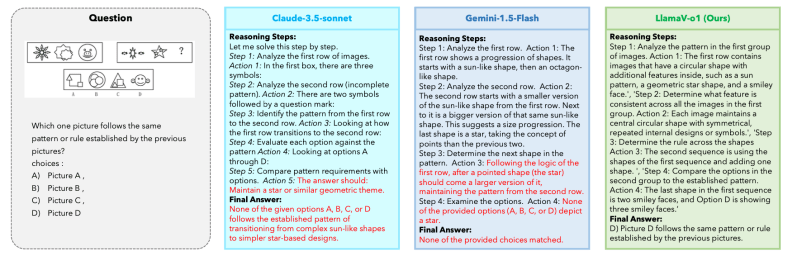

LlamaV-o1 在识别模式和解决复杂的视觉任务方面超越了 Claude-3.5-Sonnet 和 Gemini-1.5-Flash 等竞争对手,如 VRC-Bench 基准测试中的这个示例所示。该模型提供了逐步解释,得出了正确答案,而其他模型则无法匹配已建立的模式。(来源:arxiv.org)

传统的 AI 模型通常侧重于提供最终答案,而很少提供它们如何得出结论的见解。然而,LlamaV-o1 强调逐步推理,这种能力模仿了人类解决问题的方式。这种方法允许用户看到模型采取的逻辑步骤,使其在可解释性至关重要的应用中特别有价值。

研究人员使用针对推理任务优化的 LLaVA-CoT-100k 数据集训练了 LlamaV-o1,并使用 VRC-Bench 评估了其性能。结果令人印象深刻:LlamaV-o1 的推理步骤得分达到 68.93,超过了 Llava-CoT (66.21) 等知名开源模型,甚至超过了一些闭源模型,例如 Claude-3.5-Sonnet。

研究人员解释说:“通过利用束搜索的效率以及课程学习的渐进结构,所提出的模型逐步地获得了技能,从更简单的任务开始,例如方法摘要和问题衍生的字幕,并逐步发展到更复杂的多步骤推理场景,确保了优化的推理和强大的推理能力。”

该模型的系统化方法也使其比竞争对手更快。“LlamaV-o1 在六个基准测试中的平均得分方面获得了 3.8% 的绝对增益,同时在推理扩展期间速度提高了 5 倍,”研究小组在他们的报告中指出。这种效率对于希望大规模部署 AI 解决方案的企业来说是一个关键的卖点。

LlamaV-o1 对可解释性的强调满足了金融、医疗和教育等行业的关键需求。对于企业来说,能够追踪 AI 决策背后的步骤可以建立信任并确保符合法规。

以医学影像为例。使用 AI 分析扫描的放射科医生不仅需要诊断结果,还需要了解 AI 如何得出该结论。这就是 LlamaV-o1 的优势所在,它提供了透明的逐步推理,专业人员可以审查和验证。

该模型在图表和图表理解方面也表现出色,这对于财务分析和决策至关重要。在 VRC-Bench 上的测试中,LlamaV-o1 在需要解释复杂视觉数据的任务中始终优于竞争对手。

但该模型不仅仅适用于高风险应用。它的多功能性使其适用于各种任务,从内容生成到对话代理。研究人员专门调整了 LlamaV-o1,使其在现实世界场景中表现出色,利用束搜索来优化推理路径并提高计算效率。

束搜索允许模型并行生成多个推理路径,并选择最合理的路径。这种方法不仅提高了准确性,还降低了运行模型的计算成本,使其成为各种规模企业的理想选择。

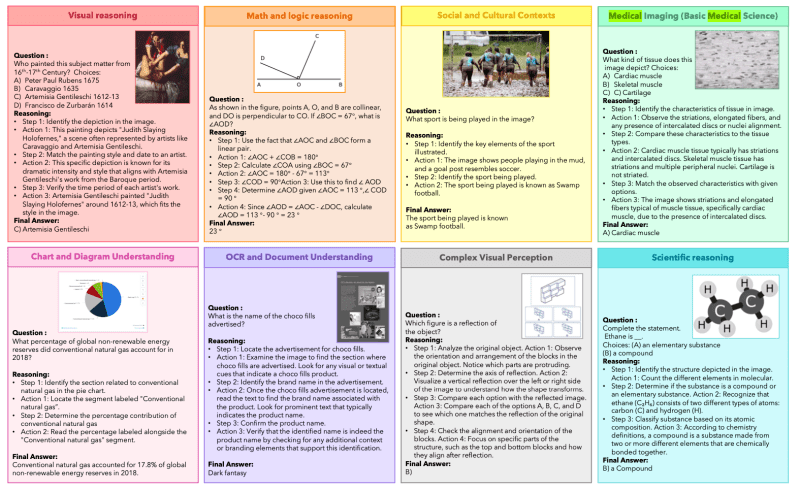

LlamaV-o1 在各种推理任务中表现出色,包括视觉推理、科学分析和医学影像,如 VRC-Bench 基准测试中的这个示例所示。它的逐步解释提供了可解释且准确的结果,在图表理解、文化背景分析和复杂视觉感知等任务中优于竞争对手。(来源:arxiv.org)

VRC-Bench 的发布与该模型本身一样重要。与传统基准测试不同,传统基准测试只关注最终答案的准确性,VRC-Bench 评估单个推理步骤的质量,对 AI 模型的能力进行更细致的评估。

研究人员解释说:“大多数基准测试主要关注最终任务的准确性,而忽略了中间推理步骤的质量。[VRC-Bench] 提供了一套多样化的挑战,涵盖八个不同的类别,从复杂的视觉感知到科学推理,总共包含超过 4000 个推理步骤,能够对 LLM 在多个步骤中执行准确且可解释的视觉推理的能力进行稳健的评估。”

这种对逐步推理的关注在科学研究和教育等领域尤为重要,在这些领域,解决方案背后的过程可能与解决方案本身一样重要。通过强调逻辑连贯性,VRC-Bench 鼓励开发能够处理现实世界任务的复杂性和模糊性的模型。

LlamaV-o1 在 VRC-Bench 上的性能充分说明了它的潜力。该模型在 MathVista 和 AI2D 等基准测试中的平均得分达到 67.33%,超过了 Llava-CoT (63.50%) 等其他开源模型。这些结果将 LlamaV-o1 定位为开源 AI 领域的领导者,缩小了与 GPT-4o 等专有模型之间的差距,GPT-4o 的得分达到 71.8%。

虽然 LlamaV-o1 代表着重大突破,但它并非没有局限性。与所有 AI 模型一样,它受到其训练数据的质量的限制,并且可能难以处理高度技术性或对抗性的提示。研究人员还告诫不要在可能造成严重后果的高风险决策场景中使用该模型,例如医疗保健或财务预测。

尽管存在这些挑战,LlamaV-o1 突出了能够无缝集成文本、图像和其他数据类型的多模态 AI 系统日益增长的重要性。它的成功强调了课程学习和逐步推理在弥合人类和机器智能之间差距方面的潜力。

随着 AI 系统越来越多地融入我们的日常生活,对可解释模型的需求只会继续增长。LlamaV-o1 证明了我们不必为了透明度而牺牲性能,并且 AI 的未来并不止于给出答案。它在于向我们展示它是如何做到的。

也许这才是真正的里程碑:在一个充斥着黑盒解决方案的世界里,LlamaV-o1 打开了盖子。