Mistral 升级开源代码模型 Codestral,剑指开发者市场

Mistral 近日宣布升级其开源代码模型 Codestral,推出全新版本 Codestral 25.01。该模型在架构上进行了优化,旨在成为“同级别代码模型的领跑者”,并宣称速度是上一代的两倍。

与初代 Codestral 一样,Codestral 25.01 针对低延迟、高频操作进行了优化,支持代码纠错、测试生成和中间填充等任务。Mistral 表示,该模型对于拥有更多数据和模型驻留用例的企业来说将非常有用。

基准测试表明,Codestral 25.01 在 Python 代码测试中表现出色,在 HumanEval 测试中得分高达 86.6%。它超越了上一代 Codestral、Codellama 70B Instruct 和 DeepSeek Coder 33B instruct。

目前,Codestral 25.01 可供 Mistral IDE 插件合作伙伴的开发者使用。用户可以通过代码助手 Continue 在本地部署 Codestral 25.01,也可以通过 Mistral 的 la Plateforme 和 Google Vertex AI 访问模型的 API。该模型目前在 Azure AI Foundry 上提供预览版,并将在不久后登陆 Amazon Bedrock。

Mistral 于去年 5 月发布了 Codestral,这是其首款专注于代码的模型。这款拥有 220 亿参数的模型能够以 80 种不同的语言编写代码,并超越了其他以代码为中心的模型。此后,Mistral 又发布了 Codestral-Mamba,这是一个基于 Mamba 架构的代码生成模型,能够生成更长的代码字符串并处理更多输入。

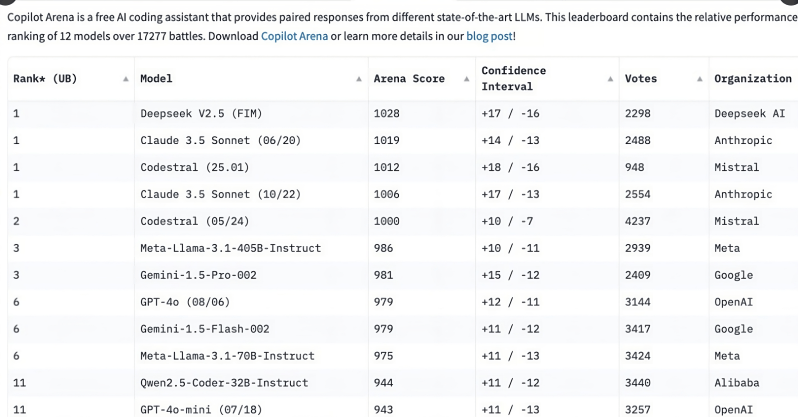

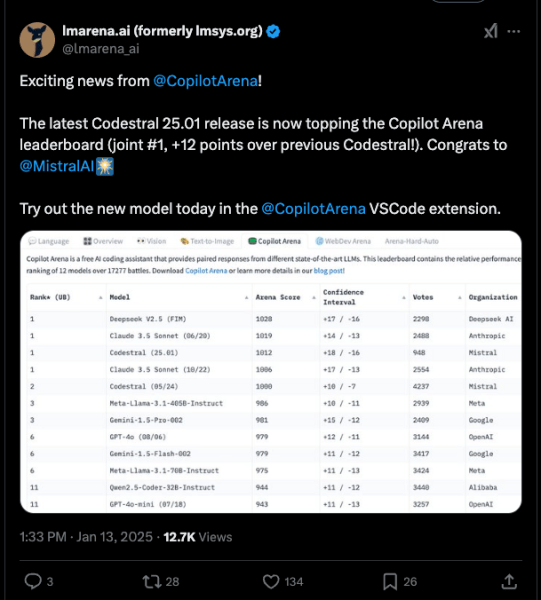

Codestral 25.01 的出现似乎引起了广泛的关注。在 Mistral 发布公告后仅仅几个小时,该模型就已经在 Copilot Arena 的排行榜上快速攀升。

代码编写是基础模型最早的功能之一,即使是像 OpenAI 的 o3 和 Anthropic 的 Claude 这样的通用模型也是如此。然而,在过去的一年里,专门针对代码的模型得到了改进,并且通常比更大的模型表现更好。

仅在过去一年中,就有几个专门针对代码的模型被提供给开发者。阿里巴巴在 11 月发布了 Qwen2.5-Coder。中国的 DeepSeek Coder 在 6 月成为首个在编码方面超越 GPT-4 Turbo 的模型。微软还发布了 GRIN-MoE,这是一个基于专家混合 (MOE) 的模型,可以编写代码并解决数学问题。

关于选择一个学习所有内容的通用模型还是一个只知道如何编码的专注模型,这场永恒的辩论还没有答案。一些开发者更喜欢在像 Claude 这样的模型中找到的广泛选项,但编码模型的激增表明了对专门性的需求。由于 Codestral 是在代码数据上训练的,因此它当然比编写电子邮件更擅长编码任务。