全球最大液冷GPU集群:xAI Colossus的超级计算力

由Supermicro和NVIDIA携手打造的xAI团队正在构建全球最大的液冷GPU集群,名为Colossus。这个庞大的AI超级计算机拥有超过10万个NVIDIA HGX H100 GPU,数艾字节的存储空间以及闪电般的网络速度,旨在训练和驱动xAI开发的生成式AI聊天机器人Grok。

这个耗资数十亿美元的数据中心位于田纳西州孟菲斯,从一个空荡荡的建筑,没有必要的电力发电机、变压器或多厅结构,到一个生产AI超级计算机,仅用了122天。为了让世界了解xAI Colossus集群的非凡成就,VentureBeat很高兴与Supermicro合作,由ServeTheHome制作了这段独家详细的视频导览。

pic.twitter.com/eVdrVdi3b8 [pic.twitter.com]

— Supermicro (@Supermicro_SMCI) October 25, 2024

以下是这个庞大工程的亮点概述。

当你着手构建全球最大的AI超级计算机时,从一开始就清楚地知道,需要大量的计算能力。它必须准备好安装,并在第一天投入运营。并且,整个解决方案需要根据xAI的独特需求进行定制。

设计采用了一种相当常见的架空地板数据中心,电力位于上方,液冷管道通向下方设施的冷水机。四个计算中心中的每一个都拥有大约25,000个NVIDIA GPU,以及所有内置的存储、光纤高速网络和电力。

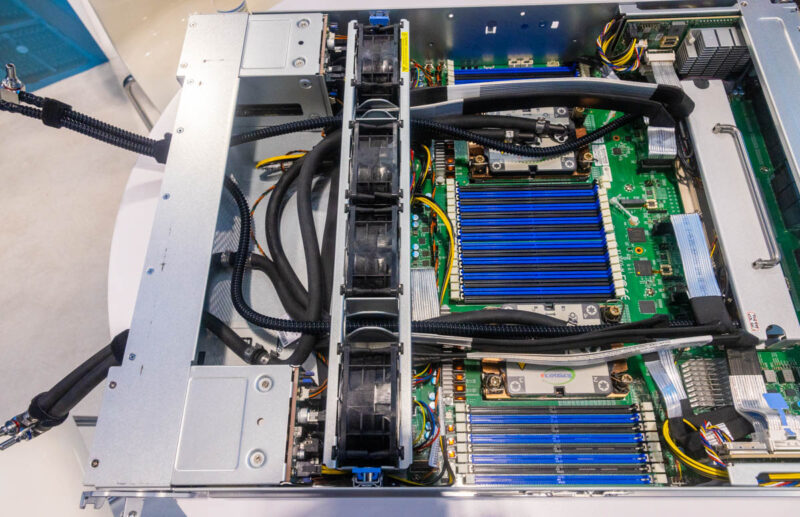

XAI Colossus数据中心Supermicro液冷节点低角度,由ServeTheHome提供

XAI Colossus数据中心Supermicro液冷节点低角度,由ServeTheHome提供

从那里开始,事情变得更加专业。每个集群都包含Colossus的基本构建模块:Supermicro液冷机架。每个机架包含八个Supermicro 4U通用GPU系统,其中包括液冷的NVIDIA HGX H100 8-GPU和两个液冷的x86 CPU。因此,每个机架包含64个NVIDIA Hopper GPU。八个这样的GPU服务器,加上一个Supermicro冷却液分配单元(CDU)和冷却液分配歧管(CDM)构成一个机架。机架以八组的形式排列,每组包含512个GPU,以及一个网络机架,为更大的系统提供微集群。

xAI Colossus数据中心的Supermicro 4U通用GPU液冷服务器是当今最密集、最先进的AI服务器,拥有复杂的液冷系统,并且能够在不从机架中取出系统的情况下进行维护。

XAI Colossus数据中心Supermicro 4U通用GPU液冷服务器特写,由ServeTheHome提供

XAI Colossus数据中心Supermicro 4U通用GPU液冷服务器特写,由ServeTheHome提供

每个服务器上方的水平1U机架冷却液分配歧管(CDM)将冷液送入,并将温液送出;快速断开连接使液冷设备能够快速简便地用一只手拆卸或重新安装,以露出两个底部托盘。机架配备了八个Supermicro 4U通用GPU系统,用于液冷的NVIDIA HGX H100和HGX H200 Tensor Core GPU。每个系统的顶部托盘都容纳了NVIDIA HGX H100 8-GPU复杂结构和NVIDIA HGX板上用于冷却GPU的冷板。底部托盘容纳了主板、CPU、RAM和PCIe交换机,以及双插槽CPU上的冷板。

独特的是,Supermicro的主板在底部托盘上集成了四个Broadcom PCIe交换机,这些交换机在当今几乎所有NVIDIA HGX服务器中使用,位于主板的右侧,而不是将这些交换机放在单独的主板上。与行业中其他AI服务器不同,其他AI服务器在制造后将液冷添加到风冷设计中,Supermicro的服务器从一开始就被设计为液冷,并配备了定制的液冷块。这种紧凑的功率、可访问性和可维护性使这些系统具有极高的可扩展性,并在行业中独树一帜。

Supermicro 4U通用GPU系统,用于液冷的NVIDIA HGX H100和HGX H200,在SC23上展示,由ServeTheHome提供

Supermicro 4U通用GPU系统,用于液冷的NVIDIA HGX H100和HGX H200,在SC23上展示,由ServeTheHome提供

此外,每个CDU都有自己的监控系统,用于监控流量、温度和其他关键功能,这些功能与中央管理界面相连。每个CDU都配备了冗余泵和电源,因此如果一个发生故障,可以在几分钟内进行维护或更换,而不会中断运行系统。

Supermicro服务器仍然使用系统风扇来冷却DIMM、电源、低功耗基板管理控制器、NIC和其他电子元件。为了保持每个机架的冷却中性,服务器风扇从前面吸入较冷的空气,并将较热的空气通过液冷的后门热交换器排出。从Supermicro的液冷GPU服务器以及存储、CPU计算集群和网络组件中去除额外的热量。与风冷服务器相比,风扇使用的功率大大降低,从而降低了每个服务器所需的功率。

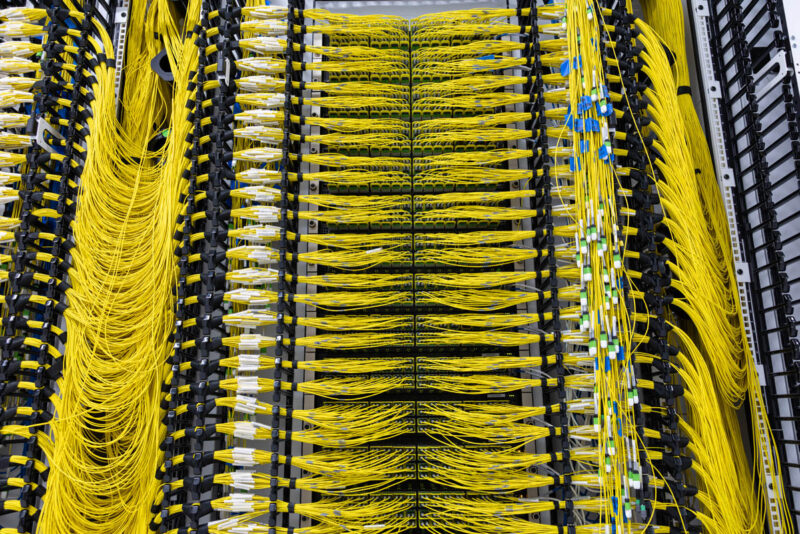

数据中心的庞大网络运行在NVIDIA Spectrum-X以太网网络平台上,它被用于数据中心,以扩展其庞大的AI集群,这是其他任何技术都无法比拟的。Spectrum-X是一个尖端的网络平台,提供快速可靠的数据传输,旨在满足AI工作负载的高要求。它提供诸如更智能的数据路由、减少延迟和更好地控制网络流量等功能。它还包括增强的AI结构可视性和监控,使其成为共享基础设施环境中大型AI项目的理想选择。

每个集群都使用NVIDIA Bluefield-3 SuperNIC,提供每秒400吉比特的网络速度。它与任何台式机以太网电缆使用的基本技术相同,但在数据中心,它是400GbE,或者说每个光纤连接的速度快400倍。每个系统九个链路提供每GPU计算服务器3.6Tbps的带宽。GPU的RDMA(远程直接内存访问)网络构成了大部分带宽。每个GPU都与自己的NVIDIA Bluefield-3 SuperNIC和Spectrum-X网络技术配对。

xAI Colossus数据中心交换机光纤1,由ServeTheHome提供

xAI Colossus数据中心交换机光纤1,由ServeTheHome提供

除了GPU RDMA网络之外,CPU也获得了400GbE连接,它使用完全不同的交换机结构。xAI为其GPU运行一个网络,为集群的其余部分运行另一个网络,这是高性能计算集群中非常常见的架构设计。

NVIDIA Spectrum SN5600是一款64端口800Gb以太网交换机,可以拆分并运行128个400吉比特以太网链路,以确保NVIDIA GPU和整个集群以最大性能水平运行和扩展。它可以卸载各种安全协议,使用高级流量管理来避免网络拥塞,并处理集群中所有CPU超级计算机任务,这是世界上首次部署这种类型的交换机之一。

总而言之,这项庞大的工程在规模上超越了之前尝试过的任何超级计算机。我们将继续关注xAI与Supermicro和NVIDIA携手合作,在超级计算的新时代进一步突破界限。

深入了解Colossus!不要错过上面的视频中的详细导览。

赞助文章是由支付文章费用或与VentureBeat有业务关系的公司制作的内容,并且始终明确标明。有关更多信息,请联系sales@venturebeat.com。