科技巨头转向:谷歌放弃 AI 武器和监控禁令,引发行业震荡

谷歌近期悄然修改了其备受瞩目的 AI 原则,取消了长期以来禁止将人工智能用于武器和监控系统的规定。这一举动标志着这家科技巨头在 AI 伦理立场上的重大转变,引发了前员工和行业专家的担忧,他们认为此举可能重塑硅谷对 AI 安全的态度。

谷歌于 2018 年发布的 AI 原则曾被视为行业负责任 AI 开发的标杆,其中明确禁止开发用于武器或监控的 AI 技术。然而,最新修订的原则删除了四项具体禁令,包括可能造成整体伤害的技术、武器应用、监控系统以及违反国际法和人权的技术。

谷歌现声称将“减轻意外或有害后果”,并与“广泛接受的国际法和人权原则”保持一致。这一转变引发了人们对谷歌动机的质疑,尽管该公司坚称这些变化是经过长期酝酿的。

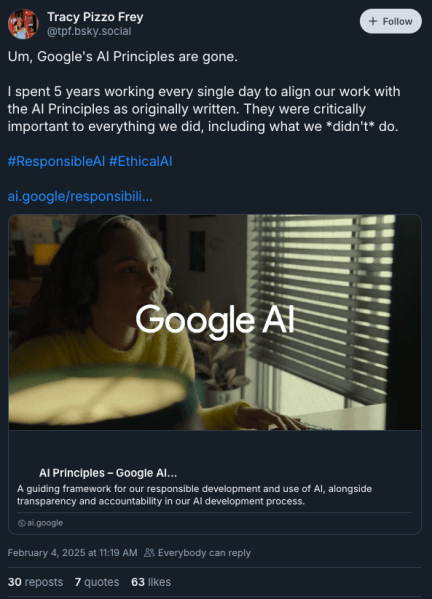

谷歌前员工特蕾西·皮佐·弗雷在社交媒体平台 BlueSky 上表示:“最后的防线消失了,现在是无所顾忌的时代。” 弗雷曾担任 Google Cloud 的高级产品管理、参与和负责任 AI 总监,负责实施谷歌最初的 AI 原则。

(图片来源:BlueSky / 特蕾西·皮佐·弗雷)

(图片来源:BlueSky / 特蕾西·皮佐·弗雷)

这一政策调整发生在 AI 技术飞速发展、关于该技术适当监管的争论日益激烈的关键时刻。一些人认为,谷歌此举可能表明其对类似军事合作持开放态度,而谷歌最初的 AI 原则正是源于 2018 年员工对“Maven 项目”的抗议,该项目涉及为无人机视频分析开发 AI 技术。

尽管谷歌在修订后的原则中保留了一些原有伦理框架的元素,但其重点已从禁止特定应用转向强调风险管理。这种方法更接近于 NIST AI 风险管理框架等行业标准,但批评者认为,它对潜在有害应用的限制不够明确。

弗雷在接受 VentureBeat 采访时表示:“即使严格程度不同,伦理考量对于创造良好的 AI 仍然至关重要。” 她强调,伦理考量有助于提高 AI 产品的有效性和可访问性。

行业观察人士认为,谷歌的这一政策变化可能会影响其他科技公司对 AI 伦理的态度。谷歌最初的 AI 原则为企业在 AI 开发中的自我监管树立了先例,许多企业都将谷歌视为负责任 AI 实施的指南。

谷歌 AI 原则的修改反映了科技行业在快速创新和伦理约束之间日益加剧的矛盾。随着 AI 开发竞争的加剧,企业面临着在负责任的开发和市场需求之间取得平衡的压力。

弗雷表示:“我担心的是,技术发展速度过快,而越来越多的安全保障正在被移除。” 她对在没有充分评估潜在后果的情况下,为了快速发布 AI 产品而产生的竞争压力表示担忧。

此次修订还引发了人们对谷歌内部决策过程的质疑,以及在没有明确禁令的情况下,员工如何应对伦理考量。弗雷在谷歌任职期间,曾建立了审查流程,汇集不同观点,评估 AI 应用的潜在影响。

尽管谷歌坚持其对负责任 AI 开发的承诺,但取消特定禁令标志着其在为 AI 应用建立明确伦理界限方面,从之前的领导地位发生了重大转变。随着人工智能技术的不断发展,业界将密切关注这一转变对 AI 开发和监管的整体格局的影响。