“`html

谷歌云Next 2025:AI巨头强势回归,企业级AI新格局

订阅我们的每日和每周新闻通讯,获取行业领先的AI报道的最新更新和独家内容。了解更多

一年前,谷歌在企业AI领域的叙事显得有些停滞,尽管它发明了Transformer等核心技术;这家科技巨头似乎一直处于被动地位,被OpenAI的病毒式成功、Anthropic的编码实力以及微软的积极进军所掩盖。

然而,上周在拉斯维加斯举行的谷歌云Next 2025大会上,我们看到了一个自信满满的谷歌,它拥有领先的模型、强大的基础设施和一个连贯的企业战略,宣告了其惊人的逆袭。一位分析师在与谷歌高管的闭门会议上总结道:“感觉谷歌已经从‘追赶者’变成了‘被追赶者’。”

这种谷歌不仅赶上了,甚至在企业AI竞赛中超越了OpenAI和微软的观点,贯穿了整个活动。这不仅仅是谷歌的营销策略。证据表明,谷歌在过去一年中进行了高强度、专注的执行,将其深厚的技术资产转化为一个高性能的集成平台,并迅速赢得了企业决策者的青睐。从运行在超高效定制硅片上的全球最强大的AI模型,到为现实世界业务问题而设计的蓬勃发展的AI代理生态系统,谷歌正在有力地证明,它从未真正落后——只是其之前的失误掩盖了一段深层的基础发展时期。

现在,随着其集成堆栈全面发力,谷歌似乎已准备好引领企业AI革命的下一阶段。我在Next大会上采访了几位谷歌高管,他们表示,谷歌在基础设施和模型集成方面拥有竞争对手(如OpenAI、微软或AWS)难以复制的优势。

要理解目前的势头,就必须承认最近的过去。谷歌是Transformer架构的诞生地,它引发了大型语言模型(LLM)的现代革命。十年前,谷歌还开始投资于专门的AI硬件(TPU),而这些硬件如今正推动着行业领先的效率。然而,两年前,它却莫名其妙地陷入了防守状态。

OpenAI的ChatGPT以惊人的速度抓住了公众的想象力和企业的兴趣,成为历史上增长最快的应用程序。Anthropic等竞争对手在编码等领域开辟了利基市场。

谷歌自身公开的举措有时显得犹豫或存在缺陷。2023年臭名昭著的Bard演示失误以及后来其图像生成器产生历史不准确描述的争议,加剧了该公司可能受到内部官僚主义或过度纠正的影响的叙事。谷歌似乎迷失了方向:AI的失误似乎符合一种模式,这种模式首先体现在谷歌在云计算竞争中的初始缓慢,在市场份额上远远落后于亚马逊和微软。谷歌云CTO Will Grannis承认了早期人们对谷歌云能否长期立足的质疑。“它究竟是不是个真东西?”他回忆起人们问他的话。一个问题挥之不去:谷歌能否将其无可否认的研究实力和基础设施规模转化为企业AI的主导地位?

然而,幕后正在发生转变,这源于最高层有意识地决定夺回领导地位。谷歌DeepMind AI开发者平台产品副总裁Mat Velloso描述说,在2024年2月离开微软加入谷歌后,他感觉到了一个关键时刻。“当我来到谷歌时,我和桑达尔[皮查伊]以及这里的几位领导人谈过话,我觉得那一刻他们正在决定,好吧,这个[生成式AI]是业界明显关注的事情。让我们把它做成吧,”Velloso在上周Next大会期间接受VentureBeat采访时分享道。

这种新的推动并没有受到一些外部人士认为正在消耗谷歌的“人才流失”的阻碍。事实上,该公司在2024年初悄悄地加倍投入执行——这一年以积极的招聘、内部统一和客户吸引力为标志。当竞争对手进行高调的招聘时,谷歌保留了其核心AI领导团队,包括DeepMind首席执行官Demis Hassabis和谷歌云首席执行官Thomas Kurian,从而提供了稳定性和深厚的专业知识。

此外,人才开始流向谷歌专注的使命。例如,Logan Kilpatrick从OpenAI回到谷歌,因为他有机会在公司内部构建基础AI,创造它。他加入了Velloso的团队,他将其描述为“从零到一的体验”,负责从头开始建立Gemini的开发者吸引力。“第一天团队就只有我……我们在这个平台上实际上没有用户,没有收入。此刻没有人对Gemini感兴趣,”Kilpatrick回忆起当时的起点。熟悉内部动态的人也赞扬了Josh Woodward等领导者,他帮助启动了AI Studio,现在领导Gemini应用程序和实验室。最近,Noam Shazeer,在其谷歌第一次任期内“注意力就是你所需要的一切”Transformer论文的关键合著者,于2024年末回到公司,担任关键Gemini项目的技术联合负责人。

这种协同努力,结合这些招聘、研究突破、对其数据库技术的改进以及整体上更加锐利的企业重点,开始产生成果。这些累积的进步,加上CTO Will Grannis所说的“数百个细粒度”平台元素,为Next’25的公告奠定了基础,并巩固了谷歌的回归叙事。

的确,一个领先的企业口号已经成为“不仅仅是模型”。毕竟,领先模型之间的性能差距已经显著缩小,技术内行人士承认,真正的智能来自模型周围打包的技术,而不仅仅是模型本身——例如,允许模型使用工具并在其周围探索网络的代理技术。

尽管如此,拥有性能明显最佳的LLM仍然是一项重要的壮举——也是一个强大的验证器,表明模型拥有公司拥有诸如卓越研究和最高效的基础技术架构等优势。在Next’25几周前发布Gemini 2.5 Pro后,谷歌最终获得了这一地位。它迅速登顶独立的Chatbot Arena排行榜,其性能显著优于OpenAI最新的GPT-4o变体,并在人类最后的考试等极其困难的推理基准测试中取得了优异成绩。正如皮查伊在主题演讲中所说,“这是我们有史以来最智能的AI模型。它是世界上最好的模型。”他另在推特上表示,该模型在一个月内推动Gemini的使用率增长了80%。

谷歌Gemini的需求首次火爆。正如我之前详细介绍的那样,除了Gemini 2.5 Pro的强大智能外,给我留下深刻印象的是其可证明的推理能力。谷歌设计了一种“思考”能力,允许模型在最终确定响应之前进行多步推理、规划甚至自我反思。结构化、连贯的思维链(CoT)——使用编号步骤和子项目符号——避免了来自DeepSeek或OpenAI的其他模型输出的冗长或不透明的性质。对于评估关键任务输出的技术团队来说,这种透明性允许以前所未有的信心进行验证、校正和重定向。

但对企业用户来说更重要的是,Gemini 2.5 Pro还在编码方面显著缩小了差距,这是生成式AI最大的应用领域之一。在接受VentureBeat采访时,领先零售商Wayfair的CTO Fiona Tan表示,在初步测试后,该公司发现它“提升了不少”,现在“与Anthropic的Claude 3.7 Sonnet相当”,后者以前是许多开发人员的首选。

谷歌还为该模型添加了巨大的100万个令牌上下文窗口,使其能够跨整个代码库或冗长的文档进行推理,远远超过OpenAI或Anthropic模型的能力。(OpenAI本周回应了具有类似大型上下文窗口的模型,尽管基准测试表明Gemini 2.5 Pro在整体推理方面仍保持优势)。这种优势允许执行复杂的、多文件软件工程任务。

补充Pro的是在Next’25上宣布并于昨天发布的Gemini 2.5 Flash。同样是一个“思考”模型,Flash针对低延迟和成本效率进行了优化。您可以控制模型推理的程度,并在性能和预算之间取得平衡。这种分层方法进一步反映了谷歌高管所倡导的“每美元智能”战略。

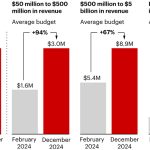

Velloso展示了一张图表,显示在整个智能范围内,谷歌模型提供了最佳价值。“如果我们一年前进行这次谈话……我将一无所获,”Velloso承认,并强调了快速的转变。“现在,如果你是寻找任何模型,任何大小,如果你不是谷歌,你就是在亏钱。”这些图表已更新,以考虑OpenAI本周发布的最新模型。见下图:

对于任何给定的价格,谷歌的模型提供的智能都超过了90%的团队。来源:Pierre Bongrand。

Wayfair的Tan表示,她还观察到2.5 Pro的延迟改进很有前景:“Gemini 2.5返回速度更快,”使其可用于“更多面向客户的功能,”她说,这在以前使用其他模型时并非如此。她说,Gemini可能成为Wayfair用于这些客户互动的第一个模型。

Gemini系列的功能扩展到多模态,与谷歌的其他领先模型(如Imagen 3(图像生成)、Veo 2(视频生成)、Chirp 3(音频)和新宣布的Lyria(文本转音乐))无缝集成,所有这些都可通过谷歌的企业用户平台Vertex访问。谷歌是唯一一家在其平台上提供所有模态的自主生成媒体模型的公司。微软、AWS和OpenAI必须与其他公司合作才能做到这一点。

快速迭代和高效地服务这些强大的模型的能力源于谷歌可以说是无与伦比的基础设施,这是几十年来运行行星级服务的结果。其核心是张量处理单元(TPU)。

在Next’25上,谷歌推出了Ironwood,这是其第七代TPU,专门为推理和“思考模型”的需求而设计。规模巨大,专为苛刻的AI工作负载量身定制:Ironwood集群包含超过9000个液冷芯片,提供据称42.5 exaflops的计算能力。谷歌机器学习系统副总裁Amin Vahdat在Next大会上表示,这“超过”了当前世界排名第一的超级计算机的计算能力的24倍。

谷歌表示,与上一代TPU Trillium相比,Ironwood的每瓦性能提高了2倍。这一点非常重要,因为企业客户越来越多地表示,能源成本和可用性限制了大规模AI部署。

谷歌云CTO Will Grannis强调了这一进展的一致性。他告诉VentureBeat,谷歌每年都在其处理器上取得10倍、8倍、9倍、10倍的改进,创造了他所谓的AI加速器的“超摩尔定律”。他说,客户购买的是谷歌的路线图,而不仅仅是其技术。

谷歌的地位推动了这种持续的TPU投资。它需要高效地为超过20亿用户的搜索、YouTube和Gmail等海量服务提供动力。这需要在当前生成式AI热潮之前很久就开发定制的优化硬件。虽然Meta的运营规模与之类似,但其他竞争对手缺乏这种持续十年的垂直整合AI硬件开发的内部驱动力。

现在,这些TPU投资正在获得回报,因为它们不仅提高了自身应用程序的效率,而且还使谷歌能够以更好的每美元智能为其他用户提供Gemini,在所有条件相同的情况下。

你可能会问,为什么谷歌的竞争对手不能从英伟达购买高效的处理器?的确,英伟达的GPU处理器在LLM的预训练中占据主导地位。但市场需求推高了这些GPU的价格,英伟达从中获得了丰厚的利润。这将大量成本转嫁给了其芯片的用户。而且,虽然到目前为止,预训练在AI芯片的使用中占据主导地位,但这正在发生变化,因为企业实际上正在部署这些应用程序。这就是“推理”的用武之地,在这里,TPU被认为在大规模工作负载方面比GPU更有效率。

当你问谷歌高管他们的主要AI技术优势来自哪里时,他们通常会将TPU作为最重要的因素。负责谷歌计算基础设施的副总裁John Lohmeyer斩钉截铁地说:TPU“无疑是我们所做工作的差异化部分……OpenAI,他们不具备这些能力。”

重要的是,谷歌并非孤立地展示TPU,而是将其作为更广泛、更复杂的企业AI架构的一部分。对于技术内行人士来说,众所周知,顶级性能取决于整合越来越专业化的技术突破。Next大会上详细介绍了许多更新。Vahdat将其描述为一个“超级计算系统”,它将硬件(TPU、最新的英伟达GPU,如Blackwell和即将推出的Vera Rubin、先进的存储,如Hyperdisk Exapools、Anywhere Cache和Rapid Storage)与统一的软件堆栈集成在一起。该软件包括用于管理加速器的集群管理器、Pathways(Gemini的分布式运行时,现已提供给客户),以及将vLLM等优化功能引入TPU,从而更容易为以前在英伟达/PyTorch堆栈上的用户迁移工作负载。Vahdat认为,正是这个集成系统使Gemini 2.0 Flash实现了比GPT-4o高24倍的每美元智能。

谷歌还在扩展其物理基础设施的覆盖范围。云广域网使谷歌的低延迟200万英里专用光纤网络可供企业使用,承诺比客户管理的网络快40%,总拥有成本(TCO)降低40%。

此外,谷歌分布式云(GDC)允许Gemini和英伟达硬件(通过与戴尔的合作)在主权、本地甚至隔离的环境中运行——英伟达首席执行官黄仁勋称其为“极其巨大”的能力,可以将最先进的AI带入受监管的行业和国家。在Next大会上,黄仁勋称谷歌的基础设施是世界上最好的:“没有哪家公司在计算的每一层都比谷歌和谷歌云更好,”他说。

当考虑这些模型和基础设施组件如何编织成一个连贯的平台时,谷歌的战略优势就会增强。与经常依赖合作伙伴来弥补差距的竞争对手不同,谷歌控制着几乎每一层,从而实现了更紧密的集成和更快的创新周期。

那么,如果像微软这样的竞争对手可以简单地与OpenAI合作,将基础设施广度与LLM模型实力相匹配,这种集成为什么重要呢?我交谈过的谷歌员工表示,这会有很大的不同,他们也提出了轶事来支持这一点。

以谷歌企业数据库BigQuery的显著改进为例。该数据库现在提供了一个知识图谱,允许LLM更有效地搜索数据,并且其客户数量是Snowflake和Databricks等竞争对手的五倍以上,VentureBeat昨天报道。谷歌云数据分析产品主管Yasmeen Ahmad表示,只有谷歌的数据团队与DeepMind团队紧密合作,才能实现这些巨大的改进。他们解决了难以解决的用例,这导致数据库在获取正确数据方面比最接近的竞争对手提高了50%的准确性,至少根据谷歌的内部测试,在获取正确数据方面比最接近的竞争对手提高了50%的准确性,Ahmad在接受VentureBeat采访时表示。Ahmad表示,这种跨堆栈的深度集成是谷歌如何“超越”行业的方式。

这种内部凝聚力与微软的“亦敌亦友”动态形成鲜明对比。虽然微软与OpenAI合作,在其Azure云上分发其模型,但微软也在构建自己的模型。现在领导AI开发者项目的谷歌高管Mat Velloso在试图将Windows Copilot计划与OpenAI的模型产品相协调时感到沮丧后离开了微软。“你如何与另一家实际上正在与你竞争的公司分享你的产品计划……整个事情都是矛盾的,”他回忆道。“我在这里与构建模型的人并肩而坐。”

这种集成体现了谷歌领导者认为的核心优势:其独特的能力,可以连接从基础研究和模型构建到“行星级”应用程序部署和基础设施设计等各个方面的深厚专业知识。

Vertex AI是谷歌企业AI工作的中心神经系统。集成不仅仅局限于谷歌自身的产品。Vertex的模型花园提供超过200个精选模型,包括谷歌的模型、Meta的Llama 4以及众多开源选项。Vertex提供用于调整、评估(包括Grannis强调的关键加速器AI驱动的评估)、部署和监控的工具。其基础能力利用内部AI就绪数据库以及与外部向量数据库的兼容性。再加上谷歌新的利用全球最佳搜索引擎谷歌搜索来为模型提供基础的功能。

集成扩展到Google Workspace。在Next’25上宣布的新功能,例如Sheets中的“帮助我分析”(是的,Sheets现在有“=AI”公式)、Docs中的音频概述和Workspace Flows,进一步将Gemini的功能嵌入到日常工作流程中,为谷歌改进体验创造了一个强大的反馈循环。

在推动其集成堆栈的同时,谷歌还在其服务生态系统的地方倡导开放性。在推动Kubernetes采用之后,它现在正在推广用于AI框架的JAX,以及用于代理通信的开放协议(A2A),以及对现有标准(MCP)的支持。谷歌还在Agentspace(谷歌新的统一界面,供员工查找和使用代理)中提供了数百个与外部平台的连接器。这个中心概念很有吸引力。主题演讲中对Agentspace的演示(从51:40开始)说明了这一点。谷歌为用户提供预构建的代理,或者员工或开发人员可以使用无代码AI功能构建自己的代理。或者他们可以通过A2A连接器从外部引入代理。它集成到Chrome浏览器中,方便访问。

也许最重要的转变是谷歌更加专注于解决具体的企业问题,特别是通过AI代理的视角。谷歌云首席执行官Thomas Kurian概述了客户选择谷歌的三个原因:AI优化的平台、允许连接现有IT的开放多云方法以及专注于安全、主权和合规性的企业就绪重点。

代理是这一战略的关键。除了AgentSpace之外,还包括:

构建模块:在Next大会上宣布的开源代理开发套件(ADK)已经引起了开发人员的极大兴趣。ADK简化了创建多代理系统的过程,而拟议的Agent2Agent(A2A)协议旨在确保互操作性,允许使用不同工具(Gemini ADK、LangGraph、CrewAI等)构建的代理进行协作。谷歌的Grannis表示,A2A预见了未来可能拥有数十万个交互代理的规模和安全挑战。

这个A2A协议非常重要。在本周接受VentureBeat背景采访时,一位不愿透露姓名(由于安全问题敏感)的美国主要零售商的首席信息安全官表示,A2A协议很有帮助,因为该零售商正在寻找一种解决方案来区分使用代理购买产品的人和机器人。这家零售商希望避免向黄牛机器人销售产品,而使用A2A,更容易与代理协商以验证其所有者的身份。

专用代理:谷歌展示了集成到Agentspace中的专家代理(如NotebookLM、创意生成、深度研究),并重点介绍了五个正在获得吸引力的关键类别:客户代理(为Reddit Answers、Verizon的支持助手、Wendy’s得来速等工具提供支持)、创意代理(由WPP、Brandtech、Sphere使用)、数据代理(推动美泰、Spotify、拜耳的见解)、编码代理(Gemini代码助手)和安全代理(集成到新的谷歌统一安全平台中)。

这种全面的代理战略似乎正在产生共鸣。本周与另外三家大型企业的管理人员的谈话(由于竞争敏感性,也匿名发言)也表达了对谷歌代理战略的热情。谷歌云首席运营官Francis DeSouza在一次采访中证实:“每一次谈话都包括AI。具体来说,每一次谈话都包括代理。”

德勤的高管Kevin Laughridge是谷歌AI产品的忠实用户,也是其向其他公司分销商,他将代理市场描述为一场“土地争夺战”,谷歌在协议和集成平台方面的早期行动提供了显著优势。“谁先出来,谁获得的真正提供价值的代理最多——谁就会在这场竞争中获胜,”Laughridge在一次采访中表示。他说谷歌的进步“令人震惊”,并指出德勤仅仅一年前构建的自定义代理现在可以使用Agentspace“开箱即用”地复制。他说,德勤本身正在该平台上构建100个代理,目标是中层办公职能,如财务、风险和工程。

客户证明点正在增加。在Next大会上,谷歌引用了“500多家生产中的客户”使用生成式AI,而一年前只有“几十个原型”。如果微软一年前被认为遥遥领先,那么现在看来情况似乎并非如此。鉴于各方的公关战,很难明确地说谁现在真正获胜。指标各不相同。谷歌的500这个数字与微软推广的400个案例研究(微软在截稿时回应VentureBeat,计划很快将这一公开数量更新为600,这突显了激烈的市场竞争)并不直接可比。如果谷歌通过其应用程序分发AI具有重要意义,那么微软通过其365产品分发Copilot同样令人印象深刻。两者现在都通过API接触到数百万开发人员。

[编辑注:了解企业如何应对这场“代理争夺战”,并成功部署这些复杂的AI解决方案,将成为今年6月24日至25日在旧金山举行的VentureBeat Transform活动的讨论核心。]

但谷歌吸引力的例子比比皆是:

- 温迪:在一年的时间里,将AI得来速系统部署到数千个门店,提高了员工体验和订单准确性。谷歌云CTO Will Grannis指出,AI系统能够理解俚语并过滤掉背景噪音,从而大大减少了实时客户互动的压力。这使得员工可以专注于食品准备和质量——Grannis称之为“AI简化现实世界运营的一个很好的例子”。

- Salesforce:宣布大幅扩展,使其平台首次(超越AWS)在谷歌云上运行,并称赞谷歌帮助他们“创新和优化”。

- 霍尼韦尔和Intuit:以前分别与微软和AWS密切相关的公司,现在正在与谷歌云合作开展AI项目。

- 大型银行(德意志银行、富国银行):利用代理和Gemini进行研究、分析和现代化客户服务。

- 零售商(沃尔玛、Mercado Libre、劳氏):使用搜索、代理和数据平台。

这种企业吸引力推动了谷歌云的整体增长,在过去三个季度中,谷歌云的增长速度超过了AWS和Azure。谷歌云在2024年的年化运行率达到440亿美元,而2018年仅为50亿美元。

谷歌的崛起并不意味着竞争对手停滞不前。OpenAI本周快速发布的GPT-4.1(专注于编码和长上下文)和o系列(多模态推理、工具使用)证明了OpenAI持续的创新。此外,OpenAI在GPT-4o中对新图像生成功能的更新仅仅在上个月就推动了巨大的增长,帮助ChatGPT达到8亿用户。微软继续利用其庞大的企业足迹和OpenAI合作伙伴关系,而Anthropic仍然是一个强大的竞争者,尤其是在编码和安全意识的应用程序方面。

然而,不可否认的是,谷歌的叙事有了显著改善。仅仅一年前,谷歌被认为是一家死板、犹豫、笨拙的竞争对手,它可能即将失去领导AI的机会。相反,其独特的集成堆栈和公司坚定性揭示了其他东西:谷歌在整个领域拥有世界一流的能力——从芯片设计(TPU)和全球基础设施到基础模型研究(DeepMind)、应用程序开发(Workspace、搜索、YouTube)和企业云服务(Vertex AI、BigQuery、Agentspace)。“我们是唯一一家参与基础模型对话的超大规模公司,”deSouza断然说道。这种端到端的拥有权允许进行优化(如“每美元智能”)和集成深度,这是依赖合作伙伴的模型难以匹敌的。竞争对手通常需要将不同的部分缝合在一起,这可能会产生摩擦或限制创新速度。

虽然AI竞赛仍然充满活力,但谷歌在市场需求的精确时刻组装了所有这些部分。正如德勤的Laughridge所说,谷歌达到了其能力与“市场需求”完美契合的点。如果你一直在等待谷歌在企业AI中证明自己,你可能错过了这个时刻——它已经做到了。发明了推动这场革命的许多核心技术的公司似乎终于赶上了——而且不仅如此,它现在正在设定竞争对手需要匹配的步伐。

在下面的视频中,在Next大会结束后,AI专家Sam Witteveen和我一起分析了当前的形势和新兴趋势,以及为什么谷歌的AI生态系统如此强大:

“`