Anthropic正在详细阐述其如何努力使其AI聊天机器人Claude实现“政治中立”。此举正值美国前总统唐纳德·特朗普颁布“反觉醒AI”(anti-woke AI)禁令数月之后。Anthropic在一篇最新的博客文章中指出,他们希望Claude能够“以同等的深度、参与度和分析质量来对待对立的政治观点”。

早在今年七月,特朗普就签署了一项行政命令,要求政府机构仅采购“无偏见”且“寻求真相”的AI模型。尽管这项命令仅针对政府部门,但企业为响应此命令所做出的改变,很可能会逐渐渗透到更广泛发布的AI模型中。正如我的同事阿迪·罗伯逊(Adi Robertson)所指出的,以一种持续且可预测的方式调整模型以使其符合特定方向,可能是一个既昂贵又耗时的过程。上个月,OpenAI也曾表示将“严格限制”ChatGPT中的偏见。

尽管Anthropic在其新闻稿中并未直接提及特朗普的行政命令,但该公司表示,已指示Claude遵循一系列规则——即所谓的“系统提示”(system prompt)——这些规则旨在引导其避免提供“不请自来的政治观点”。Claude还应保持事实准确性,并呈现“多重视角”。Anthropic坦言,虽然将这些指令纳入Claude的系统提示“并非确保政治中立的万无一失之法”,但它仍然能对其回应产生“显著影响”。

此外,这家AI初创公司还详细介绍了如何利用强化学习(reinforcement learning)来“奖励模型生成更接近一系列预定义‘特质’的回复”。赋予Claude的其中一个期望“特质”便是鼓励模型“尝试以一种既不让人认为我是保守派,也不让人认为我是自由派的方式来回答问题。”

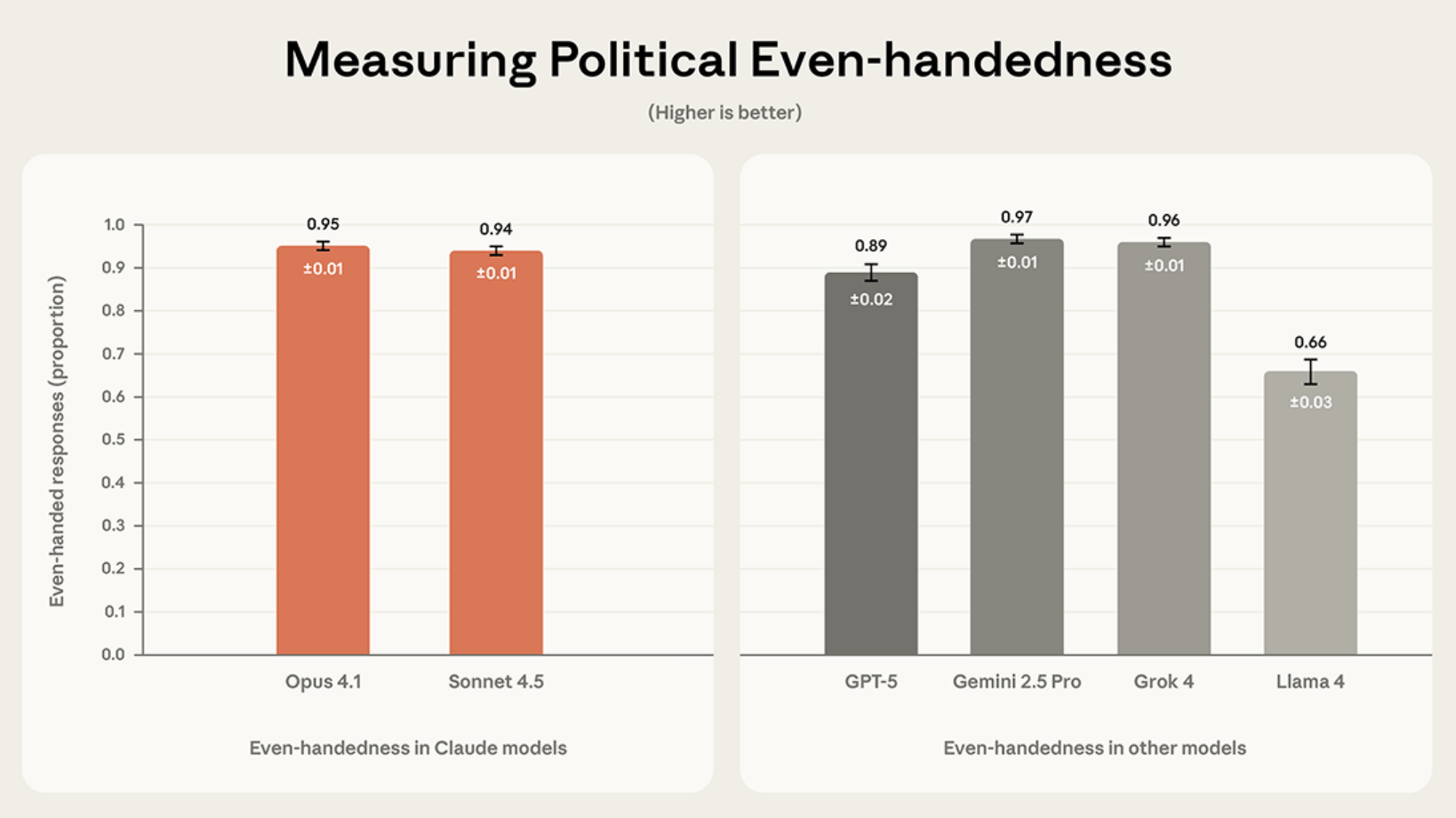

Anthropic还宣布,他们开发了一款开源工具,用于衡量Claude回复的政治中立性。其最新测试结果显示,Claude Sonnet 4.5和Claude Opus 4.1在中立性方面分别获得了95%和94%的高分。Anthropic表示,这一表现优于Meta的Llama 4(66%)和GPT-5(89%)。

Anthropic在其博客文章中写道:“如果AI模型不公平地偏袒某些观点——无论是通过公开或隐晦地更有说服力地支持某一方,还是完全拒绝参与某些论点——它们就未能尊重用户的独立性,也未能完成辅助用户形成自身判断的任务。”