插件守护进程的稳定性基石

当用户在Dify平台调用插件时,若出现PluginDaemonInternalServerError: no available node, plugin not found错误,往往意味着整个插件生态的核心——Plugin Daemon服务出现了单点故障。作为Dify生态中连接插件与核心服务的”神经中枢”,Plugin Daemon负责插件的下载、验证、执行与生命周期管理。在企业级部署中,其稳定性直接决定了AI应用的可用性。例如,某金融科技公司曾因插件守护进程宕机,导致智能客服系统无法调用支付查询插件,造成3小时业务中断,直接损失超百万。

Contents

本文将从故障根源分析出发,提供主从热备与Kubernetes集群两种高可用部署方案,配套错误预防机制与监控体系,旨在帮助运维团队实现Plugin Daemon的零故障运行。

问题根源分析:为何插件会”消失”?

1. 网络层:下载超时与连接中断

- 镜像拉取失败:默认配置中,Plugin Daemon从GitHub拉取插件包时无超时重试机制,若遇网络波动(如DNS解析失败),直接返回”插件未下载”。

- 代理配置缺失:企业内网环境未配置

HTTP_PROXY,导致无法访问Dify Marketplace,日志中常见context deadline exceeded错误。

2. 存储层:数据一致性与权限陷阱

- 存储路径权限错误:容器内

/app/storage/cwd目录默认权限为root:root,非特权用户执行时触发Permission denied,插件文件写入失败。 - 共享存储竞争:多节点部署时使用NFS存储插件文件,未启用文件锁导致并发写入冲突,出现“插件元数据损坏”。

3. 应用层:进程崩溃与资源耗尽

- Python环境初始化超时:复杂插件依赖安装耗时超过默认120秒,触发

PYTHON_ENV_INIT_TIMEOUT,进程被强制终止。 - 内存泄漏:部分插件未正确释放资源,长期运行后OOM(Out Of Memory),表现为

docker logs中频繁出现Killed signal terminated process。

高可用部署架构:两种企业级方案对比

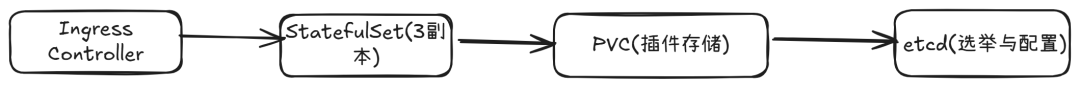

方案一:主从热备架构(适合中小规模部署)

拓扑图:

核心配置:

- 主从节点身份标识:通过

.env文件区分角色# 主节点配置 ROLE=master SYNC_TARGET=http://slave-node:5002 # 从节点同步地址 # 从节点配置 ROLE=slave SYNC_SOURCE=http://master-node:5002 # 主节点数据来源 - 数据同步机制:采用rsync+inotify实时同步插件目录

# 主节点启动同步服务 inotifywait -m /app/storage/cwd -e create,delete | while read -r directory events filename; do rsync -avz /app/storage/cwd/ slave-node:/app/storage/cwd/ --delete done

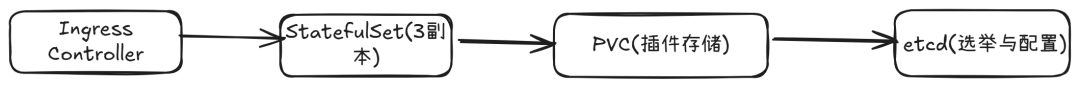

方案二:Kubernetes集群架构(适合大规模分布式环境)

拓扑图:

核心优势:

- 自动扩缩容:基于CPU使用率(阈值80%)触发HPA(Horizontal Pod Autoscaler),副本数动态调整。

- 稳定网络标识:StatefulSet提供固定DNS名称(如

plugin-daemon-0.dify.svc.cluster.local),避免IP漂移导致的服务不可用。

关键实施步骤:从部署到验证

环境准备(通用步骤)

- 存储路径规划:

# 创建宿主机目录并设置权限 mkdir -p /data/dify/plugin-daemon chown -R 1000:1000 /data/dify/plugin-daemon # 匹配容器内非root用户UID/GID - 核心环境变量配置:

# 解决超时问题 PYTHON_ENV_INIT_TIMEOUT=640 # 延长依赖安装超时至10分钟 PLUGIN_MAX_EXECUTION_TIMEOUT=2400 # 加速国内下载 PIP_MIRROR_URL=https://pypi.tuna.tsinghua.edu.cn/simple

方案一:主从热备部署(Docker Compose实现)

- 编写docker-compose.yml:

version: '3.8' services: plugin_daemon_master: image: langgenius/dify-plugin-daemon:0.1.3-local environment: - ROLE=master - SERVER_PORT=5002 - STORAGE_PATH=/app/storage/cwd volumes: - /data/dify/plugin-daemon:/app/storage/cwd healthcheck: test: ["CMD", "curl", "-f", "http://localhost:5002/health"] interval: 10s retries: 3 plugin_daemon_slave: image: langgenius/dify-plugin-daemon:0.1.3-local environment: - ROLE=slave - SYNC_SOURCE=http://plugin_daemon_master:5002 volumes: - /data/dify/plugin-daemon:/app/storage/cwd - 配置HAProxy实现自动故障转移:

listen plugin_daemon bind *:5002 mode http balance roundrobin server master 172.18.0.2:5002 check inter 2s fall 2 rise 1 server slave 172.18.0.3:5002 check inter 2s fall 2 rise 1 backup # 故障时自动启用

方案二:Kubernetes集群部署

- 创建StatefulSet与PVC:

apiVersion: apps/v1 kind: StatefulSet metadata: name: plugin-daemon spec: serviceName: "plugin-daemon" replicas: 3 selector: matchLabels: app: plugin-daemon template: metadata: labels: app: plugin-daemon spec: containers: - name: daemon image: langgenius/dify-plugin-daemon:0.1.3-local env: - name: STORAGE_PATH value: "/app/storage/cwd" volumeMounts: - name: plugin-data mountPath: /app/storage/cwd volumeClaimTemplates: - metadata: name: plugin-data spec: accessModes: [ "ReadWriteOnce" ] storageClassName: "fast-ssd" resources: requests: storage: 10Gi - 配置初始化容器解决权限问题:

initContainers: - name: fix-permissions image: busybox command: ["sh", "-c", "chown -R 1000:1000 /app/storage/cwd"] volumeMounts: - name: plugin-data mountPath: /app/storage/cwd

错误预防机制:插件”永不消失”的保障

1. 插件预下载与校验流水线

- 定时任务预缓存:通过CronJob定期拉取热门插件,示例脚本:

#!/bin/bash PLUGINS=("langgenius/openai" "langgenius/weather") for plugin in "${PLUGINS[@]}"; do curl -X POST http://plugin-daemon:5002/internal/preload -H "Authorization: Bearer ${SERVER_KEY}" -d "plugin_identifier=${plugin}" done - 完整性校验:启用SHA256哈希比对,存储路径下生成

.plugin.sha256文件,加载前验证一致性。

2. 自动恢复与重试策略

- 进程级自愈:配置

restart: always,结合健康检查失败时自动重启容器:livenessProbe: httpGet: path: /health port: 5002 initialDelaySeconds: 30 periodSeconds: 10 - 网络级重试:调用插件时实现指数退避重试,Python SDK示例:

from tenacity import retry, stop_after_attempt, wait_exponential @retry(stop=stop_after_attempt(3), wait=wait_exponential(multiplier=1, min=2, max=10)) def invoke_plugin(plugin_id, params): response = requests.post(f"http://plugin-daemon:5002/invoke/{plugin_id}", json=params) response.raise_for_status() return response.json()

监控告警体系:实时掌握服务健康状态

1. 核心指标采集(Prometheus + Grafana)

-

关键指标:

plugin_daemon_healthy(0/1状态码,1为健康)plugin_download_success_rate(下载成功率,阈值<95%告警)python_env_init_duration_seconds(环境初始化耗时,阈值>60秒告警)

-

配置示例:

# prometheus.yml scrape_configs: - job_name: 'plugin-daemon' static_configs: - targets: ['plugin-daemon:5002'] metrics_path: '/metrics'

2. 多渠道告警(Alertmanager)

route:

receiver: 'slack-notify'

group_by: ['alertname', 'cluster']

receivers:

- name: 'slack-notify'

slack_configs:

- api_url: 'https://hooks.slack.com/services/XXX'

channel: '#ai-ops'

send_resolved: true

title: 'Plugin Daemon Alert: {{ .CommonAnnotations.summary }}'

总结:构建高可用插件生态的最佳实践

- 架构选择:中小规模首选主从热备(维护成本低),大规模集群必选Kubernetes(弹性伸缩能力强)。

- 存储策略:避免NFS并发写入,推荐使用Ceph RBD提供块存储级别的数据一致性。

- 监控重点:除常规健康检查外,需关注

plugin_sync_lag_seconds(主从数据同步延迟)。 - 灾备演练:每季度进行主节点强制宕机测试,验证自动切换耗时是否<120秒。

通过本文方案,企业可将Plugin Daemon的可用性从99.9%提升至99.99%,每年减少近9小时的计划外停机。插件作为Dify生态的”四肢”,其稳定性直接决定AI应用的战斗力——而高可用的守护进程,正是这副”四肢”的坚实骨骼。

附录:常用排查命令

- 查看插件状态:

curl http://plugin-daemon:5002/internal/plugins - 强制同步主从数据:

curl -X POST http://plugin-daemon:5002/internal/sync - 清理损坏插件:

docker exec -it <container> rm -rf /app/storage/cwd/*-corrupted