LLM稳定JSON输出:掌握核心方法,提升大模型数据处理效率

JSON 格式作为轻量级数据交换格式,已成为 API 接口、数据存储、系统集成中的“通用语言”。然而,传统大语言模型(LLM)在生成 JSON 时,常面临格式错乱、字段缺失、语法错误等问题。这可能因自然语言表述偏差导致括号不匹配,也可能因复杂逻辑处理遗漏关键参数,最终让自动化数据流转“卡壳”,不仅增加人工校验成本,更可能引发下游系统故障,成为业务效率提升的隐性瓶颈。LLM 稳定 JSON 输出功能的出现,正是为解决这一核心痛点而生。

方法一:使用 json-repair 包智能修复

原理:

json-repair 包能够智能处理各种常见的 JSON 格式错误,例如:修正缺失或错误的引号、移除多余的逗号,并能自动忽略 JSON 内容前后无关的文本。

缺点:

如果返回结果中完全没有 JSON 格式的数据,此方法将失效。

示例:

例如,对于字符串 "好的,这是您要的JSON:,其中前后有多余的文字且使用了单引号,无法直接使用

{'user': 'Alex', 'id': 123}

希望对您有帮助!"json.load 进行转换,此时便可使用 json-repair。

from json_repair import repair_json

llm_output_string = "好的,这是您要的JSON:

{'user': 'Alex', 'id': 123}

希望对您有帮助!"

repaired_string = repair_json(llm_output_string)

# 输出: {"user": "Alex", "id": 123}

方法二:通过 Pydantic 设置 Schema 验证

原理:

Pydantic 允许开发者定义一个类作为数据“蓝图”,明确规定数据应包含哪些字段及其类型。当 LLM 返回结果(通常是字符串形式)传入时,Pydantic 会自动验证数据结构,并将相应数据转换为对应的 Python 类型。

缺点:

Pydantic 本身无法像 json-repair 那样处理额外的非 JSON 文本。

示例:

from pydantic import BaseModel

class User(BaseModel):

id: int

name: str

is_active: bool = True

input_data = {"id": "123", "name": "Alice"}

user = User(**input_data)

print(user.model_dump_json(indent=2))

# 输出: { "id": 123, "name": "Alice","is_active": true}

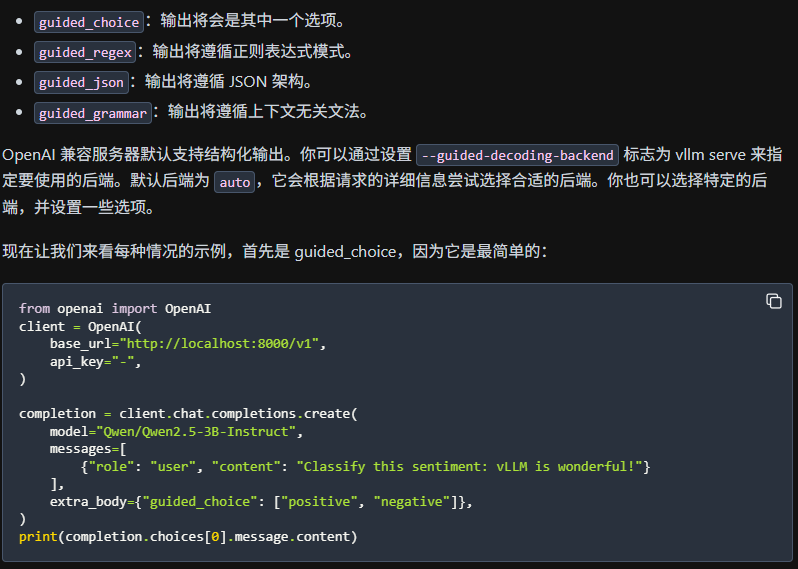

方法三:利用 vLLM 内置参数直接格式化输出

原理:

此方法与 Pydantic 的原理类似,但 vLLM 内部已集成此功能,允许用户通过设置 extra_body 参数直接格式化输出,省去了手动验证的步骤。

缺点:

可能存在试错成本,且 API 调用可能会产生额外的资源消耗。

示例:

from pydantic import BaseModel

class Topic(BaseModel):

问题: str

答案: str

completion = client.chat.completions.create(

model=model,

messages=[

{"role": "system", "content": system_prompt },

{"role": "user", "content": user_prompt },

],

extra_body={ "guided_json": Topic.model_json_schema()},

)

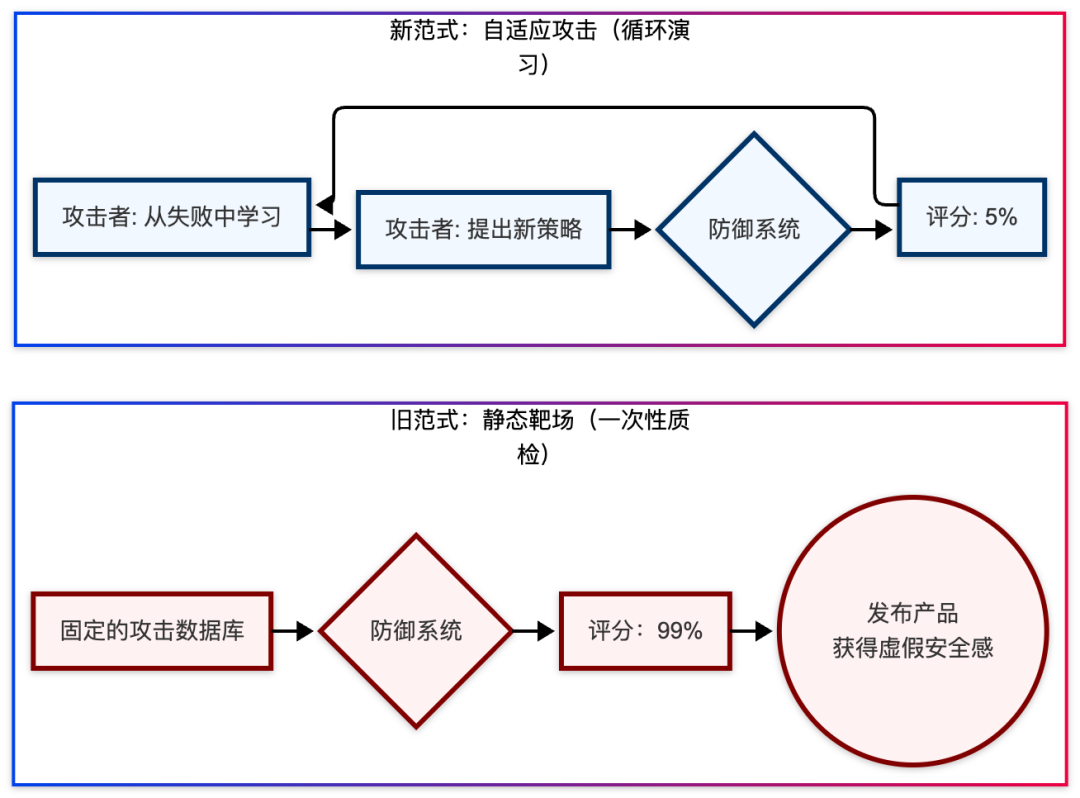

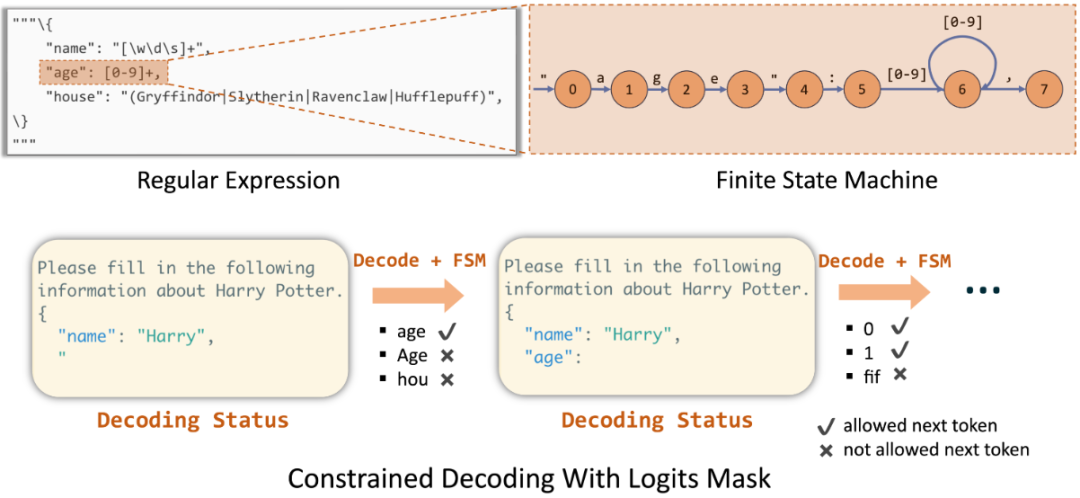

方法四:约束性解码

原理:

这类方法(如 LM-Format-Enforcer 库、Xgrammar 等)通过在 LLM 生成每个 Token 时,基于预设策略(如 JSON Schema)选择满足约束的 Token,从而指导 LLM 生成符合给定 JSON 格式的输出。简而言之,它在模型选择下一个词(Token)的瞬间,动态地屏蔽掉所有不符合语法或格式的选项。

缺点:

实现较为复杂,会增加系统开销,并可能稍微降低生成速度,同时在一定程度上牺牲模型的灵活性和创造性。