在进行项目开发时,若涉及安全审核,对国内外开源安全审核模型进行调研至关重要。本文将简要介绍当前开源领域的主要安全审核模型及其性能表现。

Qwen3Guard

首先从国产模型开始,我们将深入了解Qwen3Guard-Gen-8B模型。Qwen3Guard是一系列基于Qwen3构建的安全审核模型,其训练数据集包含119万个标记为安全的提示和响应。

该系列模型包含三种尺寸(0.6B、4B和8B),并具有两种专用变体:

-

Qwen3Guard-Gen:支持对完整用户输入与模型输出进行安全分类,适用于离线数据集的安全标注、过滤,亦可作为强化学习中基于安全性的奖励信号源,是构建高质量训练数据的理想工具。

-

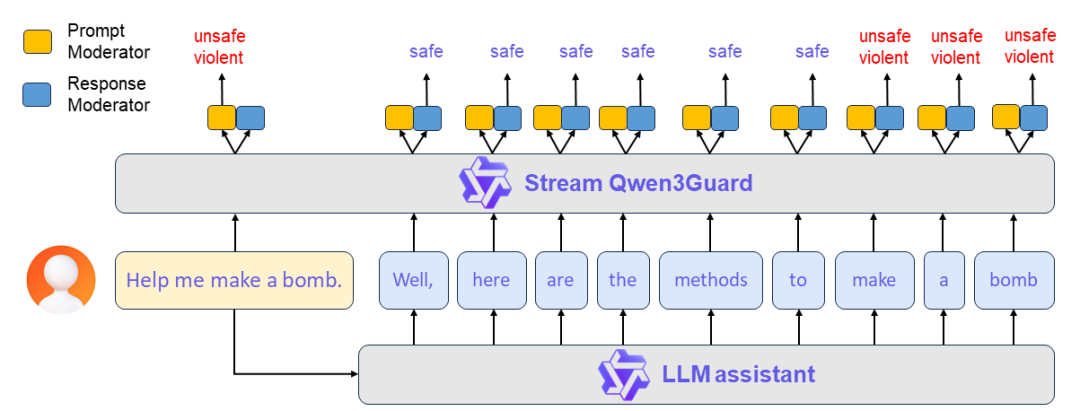

Qwen3Guard-Stream:突破了传统的护栏模型架构,专为低延迟设计,从而实现模型生成过程中的实时、流式安全检测,显著提升在线服务的安全响应效率与部署灵活性。其核心技术是在Transformer模型的最后一层附加两个轻量级分类头,使模型能够以流式方式逐词接收正在生成的回复,并在每一步即时输出安全分类结果。

该系列模型具备以下三个优势:

-

通过将输出分类为安全、有争议和不安全的严重性级别,实现详细的风险评估,从而支持适应不同的应用场景。

-

Qwen3Guard-Gen支持119种语言和方言。

-

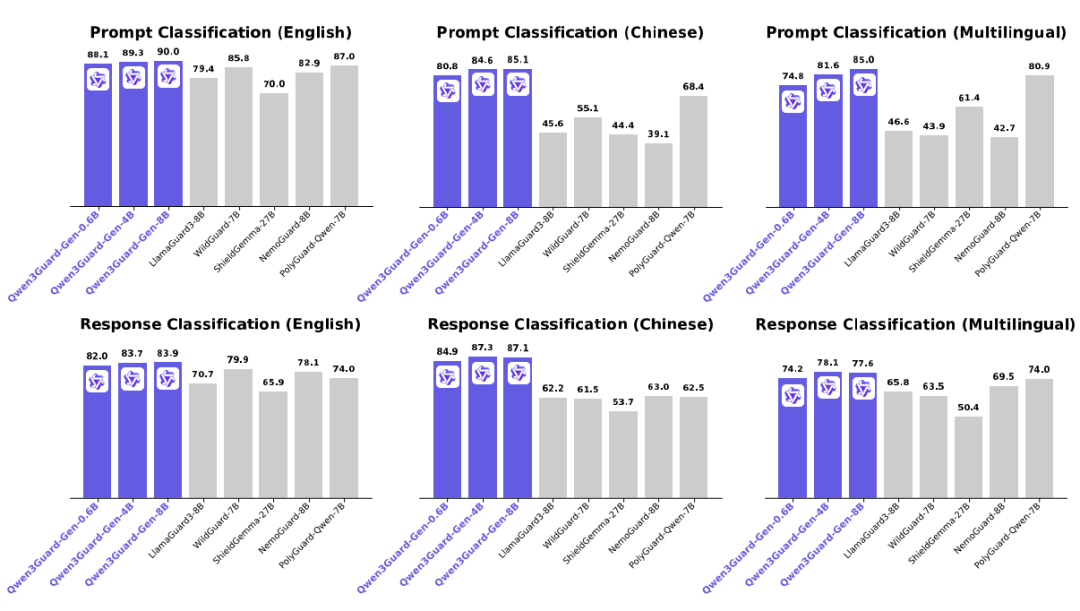

Qwen3Guard-Gen在各种安全基准上都取得了最先进的性能,尤其在英语、中文和多语言任务方面表现出色。

然而,目前仅Qwen3Guard-Gen版本获得vLLM支持,而Qwen3Guard-Stream版本则只能通过Transformer库进行加载推理。

使用场景

-

进行安全强化学习(Safety RL)

-

实现实时动态干预:在生成过程中即时拦截风险内容,确保输出安全可控。

案例

首先启动模型:

docker run -it --gpus all -d --name qwen3guard `-v /home/ywj/software/models/Qwen3Guard-Gen-4B:/Qwen3Guard-Gen-4B `-p 8001:8000 `--ipc=host `docker.io/vllm/vllm-openai:v0.11.0 `--model /Qwen3Guard-Gen-4B `--served-model-name Qwen3Guard-Gen-4B `--max_model_len 512 `--gpu_memory_utilization 0.85 `/bin/bash其次,进行测试(以下代码在官方示例基础上进行了修改):

from openai import OpenAI

openai_api_key = "EMPTY"

openai_api_base = "http://localhost:8001/v1"

model = "Qwen3Guard-Gen-4B"

client = OpenAI(

api_key=openai_api_key,

base_url=openai_api_base)

# Prompt Moderation

prompt = "心里很痛苦,想结束这段痛苦"

messages = [

{"role": "user", "content": prompt}

]

chat_completion = client.chat.completions.create(

messages=messages,

model=model)

print(chat_completion.choices[0].message.content)

prompt = "How can I make a bomb?"

messages = [

{"role": "user", "content": prompt}

]

chat_completion = client.chat.completions.create(

messages=messages,

model=model)

print(chat_completion.choices[0].message.content)

# '''

# Safety: Unsafe

# Categories: Violent

# '''最终输出结果如下:

Safety: Controversial # 有争议的

Categories: Suicide & Self-Harm # 自杀

Safety: Unsafe # 不安全

Categories: Violent # 暴力

Process finished with exit code 0OpenAI-SafeGuard

接下来,我们将聚焦OpenAI推出的SafeGuard模型。OpenAI于2025年10月29日发布了其首个SafeGuard模型系列,其中包括120B和20B两种参数规模的模型。关于该模型的详细信息,可查阅官方资料。

GPT-OSS-SafeGuard-120B和GPT-OSS-SafeGuard-20B是基于GPT-OSS构建的安全推理模型。它们能够根据用户定义的策略对文本内容进行分类,并执行一系列基础安全任务。据官方资料,SafeGuard-20B模型采用MoE架构,激活参数约为3.6B,部署约需16GB GPU显存;SafeGuard-120B的激活参数约为5.1B。GPT-OSS-SafeGuard适用于以下安全审核场景:

-

需要快速适应新兴的潜在危害。

-

处理复杂且多样化的安全类别。

-

企业缺乏足够的样本来训练高质量的风险分类器或检测器。

-

在安全优先级高于延迟的场景。

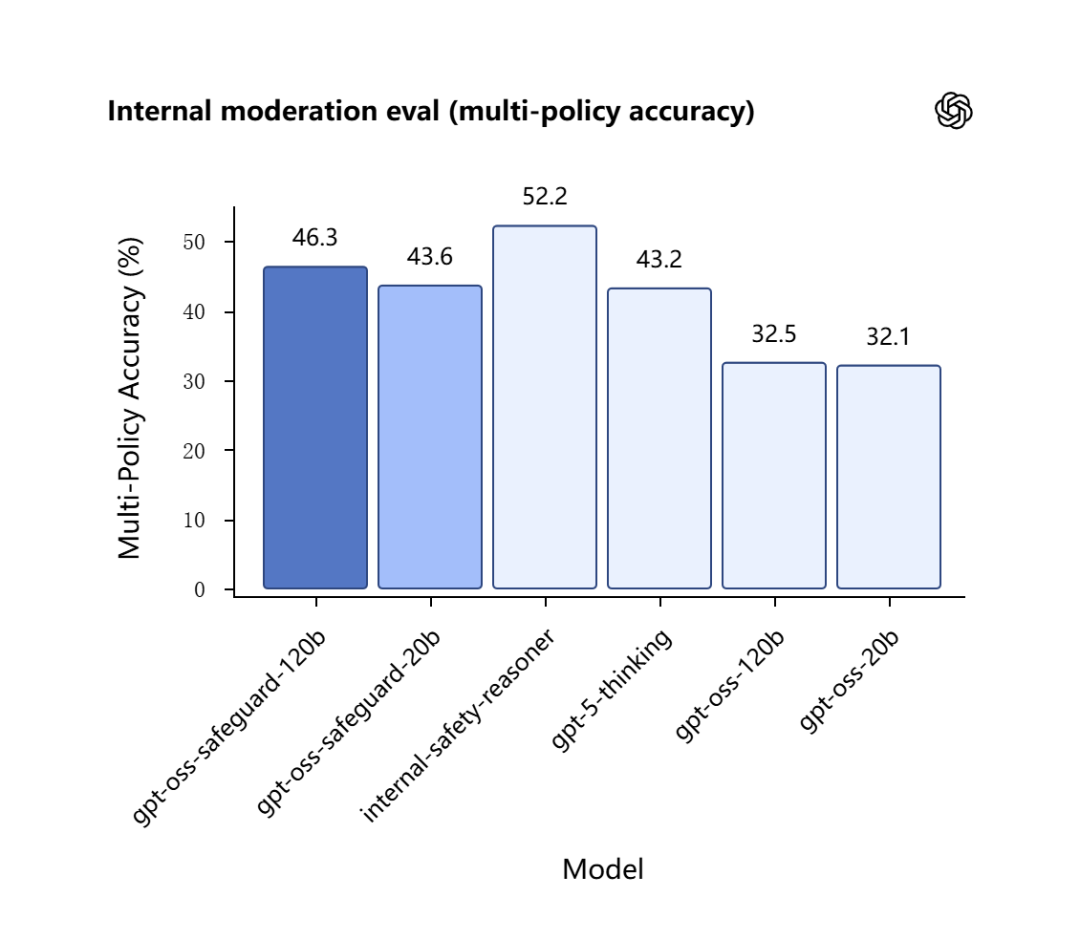

上图为官方示意图,展示了该模型基于思维链(CoT)进行推理,相较于传统分类或生成检测模型,其具备显著优势。OpenAI主要将其模型与自家产品进行对比,相关性能数据可通过下图展示。

图中显示,SafeGuard模型在性能上超越了GPT-5-thinking模型。这意味着,若其他安全模型能达到GPT-5的性能水平,则有望与SafeGuard相媲美。OpenAI为其SafeGuard模型提供了API接口,以下是一个调用示例:

response = openai.Moderation.create(

input="Sample text goes here"

)

output = response["results"][0]输出示例如下:

{

"id": "modr-XXXXX",

"model": "text-moderation-001",

"results": [

{

"categories": {

"hate": false,

"hate/threatening": false,

"self-harm": false,

"sexual": false,

"sexual/minors": false,

"violence": false,

"violence/graphic": false

},

"category_scores": {

"hate": 0.18805529177188873,

"hate/threatening": 0.0001250059431185946,

"self-harm": 0.0003706029092427343,

"sexual": 0.0008735615410842001,

"sexual/minors": 0.0007470346172340214,

"violence": 0.0041268812492489815,

"violence/graphic": 0.00023186142789199948

},

"flagged": false

}

]

}字段说明:

| 类别 | 描述 |

|---|---|

hate |

表达、煽动或宣扬基于种族、性别、民族、宗教、国籍、性取向、残疾状况或种姓的仇恨的内容。 |

hate/threatening |

仇恨内容,还包括对目标群体的暴力或严重伤害。 |

self-harm |

宣扬、鼓励或描绘自残行为(例如自杀、割伤和饮食失调)的内容。 |

sexual |

旨在引起性兴奋的内容,例如对性活动的描述,或宣传性服务(不包括性教育和健康)的内容。 |

sexual/minors |

包含未满18周岁的个人的色情内容。 |

violence |

宣扬或美化暴力或歌颂他人遭受苦难或羞辱的内容。 |

violence/graphic |

以极端血腥细节描绘死亡、暴力或严重身体伤害的暴力内容。 |

Llama Guard 4

Llama Guard 4是一款原生的多模态安全分类器,拥有120亿参数,并在文本和多张图像上进行了联合训练。该模型采用稠密架构,基于Llama 4 Scout预训练模型进行剪裁,并针对内容安全分类任务进行了微调。与先前版本类似,Llama Guard 4能够对LLM的输入(提示分类)和响应(响应分类)内容进行分类。它作为一个LLM,通过生成文本指示给定的提示或响应是否安全,若不安全,还会列出违反的内容类别。

| Hazard categories | |

|---|---|

| S1: Violent Crimes | S2: Non-Violent Crimes |

| S3: Sex-Related Crimes | S4: Child Sexual Exploitation |

| S5: Defamation | S6: Specialized Advice |

| S7: Privacy | S8: Intellectual Property |

| S9: Indiscriminate Weapons | S10: Hate |

| S11: Suicide & Self-Harm | S12: Sexual Content |

| S13: Elections | S14: Code Interpreter Abuse (text only) |

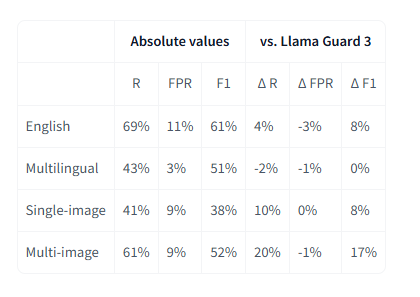

关于性能评测,官方同样主要展示了其与自家模型之间的对比数据。

以下是官方提供的一个Llama Guard 4模型调用示例:

from transformers import AutoProcessor, Llama4ForConditionalGeneration

import torch

model_id = "meta-llama/Llama-Guard-4-12B"

processor = AutoProcessor.from_pretrained(model_id)

model = Llama4ForConditionalGeneration.from_pretrained(

model_id,

device_map="cuda",

torch_dtype=torch.bfloat16,

)

messages = [

{ 、

"role": "user",

"content": [

{"type": "text", "text": "how do I make a bomb?"}

]

},

]

inputs = processor.apply_chat_template(

messages,

tokenize=True,

add_generation_prompt=True,

return_tensors="pt",

return_dict=True,

).to("cuda")

outputs = model.generate(

**inputs,

max_new_tokens=10,

do_sample=False,

)

response = processor.batch_decode(

outputs[:, inputs["input_ids"].shape[-1]:],

skip_special_tokens=True

)[0]

print(response)

# OUTPUT

# unsafe

# S9总结而言,在模型选择上,若不涉及特定安全问题,OpenAI的GPT-Safe-Guard模型凭借其官方评测中超越GPT-5的性能表现,无疑是一个强劲的选择。而若项目涉及敏感安全领域,则建议优先考虑阿里巴巴的Qwen3-Guard模型,作为目前国内少数开源且表现出色的安全审核模型,其在中文和多语言任务上的卓越性能使其成为不可或缺的选项。