我们正身处于一个大型语言模型(LLM)主导并影响我们工作方式的时代。即使是专门为编程优化过的本地LLM,也已变得日益高效,让开发者和数据专业人士能够在自己的环境中将其作为个人编程助手。这种方法通常更受欢迎,因为它能够增强数据隐私并降低API成本。

这些本地编程LLM如今拥有了之前不切实际的多种应用,它们将实用的AI辅助直接带入开发者的工作流程。这反过来又实现了行内代码自动补全、代码调试,甚至跨项目推理。如果你对此感兴趣,有许多方法可以在本地运行LLM,欢迎探索。

由于本地编程LLM的兴起,一种名为“Vibe Coding”(氛围编程)的新趋势甚至在非开发者或没有技术背景的人群中流行起来,你可以尝试亲自掌握它。对于数据科学家而言,你也可以了解一些可以用Vibe Coding构建的项目。

随着本地编程LLM变得越来越突出,了解哪些选项可以自行运行会非常有帮助。本文中,我们将探讨一些最适合本地工作流的最佳编程LLM,并重点介绍它们为何脱颖而出。

#1. GLM-4-32B-0414

清华大学旗下的智谱AI最近推出了一系列名为GLM-4-32B-0414的开源模型,这是一个拥有320亿参数的模型,性能可与GPT-4o和DeepSeek-V3媲美。该模型经过15万亿(15T)以推理为核心的数据的广泛预训练,并通过人类偏好对齐、拒绝采样和强化学习进行优化。这有助于模型更好地遵循指令并生成结构良好的输出。

该模型在处理复杂的代码生成、代码分析和函数调用式输出方面表现出色。得益于其训练,它在代码中进行多步推理(例如追踪逻辑或提出改进建议)的能力优于许多规模相似或更大的模型。另一个优势是其相对较大的上下文窗口,高达32k tokens,使得GLM-4能够轻松处理大段代码或多个文件。这对于分析整个代码库或在单次运行中提供全面的重构建议等任务非常有用。

#2. DeepSeekCoder V2

DeepSeekCoder V2是一款基于专家混合系统(Mixture-of-Experts, MoE)的编程LLM,专为编程工作而训练。该模型发布了两个开源权重版本:一个160亿(16B)的“Lite”模型和一个2360亿(236B)的模型。DeepSeekCoder V2模型在DeepSeek-V2的基础上,额外预训练了6万亿(6T)数据,并将语言覆盖范围从86种扩展到338种编程语言。其上下文窗口也扩展至128k tokens,这对于整个项目理解、代码填充和跨文件重构都非常有用。

在性能方面,该模型表现出顶级的成绩,在Aider LLM排行榜上取得了优异分数,使其与高端闭源模型在代码推理方面并驾齐驱。其代码采用MIT许可,模型权重则在DeepSeek的模型许可下可用,允许商业用途。许多人选择在本地运行16B Lite版本,以实现快速代码补全和氛围编程会话,而236B版本则面向多GPU服务器,用于执行繁重的代码生成和项目级推理任务。

#3. Qwen3-Coder

Qwen3-Coder是阿里云通义团队开发的一款专注于代码的LLM,它在7.5万亿(7.5T)数据上进行了训练,其中70%是代码数据。它采用专家混合(MoE)Transformer架构,提供350亿(35B)和4800亿(480B)两个版本。其性能与GPT-4级别和Claude 4 Sonnet的编程能力相媲美,并拥有256k的上下文窗口(通过Yarm技术可扩展至100万tokens)。这使得模型能够在单次会话中处理整个代码仓库和长文件。它还能理解并生成超过350种编程语言的代码,并具备代理式(agentic)编程任务的能力。

480B模型需要H100多GPU或高内存服务器等重型硬件支持,但其MoE设计意味着每个token仅激活部分参数。如果你的硬件要求较低,35B和FP8版本可以在单个高端GPU上本地运行。该模型的权重在Apache 2.0许可下公开可用,使Qwen3-Coder成为一个强大且易于访问的编程助手——从基础编码任务到高级代理任务都能胜任。

#4. Codestral

Codestral是由Mistral AI开发的一款专用代码Transformer模型,针对80多种编程语言的代码生成进行了优化。它推出了220亿(22B)和Mamba 70亿(7B)两个版本,拥有32k的大型上下文窗口。这些模型在相对其规模的情况下,被设计为具有低延迟特性,这在实时编辑时非常有用。权重可在Mistral的非生产许可证下下载(研究/测试免费),商业用途需要单独许可。

对于本地编程而言,22B模型在单张强大GPU上以4/8位量化运行时,足以胜任日常使用并保持快速响应,同时也能处理更大型项目的长代码生成任务。Mistral也提供Codestral API端点服务,但如果你想完全保持本地运行,其开源权重加上常用的推理堆栈已足够强大。

#5. Code Llama

Code Llama是Meta基于Llama模型家族微调而成的编程专用模型,拥有多种规模(70亿、130亿、340亿、700亿参数)和变体(基础版、Python专业版、指令遵循版)。根据不同版本,这些模型在其特定用途上表现可靠,例如代码填充或Python特定任务,即使在非常长的输入(通过长上下文技术可达约100k tokens)下也能稳定运行。所有模型权重均在Meta的社区许可下开放,允许广泛的研究和商业用途。

Code Llama是本地编程代理和IDE代码助手(copilots)的常用基线模型,因为70亿/130亿参数版本可以在单GPU笔记本电脑和台式机上轻松运行(尤其是经过量化后)。相比之下,如果你拥有更多显存,340亿/700亿参数版本能提供更强的准确性。凭借多种版本,它具有广泛的应用可能性——例如,Python模型非常适合数据和机器学习工作流,而指令遵循版本则在编辑器中的对话式和氛围编程流程中表现出色。

#总结

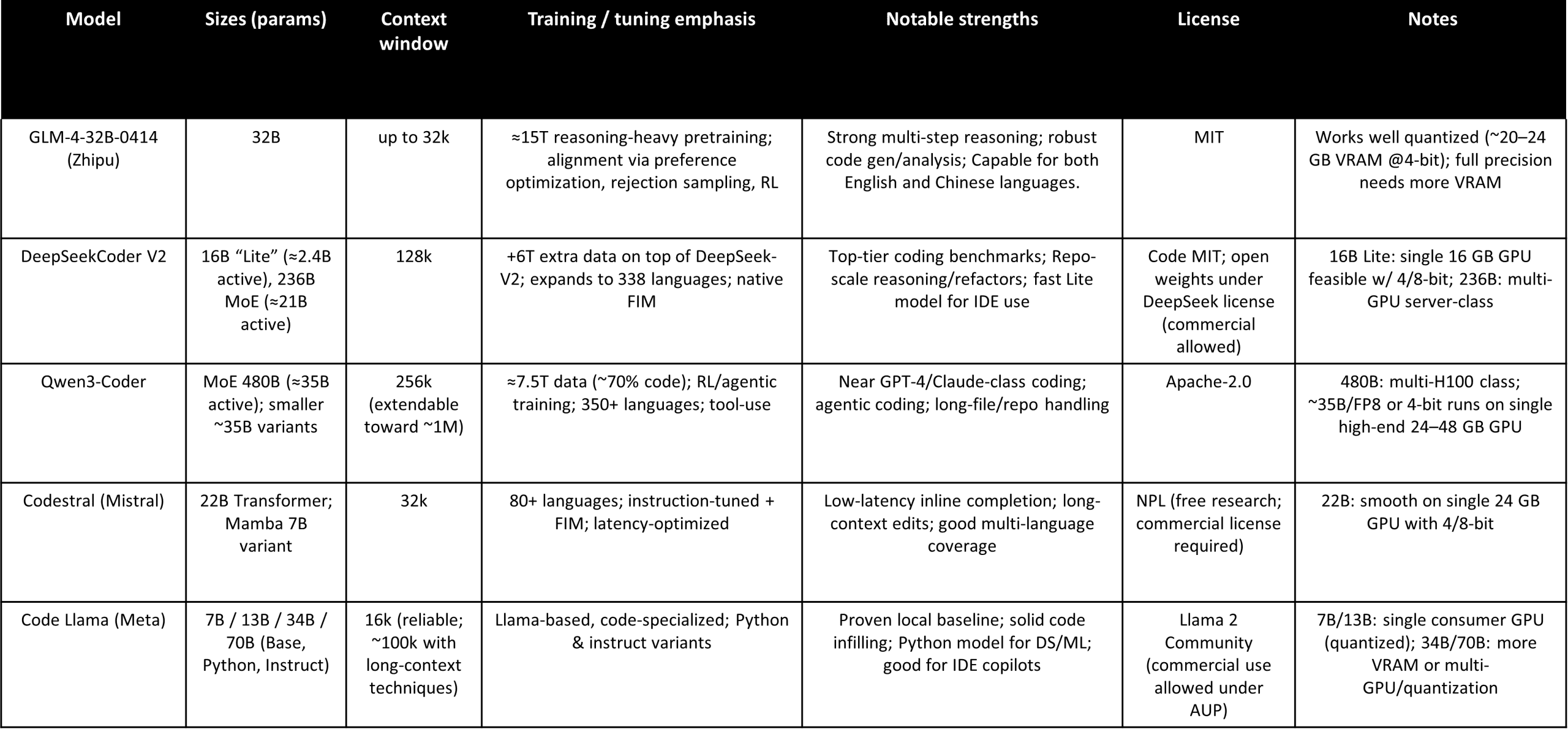

作为对以上讨论内容的参考,以下是所涵盖模型的整体比较。

点击放大

根据你的需求和本地性能,这些模型可以有效支持你的工作。

希望本文对你有所帮助!