自 ChatGPT 发布以来,“规模化”或许已成为大语言模型领域最重要的关键词。ChatGPT 之所以如此成功,很大程度上得益于 OpenAI 在预训练阶段的大规模投入,使其成为一个强大的语言模型。

随后,前沿的 LLM 实验室开始规模化后训练,通过监督微调和 RLHF 等技术,使模型在遵循指令和执行复杂任务方面表现越来越出色。

就在人们认为 LLM 即将进入平台期时,推理模型的出现开启了推理时规模化的新阶段,通过投入“思考 token”显著提升了输出质量。

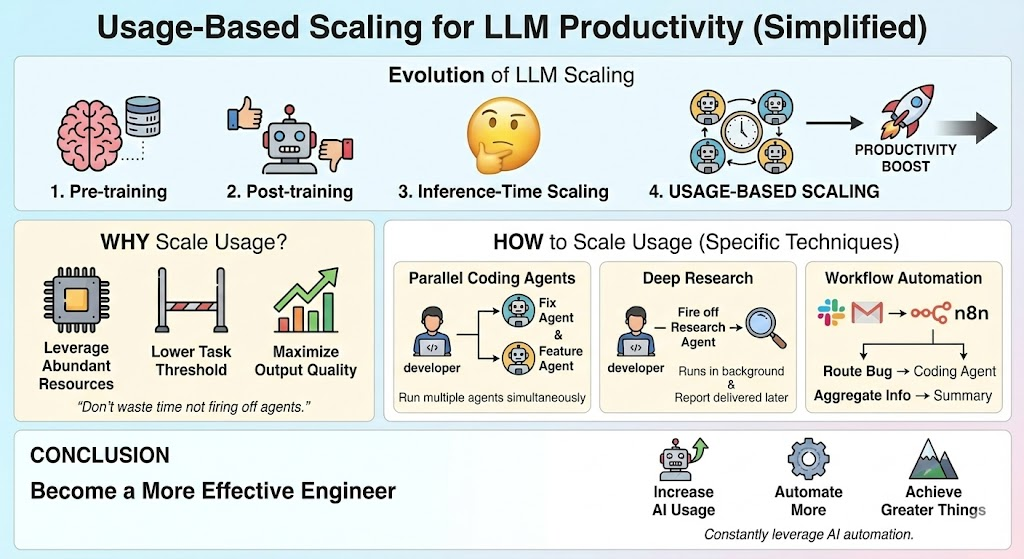

这张信息图概括了本文的核心内容。首先将探讨为何应该规模化使用 LLM,重点分析其如何提升生产力。接着将具体介绍提高 LLM 使用量的方法,包括运行并行编码智能体和使用 Gemini 3 Pro 的深度研究模式等技巧。图片由 Gemini 生成

现在需要提出一种新的规模化范式:使用量规模化,即通过增加 LLM 的使用频率来实现规模化:

- 并行运行更多编码智能体

- 对感兴趣的主题启动深度研究

- 执行信息获取工作流

如果午休或睡前没有启动智能体执行任务,就是在浪费时间

本文将深入分析规模化使用 LLM 如何提升生产力,特别针对程序员群体。同时将探讨具体的技术方法,帮助个人和企业实现 LLM 使用量的规模化。本文将从宏观视角出发,旨在启发读者如何最大化利用人工智能的优势。

为何需要规模化使用 LLM

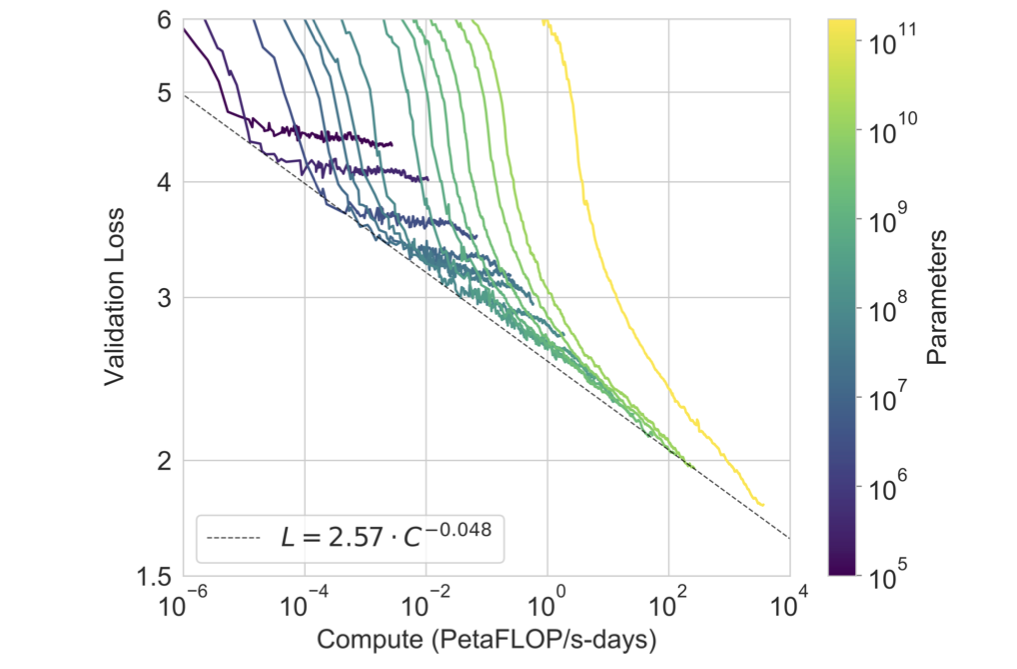

既往经验已经证明了规模化的强大效果:

- 预训练规模化

- 后训练规模化

- 推理时规模化

其核心原理在于:对某项任务投入的计算资源越多,输出质量就越高。当然,这需要确保计算资源得到有效利用。以预训练为例,实现计算规模化需要满足:

- 足够大的模型(充足的权重参数)

- 充足的训练数据

若缺乏这两个要素,单纯增加计算资源并不会带来改进。但当三者同时规模化时,就能获得惊人成果,例如当前前沿的 LLM 模型,包括最新发布的 Gemini 3。

因此,建议尽可能规模化使用 LLM。具体实践可以包括同时启动多个编码智能体并行工作,或针对感兴趣的主题开启 Gemini 深度研究功能。

当然,这些使用必须产生实际价值。启动智能体处理无关紧要的任务毫无意义。更合理的做法是让编码智能体处理:

- 那些一直没时间处理的线性问题

- 最近销售会议中提出的快速功能需求

- 当前编码智能体能够轻松处理的界面优化任务

此图展示了规模化定律,说明通过增加规模如何提升性能。规模化使用 LLM 同样遵循这一规律。图片来自NodeMasters。

在资源充裕的环境中,我们应该最大化资源利用率

核心观点是:自 LLM 问世以来,执行任务的门槛已显著降低。以往处理错误报告时,需要集中精力花费两小时深入思考解决方案。

而现在情况完全不同。只需在 Cursor 中输入错误报告,要求 Claude Sonnet 4.5 尝试修复,十分钟后返回测试问题是否解决,然后创建拉取请求即可。

关键在于:在保证 token 产生实际价值的前提下,能使用多少 token

实现 LLM 使用规模化的方法

前文阐述了通过运行更多编码智能体、深度研究智能体及其他 AI 智能体来实现 LLM 使用规模化的必要性。但具体应该启动哪些 LLM 任务可能令人困惑。本节将详细讨论可用于规模化使用 LLM 的具体智能体类型。

并行编码智能体

对程序员而言,并行编码智能体是实现 LLM 使用规模化最直接的方式。通过同时启动两个或多个智能体,使用 Cursor 智能体、Claude Code 或其他编码工具,可以并行处理多个任务。利用 Git worktrees 可以轻松实现这一过程。

例如,通常会有正在专注处理的主任务或项目。当收到错误报告时,可以自动将其路由给 Claude Code,让其搜索问题原因并尝试修复。有时能立即解决问题,有时则需要人工辅助。

启动这种错误修复智能体的成本极低(只需将 Linear 问题复制到 Cursor,后者可通过 Linear MCP 读取问题)。此外,还可以设置自动研究相关潜在客户的脚本在后台运行。

深度研究

深度研究是 Google Gemini、OpenAI ChatGPT 和 Anthropic Claude 等前沿模型提供商都提供的功能。虽然有许多优秀的深度研究工具,但更推荐 Gemini 3 的深度研究功能。

当需要深入了解某个主题、查找信息或进行类似研究时,可以启动 Gemini 的深度研究智能体。

例如,需要根据特定理想客户画像寻找潜在客户时,只需将 ICP 信息粘贴到 Gemini,提供相关背景信息,即可启动研究流程。这样在研究进行的同时,可以继续处理主要编程项目。

20 分钟后,就能获得包含大量有用信息的简要报告。

使用 n8n 创建工作流

另一种规模化使用 LLM 的方法是利用 n8n 或类似的工作流构建工具创建自动化流程。通过 n8n 可以构建特定工作流,例如读取 Slack 消息并根据消息内容执行相应操作。

可以设置这样的工作流:读取 Slack 上的错误报告群组,针对每个错误报告自动启动 Claude Code 智能体。或者创建另一个工作流,从多个来源聚合信息并以易读格式呈现。使用工作流构建工具的可能性几乎是无限的。

其他方法

还有许多其他技术可以帮助规模化使用 LLM。这里列出的只是在 LLM 工作中最先想到的几个方法。建议始终关注可以使用 AI 自动化哪些任务,以及如何利用 AI 提高效率。规模化使用 LLM 的具体方法会因公司、职位和许多其他因素而有很大差异。

结论

本文探讨了如何通过规模化使用 LLM 来提升工程师的工作效率。规模化在过往实践中已证明其强大效果,通过规模化使用 LLM 也很可能获得更显著的效果。具体方法包括并行运行更多编码智能体、在午休时运行深度研究智能体等。总体而言,增加 LLM 的使用量能够有效提升生产力水平。

社交媒体联系方式:

社交媒体联系方式: